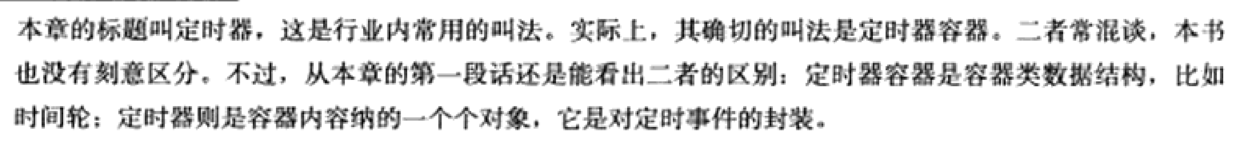

Linux C 知识点笔记

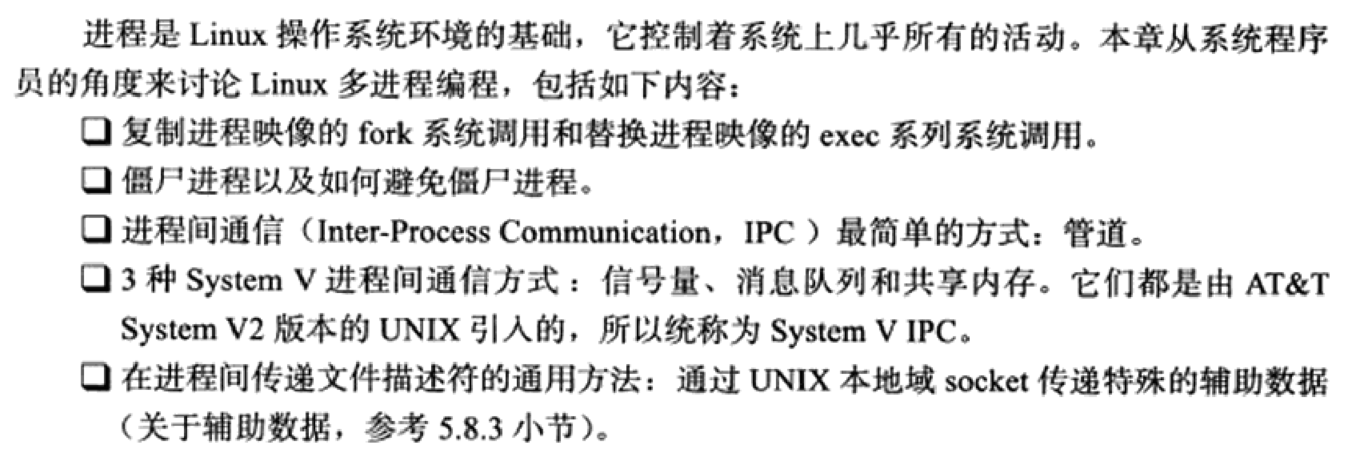

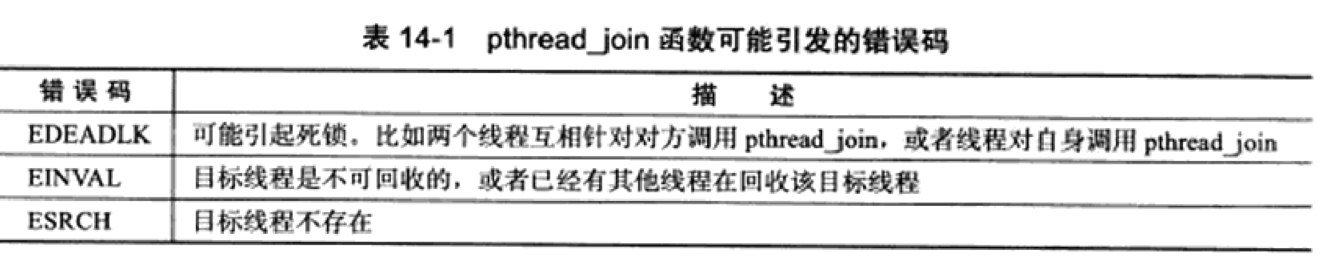

1. 可变长的参数列表

-

首先说明一下函数参数传递的原理:

-

函数参数是以栈的形式存取,从右至左入栈。

-

参数的内存存放格式:参数存放在内存的堆栈段中,在执行函数的时候,从最后一个最开始入栈。因此栈底高地址,栈顶低地址,举个例子如下:

-

1void func(int x, float y, char z); -

调用函数的时候,实参 char z 先进栈,然后是 float y,最后是 int x,因此在内存中变量的存放次序是 x->y->z。从理论上说,我们只要探测到任意一个变量的地址,并且知道其他变量的类型,通过指针移位运算,则总可以顺藤摸瓜找到其他的输入变量。

-

-

需要注意的是,这种参数入栈的顺序可能受到编译器、操作系统和函数调用约定的影响。不同的编译器和操作系统可能采用不同的参数传递方式(如寄存器传递、栈传递等),所以具体的实现细节可能会有所不同。但是,通常情况下,函数参数是按照从右到左的顺序在栈中入栈的。

-

-

C语言可创建接收参数个数不确定的函数。如常用的标准库函数printf就是一个接收参数个数可变的函数。函数printf至少要接收一个字符串作为它的第一个实参。但事实上,printf还能够接收任意数目的其他实参。printf的函数原型是:

int printf(const char *format, ...);

其中的省略号(…)表示这个函数可以接收可变数目的各种类型的实参。

需要注意:这个省略号必须放在形参列表的末尾。

可变参数头文件

<stdarg.h>中的宏和定义,为创建一个可变长参数列表的函数提供了必须的功能。stdarg.h可变长参数列表类型和宏。

-

标识符 说明 va_list 该类型适合于保存宏va_start、va_arg、和va_end所需的信息。为了访问到一个可变长参数列表中的参数,必须定义一个类型为va_list的对象。本质就是一个指针。 va_start 在一个可变长参数列表中的参数被访问前,先调用这个宏。这个宏将初始化用va_list声明的对象,以供va_arg和va_end使用。作用是使得va_list对象指向可变参数表里面的第一个参数。 va_arg 这个宏展开成一个表示可变长参数列表中下一个参数的值的表达式,值的类型由宏的第二个参数决定。每次对va_arg的调用都要修改用va_list声明的对象,以使这个对象指向列表中的下一个实参 va_end 释放指针,将输入的参数 ap 置为 NULL。通常va_start和va_end是成对出现。 va_copy 制作可变参数函数参数(函数宏)的副本(不常用) -

使用上面的宏获取参数的步骤如下:

<Step 1> 定义一个 va_list 类型的变量,(假设va_list 类型变量被定义为ap); <Step 2> 调用va_start ,对ap 进行初始化,让它指向可变参数表里面的第一个参数。

<Step 3> 获取参数,并使用参数。

<Step 4> 获取所有的参数之后,将 ap 指针关掉。

-

示例

-

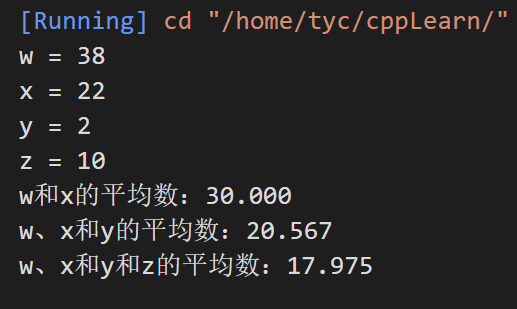

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28#include <stdarg.h> #include <stdio.h> double average(int i, ...) { double total = 0; va_list ap; // 指向传入的第一个可选参数 va_start(ap, i); for (int j = 1; j <= i; ++j) { total += va_arg(ap, double); } va_end(ap); return total / i; } int main() { double w = 37.5; double x = 22.5; double y = 1.7; double z = 10.2; printf("w = %.lf\nx = %.lf\ny = %.lf\nz = %.lf\n", w, x, y, z); printf( "w和x的平均数:%.3f\nw、x和y的平均数:%.3f\nw、x和y和z的平均数:%.3f\n", average(2, w, x), average(3, w, x, y), average(4, w, x, y, z)); } -

-

值得注意的是,C++11在标准库中提供了

initializer_list类,用于处理参数数量可变但是类型相同的情况。 -

需要说明的是,C++还有可变参数模板 Variadic Template。

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26#include <bits/stdc++.h> using namespace std; // 定义 void print() {} //为了结束递归 template <typename T, typename... Types> void print(T firstArg, Types... args) { std::cout << firstArg << '\n'; // print first argument print(args...); // call print() for remaining arguments } int main() { string s("hello!"); // 使用 print(7.5, "fff", 9, s); return 0; } /*输出结果 7.5 fff 9 hello!

2. vsnprintf 函数

-

vsnprintf函数用于将一组变长参数格式化为一个字符串,并将其存储到一个字符缓冲区buffer中。

-

与sprintf()函数不同的是,vsnprintf()函数使用一个va_list参数,该参数包含要格式化的变长参数列表。这使得vsnprintf()函数更加灵活,可以根据需要在运行时传递变长参数列表,而不需要在编译时指定参数类型和数量。

-

示例

-

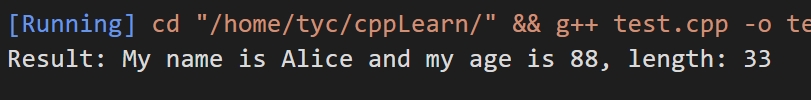

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20#include <stdarg.h> #include <stdio.h> void my_printf(const char *str, ...) { char buffer[100]; int len; va_list args; va_start(args, str); // 返回长度,最后自动添加 '\0' 表示结束,这不算在长度里面 len = vsnprintf(buffer, sizeof(buffer), str, args); va_end(args); printf("Result: %s, length: %d\n", buffer, len); } int main() { my_printf("My name is %s and my age is %d", "Alice", 88); return 0; } -

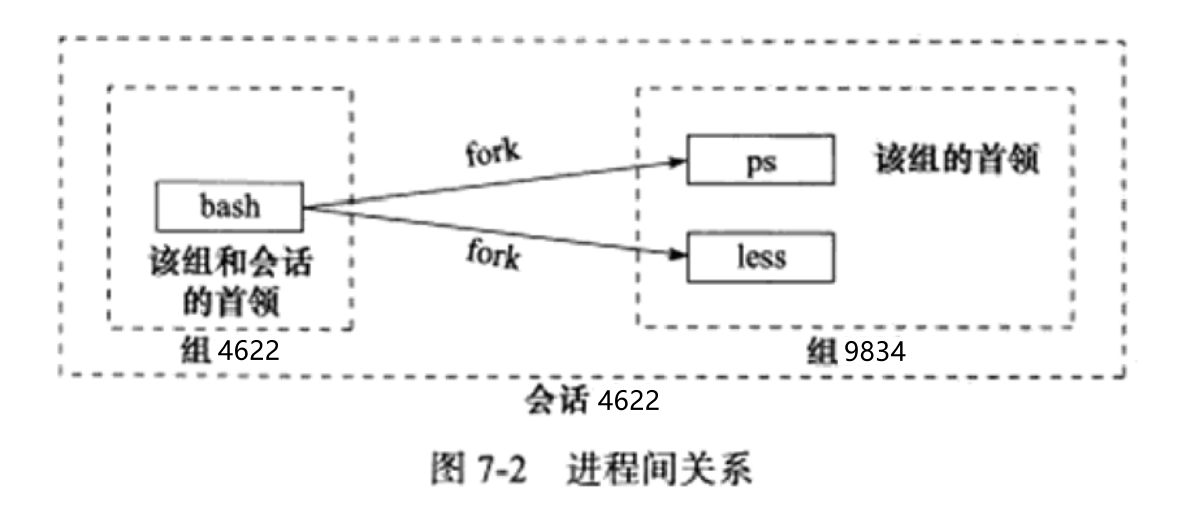

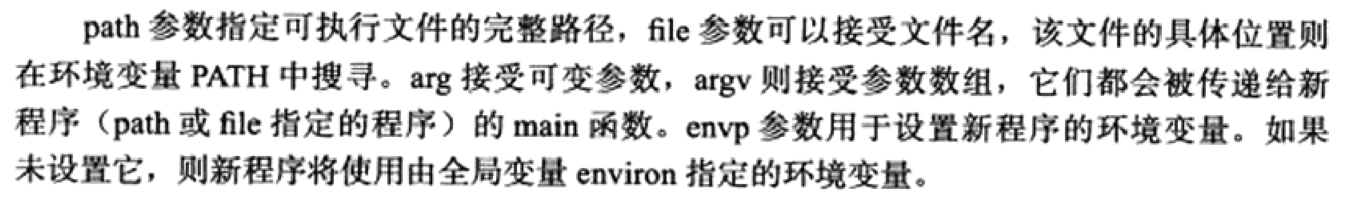

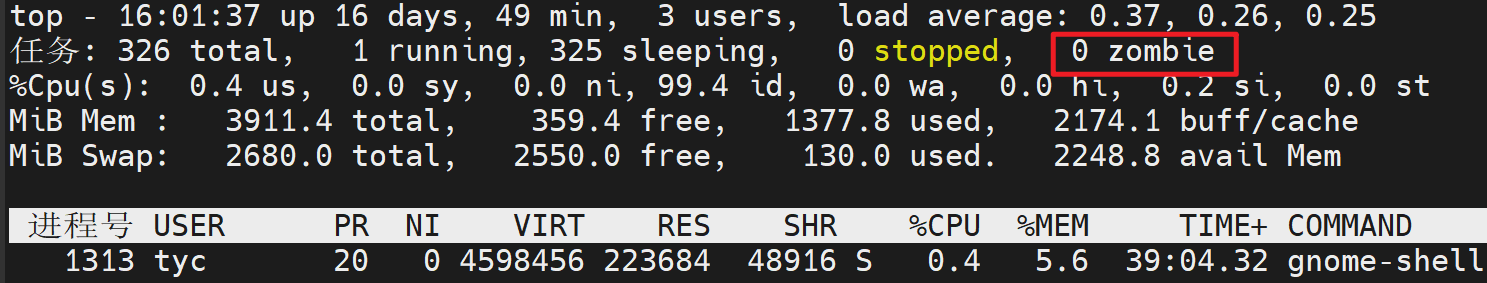

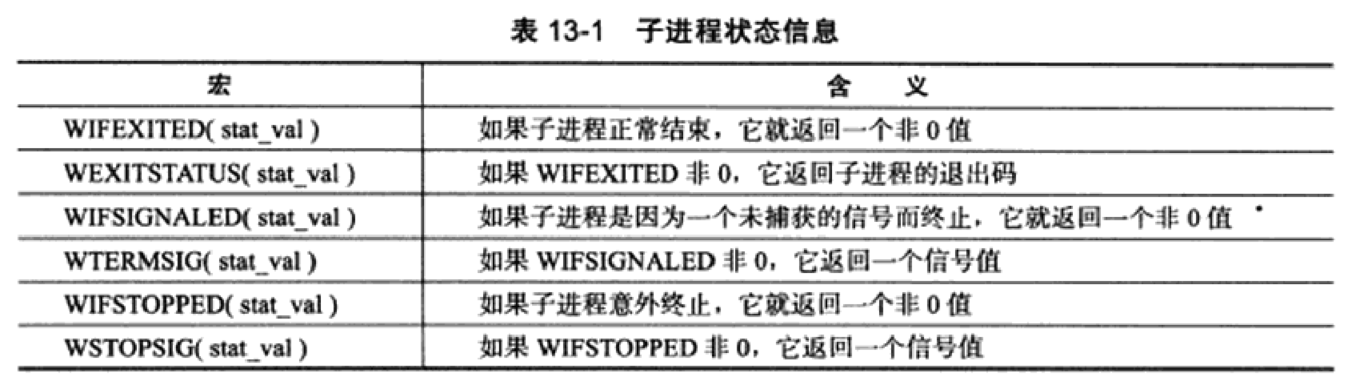

3. fork函数

-

fork系统调用用于创建一个新进程,称为子进程,它与进程(称为系统调用fork的进程)同时运行,此进程称为父进程。创建新的子进程后,两个进程将执行fork()系统调用之后的下一条指令。子进程使用相同的pc(程序计数器),相同的CPU寄存器,在父进程中使用的相同打开文件。

它不需要参数并返回一个整数值。下面是fork()返回的不同值。

负值:创建子进程失败。

零:返回到新创建的子进程。

正值:返回到父进程或调用者。返回值为新创建的子进程的进程ID 。

-

有两个注意点

- fork()系统调用是Unix下以自身进程创建子进程的系统调用,一次调用,两次返回,如果返回是0,则是子进程,如果返回值>0,则是父进程(返回值是子进程的pid),这是众为周知的。

- 还有一个很重要的东西是,在fork()的调用处,整个父进程空间会原模原样地复制到子进程中,包括指令,变量值,程序调用栈,环境变量,缓冲区,等等。

-

示例1

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30#include <stdio.h> #include <stdlib.h> #include <unistd.h> #include <sys/types.h> #include <sys/wait.h> int main(void) { int x = 2; printf("hello world (pid:%d)\n", (int)getpid()); int rc = fork(); if (rc < 0) { fprintf(stderr, "fork failed\n"); exit(1); } else if (rc == 0) { // 子进程 x++; printf("hello, I am child (pid:%d)\n", (int)getpid()); printf("x = %d\n", x); } else { x--; printf("hello, I am parent of %d (pid:%d)\n", rc, (int)getpid()); printf("x = %d\n", x); } printf("pid = %d\n", (int)getpid()); printf("x = %d\n", x); wait(NULL); return 0; } -

输出结果为

-

1 2 3 4 5 6 7 8 9hello world (pid:2486) hello, I am parent of 2487 (pid:2486) x = 1 hello, I am child (pid:2487) x = 3 pid = 2487 x = 3 pid = 2486 x = 1 -

从结果可以看到,返回值就是子进程id,且从fork后开始,子进程和父进程的执行代码是一样的,变量也是一样的,但是两者之间并不共享,而是各自独立的变量。

-

示例2

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18#include <stdio.h> #include <stdlib.h> #include <unistd.h> #include <sys/types.h> #include <sys/wait.h> int main(void) { int i; for (i = 0; i < 2; i++) { fork(); printf("g"); } wait(NULL); wait(NULL); return 0; } -

问题是:以上程序会输出多少个 “g”。

-

实际结果是8个,而不是6个。

-

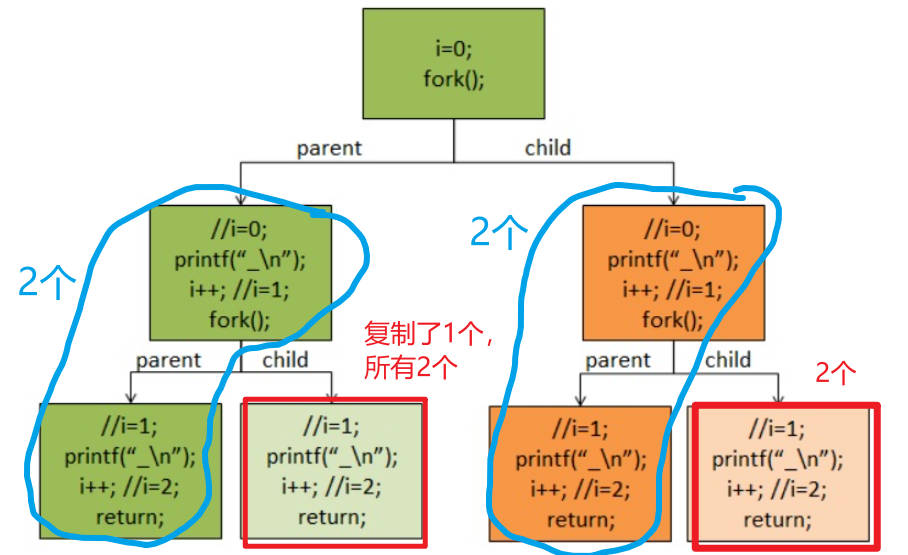

可以借以下这张图解释一下。i=0,创建了一个子进程,此时共两个进程,输出2个g;i=1,再次创建,变成4个进程,按理论是输出4个g;i=2,结束。

-

可以看到,理论上应该输出2+4=6个g。

-

-

但实际是8个。

-

输出8个的原因,是因为因为printf(“g“);语句有buffer,所以,对于上述程序,printf(“g“);把“g”放到了缓存区中,并没有真正的输出。

-

而从上面所讲,子进程会把父进程的缓冲区内存也复制一份。

-

在fork的时候,缓存被复制到了子进程空间,所以,就多了两个,就成了8个,而不是6个。

-

-

我们知道,Unix下的设备有“块设备”和“字符设备”的概念。

所谓块设备,就是以一块一块的数据存取的设备,字符设备是一次存取一个字符的设备。

磁盘、内存都是块设备,字符设备如键盘和串口。块设备一般都有缓存,而字符设备一般都没有缓存。

-

对于上述的问题,我们如果修改一下上面的printf的那条语句为:

-

1 2 3 4printf("g\n"); // 或者 printf("g"); fflush(stdout); -

就会按我们所想输出6个g字符了。

-

因为程序遇到“\n”,或是EOF,或是缓中区满,或是文件描述符关闭,或是主动flush,或是程序退出,就会把数据刷出缓冲区。

-

需要注意的是,标准输出是行缓冲,所以遇到“\n”的时候会刷出缓冲区;

-

但对于磁盘这个块设备来说,“\n”并不会引起缓冲区刷出的动作,那是全缓冲,你可以使用setvbuf来设置缓冲区大小,或是用fflush刷缓存。

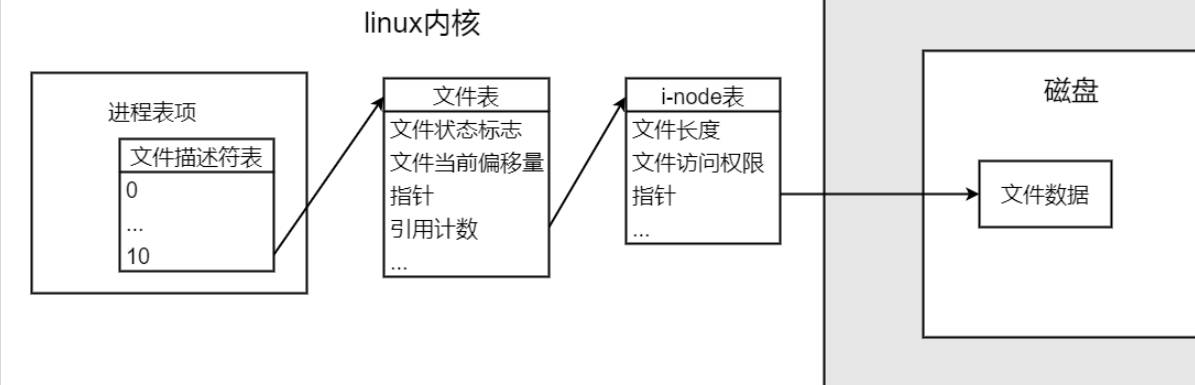

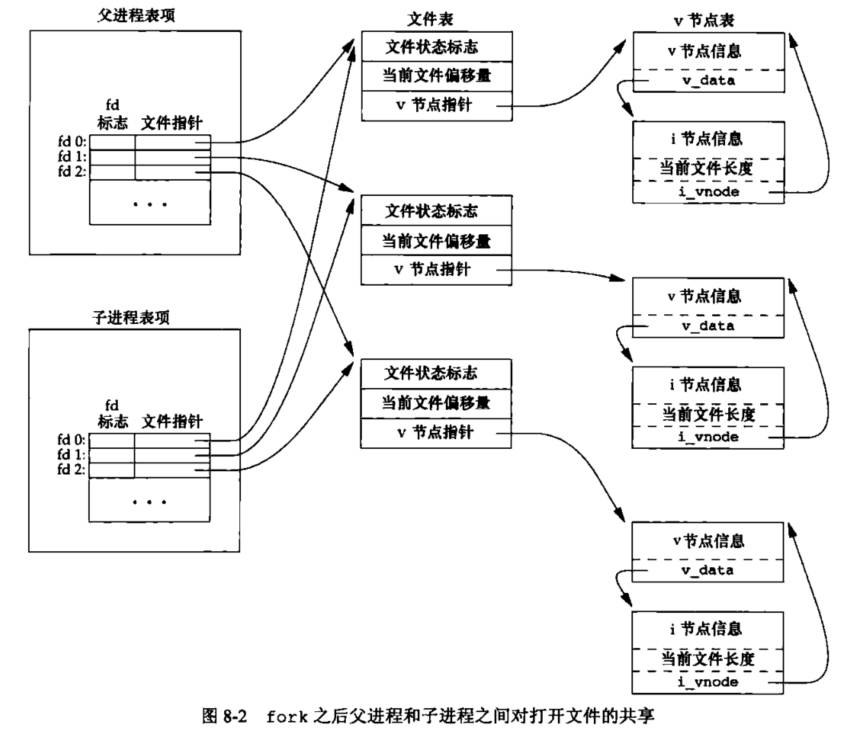

4. linux内核之文件描述符表、文件表、索引结点(i-node)表

-

-

这里以《UNIX环境高级编程》的设计阐述。

-

unix内核使用3种数据结构表示打开文件。

-

(1)每个进程都有一个进程表,进程表有一张文件描述符表,表的每一项代表了一个打开的文件。表项中包含的内容如下

- a.文件描述符 fd。

- b.指向一个文件表项的指针。

-

(2)内核为所有打开文件维持一张文件表。每个文件表项包含:

- a.文件状态标志(读、写、添写、同步和非阻塞等)。

- b.当前文件偏移量。

- c.指向该文件v节点表项的指针。

-

(3)每个打开文件(或设备)都有一个v节点(v-node)表,每个v节点结构包含:

- a.文件类型。

- b.对文件的各种操作函数指针。

- c. i节点(索引结点(i-node))(对于大多数文件)。

-

对于Linux系统,没有使用v节点,而是通用了i节点结构。

-

-

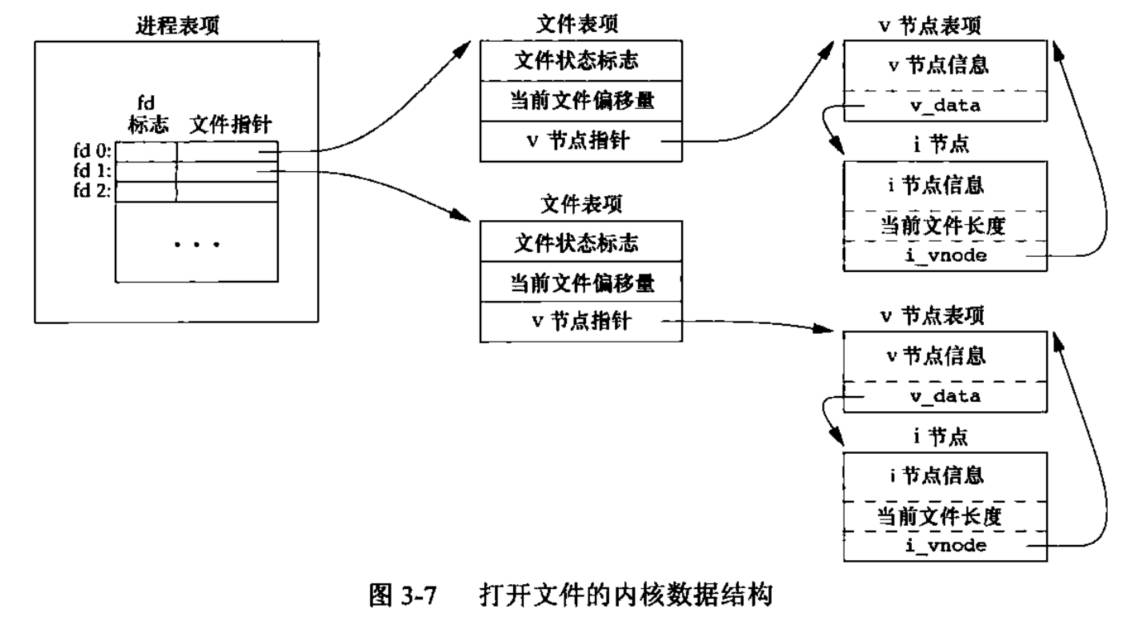

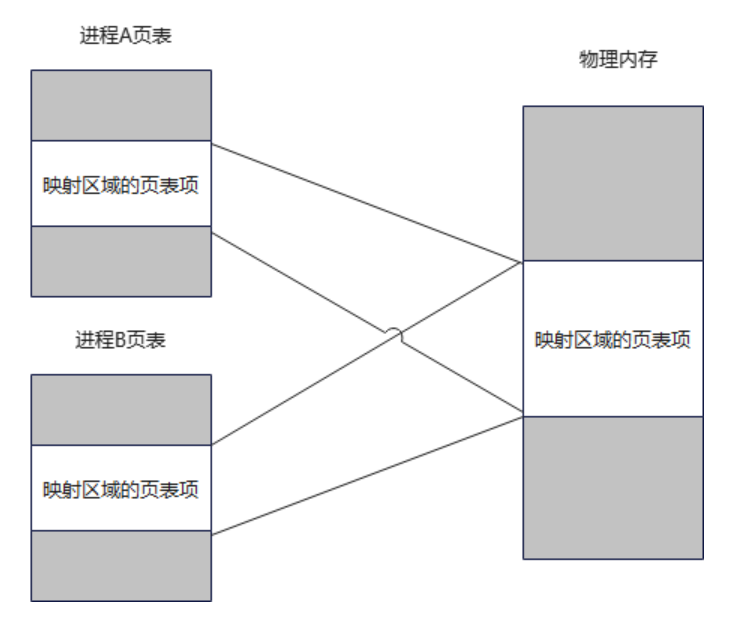

对于不同的进程,如果打开了同一个文件,结构如下图所示,此时的文件表项是不一样的,两者的文件偏移指针不共享。

-

-

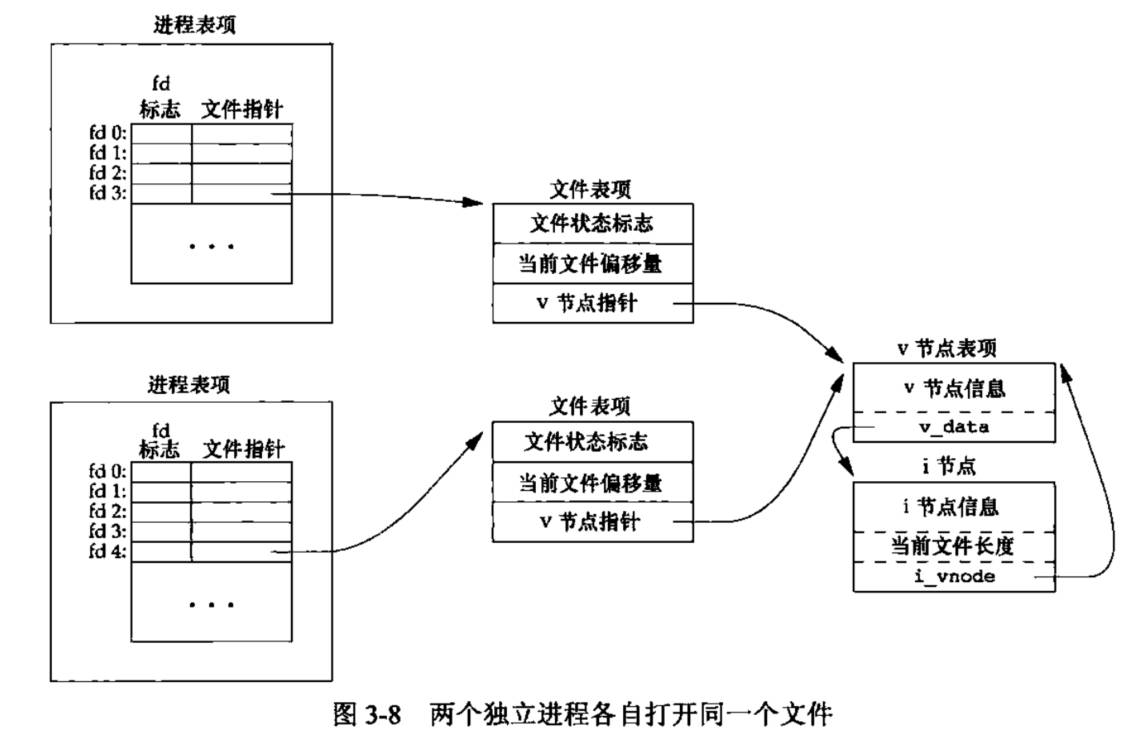

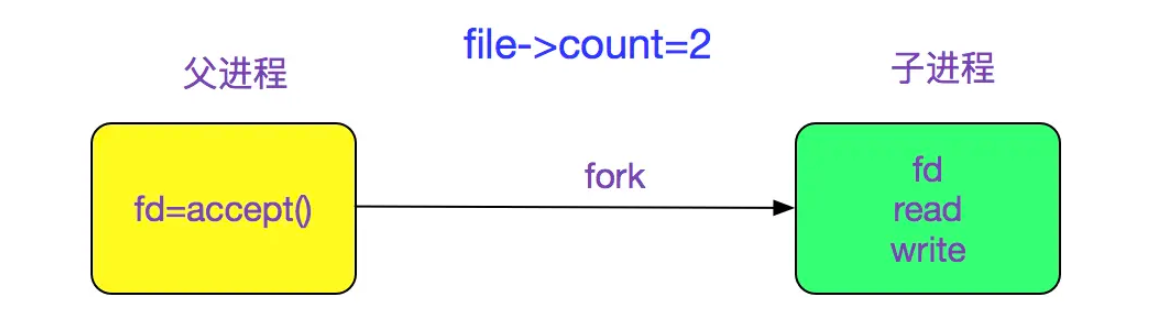

但是如果调用dup函数或者fork函数,则父、子进程的每一个打开文件描述符都共享同一个文件表项。

-

-

可以看到fork后的子进程只是复制了父进程的文件描述符表,但是指向同一个文件表,两者的指针偏移是共用的。

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26#include <fcntl.h> #include <stdio.h> #include <sys/types.h> #include <unistd.h> int main() { int fd1, fd2, fd3, nr; char buff[20]; pid_t pid; fd1 = open("data.in", O_RDWR); pid = fork(); if (pid == 0) { // 子进程 nr = read(fd1, buff, 10); buff[nr] = '\0'; printf("child pid#%d content#%s#\n", getpid(), buff); close(fd1); exit(0); } wait(NULL); nr = read(fd1, buff, 10); buff[nr] = '\0'; printf("paren pid#%d content#%s#\n", getpid(), buff); close(fd1); return 0; } -

输出结果

-

1 2 3 4 5 6 7data.in文件 abcdefghijklmnopqrstuvwxyz1234567890 EOF // 输出结果 child pid#3205 content#abcdefghij# paren pid#3204 content#klmnopqrst# -

可以看到,父进程读取内容是子进程读取完后的偏移位置开始读取。

5.C++中NULL和nullptr的区别

-

在编写C程序的时候只看到过NULL,而在C++的编程中,我们可以看到NULL和nullptr两种关键字,其实nullptr是C++11版本中新加入的,它的出现是为了解决NULL表示空指针在C++中具有二义性的问题。

-

在C语言中,NULL通常被定义为:

1#define NULL ((void *)0) -

如果在C语言中写入以下代码,编译是没有问题的,因为在C语言中把空指针赋给int和char指针的时候,发生了隐式类型转换,把void指针转换成了相应类型的指针。

-

1 2int *pi = NULL; char *pc = NULL; -

但是问题来了,以上代码如果使用C++编译器来编译则是会出错的,因为C++是强类型语言,void*是不能隐式转换成其他类型的指针的,所以实际上为了能编译通过,编译器提供的头文件做了如下的处理:

-

1 2 3 4 5#ifdef __cplusplus #define NULL 0 #else #define NULL ((void *)0) #endif -

可见,在C++中,NULL实际上是0。因为C++中不能把void*类型的指针隐式转换成其他类型的指针,所以为了结果空指针的表示问题,C++引入了0来表示空指针,这样就有了上述代码中的NULL宏定义。

-

但是这样用NULL代替0表示空指针在函数重载时会出现问题,也就产生了**二义性问题。**如下所示。

-

1 2 3 4 5 6 7 8 9 10#include <iostream> using namespace std; void func(char *ptr) { cout << "Char pointer version\n"; } void func(int ptr) { cout << "int version\n"; } int main() { func(NULL); // 无法通过编译,可能导致二义性 func(nullptr); // 仅调用char*版本 return 0; } -

为解决NULL代指空指针存在的二义性问题,在C++11版本(2011年发布)中特意引入了nullptr这一新的关键字来代指空指针,从上面的例子中我们可以看到,使用nullptr作为实参,确实选择了正确的以char *ptr作为形参的函数版本。

-

总结

-

NULL:NULL是C++中早期版本用于表示空指针的宏,通常被定义为0或者((void*)0)。- 在C++11之前,

NULL是主要用于表示空指针的方法。 - 由于历史原因,

NULL存在一些潜在的问题。例如,如果函数期望一个指针参数,传递NULL可能导致歧义,因为它实际上可以被解释为整数0。

-

nullptr:nullptr是C++11引入的新特性,专门用于表示空指针。它是一种空指针常量,具有自己的类型std::nullptr_t。nullptr解决了一些NULL可能引起的歧义问题。它是类型安全的,不会被隐式转换为整数类型,从而减少了一些潜在的错误。- 推荐在新的C++代码中使用

nullptr而不是NULL。

vim 分屏技巧

-

分屏,命令模式下

-

:sp水平分屏 -

:vsp竖直分屏 -

分屏命令+filename,分屏并打开这个文件 -

分屏后屏幕切换,

Ctrl+w+w -

使用

:q退出光标所在窗口 -

使用

:qall退出所有窗口 -

从shell启动vim打开多个文件并分屏显示:

1 2 3 4 5vim -on file1 file2 o为小写字母,水平分割,即上下分屏,n是分屏的个数(可缺省),后面是待打开的文件 vim -On file1 file2 O为大写字母,垂直分割,即左右分屏,n是分屏的个数(可缺省),后面是待打开的文件在已经打开的vim中对文件进行分屏

1 2 3 4 5 6 7 8 9 10 11 12 13对光标所在的窗口进行上下分屏 :sp [file2] 或者 :split [file2] ctrl + w s # 后面不跟文件名是将当前文件垂直分屏;跟文件名是将新文件在垂直分屏中打开 对光标所在的窗口进行左右分屏 :vsp [file2] 或者 :vsplit [file2] ctrl + w v # 创建空白分屏 :new [file2]不同窗口间的移动(可直接Ctrl + w + w 自动切换到另一个分屏)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15移动到光标左边的窗口 ctrl + w h ctrl + w ← 移动到光标上边的窗口 ctrl + w k ctrl + w ↑ 移动到光标下边的窗口 ctrl + w j ctrl + w ↓ 移动到光标右边的窗口 ctrl + w l ctrl + w →关闭当前窗口

1 2 3 4 5 6 7 8 9ctrl + w c (不能用于最后一个分屏) ctrl + w q (可用于最后一个分屏) :q #取消其它分屏,只保留当前分屏 :only #关闭所有分屏 :qa

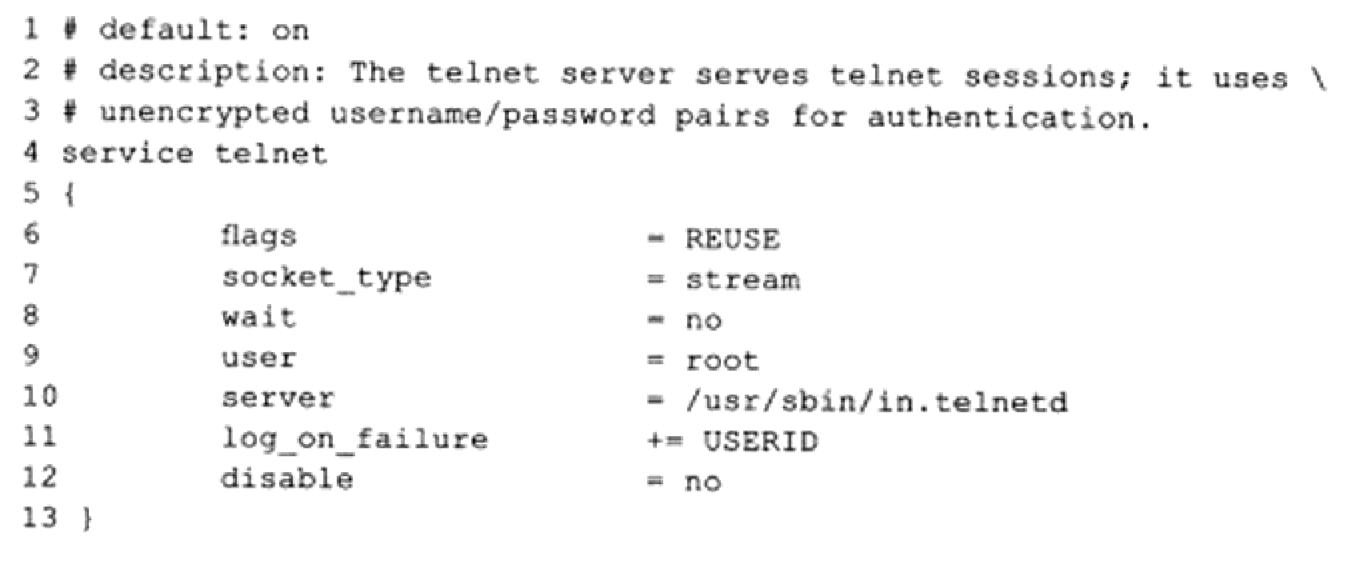

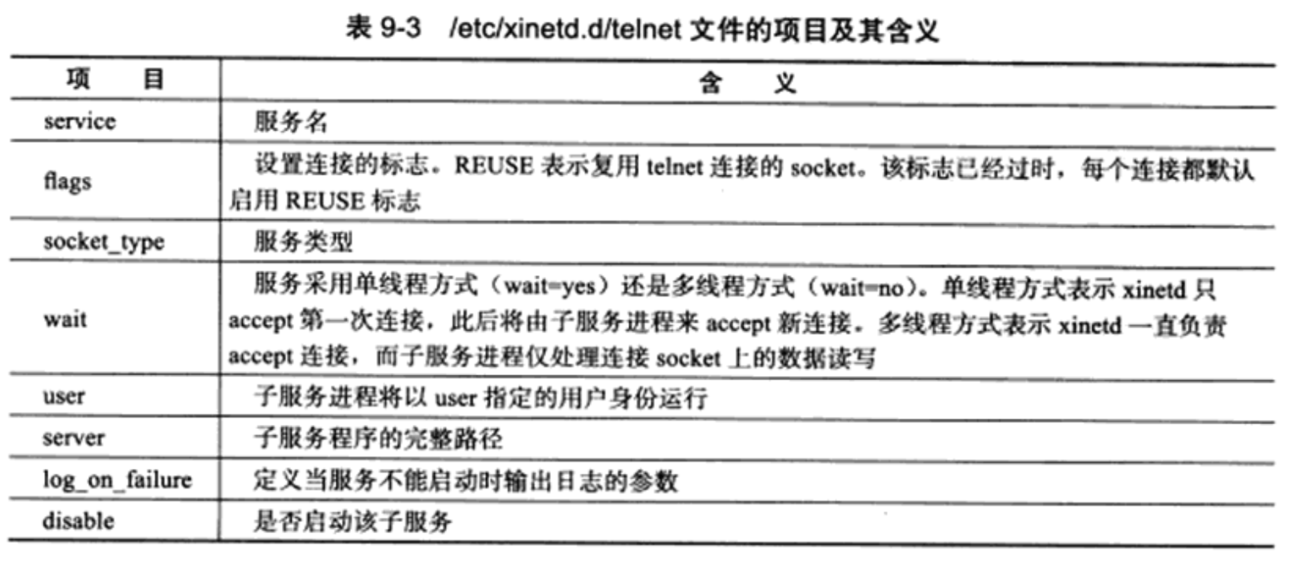

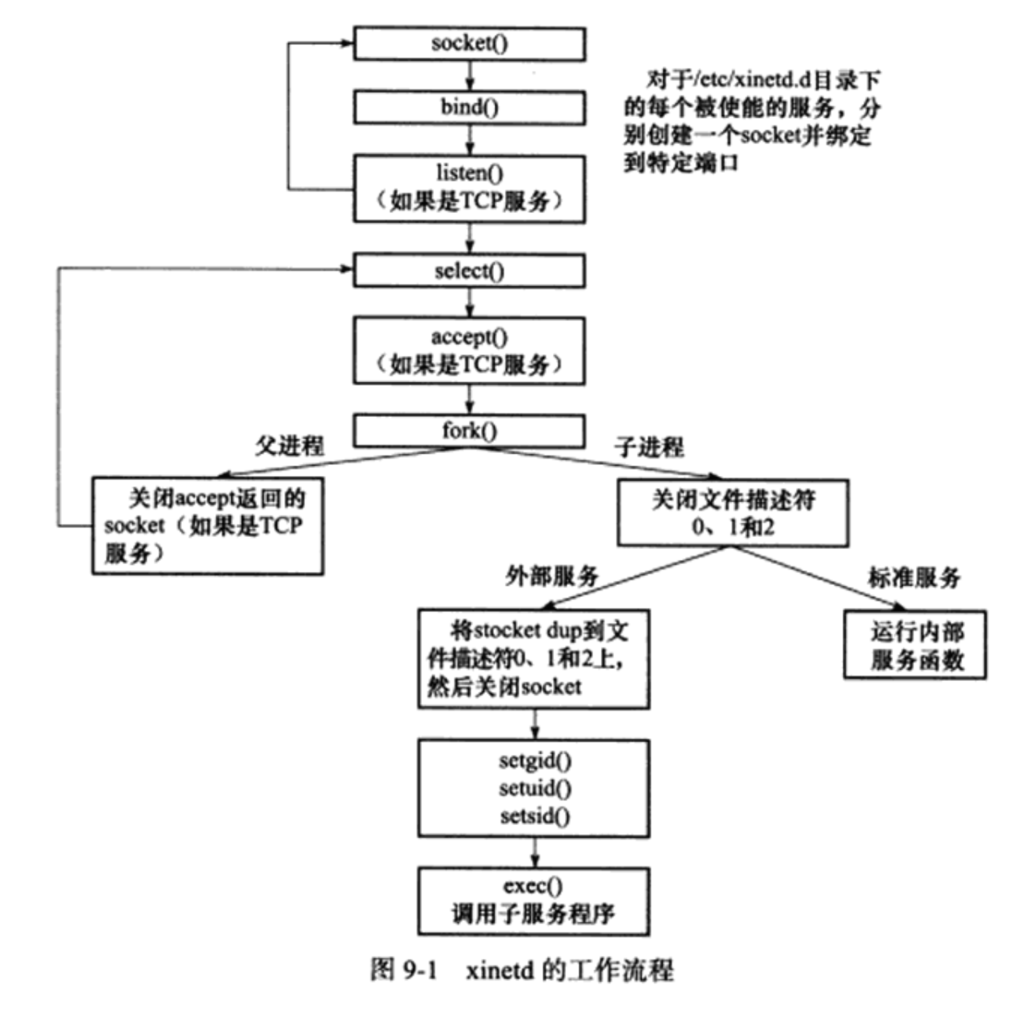

Linux 开启telnet服务

-

1.安装telnet服务,yum -y 表示自动选择yes,不用手动写。

1yum install xinetd telnet telnet-server -y -

2.设置开机自启动

1 2 3# 这两条命令设置开机时自动启动telnet服务 systemctl enable telnet.socket systemctl enable xinetd -

3.启动telnet服务

1 2 3# 启动telnet服务 systemctl start telnet.socket systemctl start xinetd -

4.查看状态

1 2 3# 查看telnet服务的状态 systemctl status telnet.socket systemctl status xinetd -

5.关闭telnet服务

1 2 3 4systemctl stop telnet.socket systemctl stop xinetd firewall-cmd --remove-service=telnet --permanent # 防火墙不开放telnet服务端口 firewall-cmd --reload -

6.参考

-

7.参考

C语言坑点

1.隐式函数声明:

-

在C语言中,函数在调用前不一定非要声明。如果没有声明,那么编译器会自己主动依照一种隐式声明的规则,为调用函数的C代码产生汇编代码。以下是一个样例:

1 2 3 4 5int main(int argc, char** argv) { double x = any_name_function(); return 0; }单纯的编译上述源代码。并没有不论什么报错,仅仅是在链接阶段由于找不到名为any_name_function的函数体而报错。

1 2 3 4 5[smstong@centos192 test]$ gcc -c main.c [smstong@centos192 test]$ gcc main.o main.o: In function `main': main.c:(.text+0x15): undefined reference to `any_name_function' collect2: ld 返回 1之所以编译不会报错,是由于C语言规定,对于没有声明的函数,自己主动使用隐式声明。

-

但注意,编译器自动声明的函数返回值类型只能是

int,换言之,如果静态库的函数返回值不是int,最后结果会出错,尽管程序运行没问题。 -

因此编译静态库,一般会把函数声明在自带的静态库头文件里面,以能够更好的编译通过。

2.段错误

-

段错误就是指访问的内存超出了系统所给这个程序的内存空间。

-

在编程中以下几类做法容易导致段错误,基本上是错误地使用指针引起的。

1)访问系统数据区,尤其是往系统保护的内存地址写数据。最常见就是给一个指针以0地址,即指向nullptr,此时不能赋值。

2)内存越界(数组越界,变量类型不一致等): 访问到不属于你的内存区域。

-

寻找段错误的方法:直接gdb进行run即可。

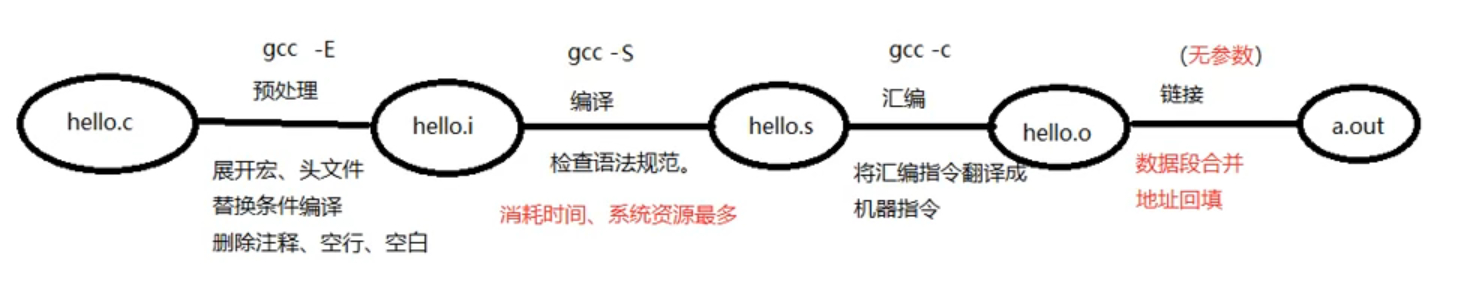

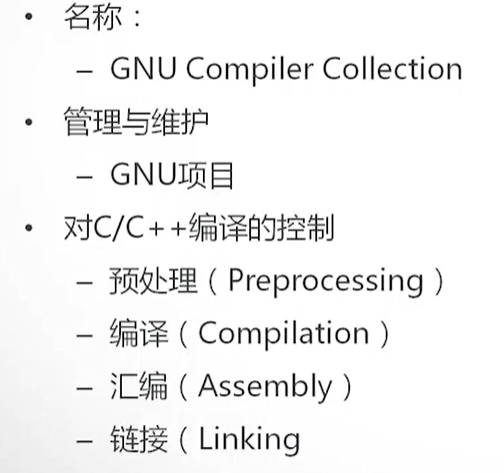

GCC 编译工具

四步骤

- gcc 编译可以执行程序 4 步骤: 预处理、编译、汇编、链接。

- 预处理

gcc -E - 编译

gcc -S - 汇编

gcc -c - 链接

无参数,-o 只是指定生成的可执行程序的名字

基本使用

-

在CentOs上安装gcc

1yum -y install gcc gcc-c++ kernel-devel -

-

- 预处理, 展开头文件/宏替换/去掉注释/条件编译 (test.i main.i)

- 编译, 检查语法,生成汇编代码 (test.s main.s)

- 汇编, 汇编代码转换机器码 (test.o main.o)

- 链接, 链接到一起生成可执行程序 (test.out mian.out 或没后缀)

-

gcc使用语法:

gcc [选项] <文件名> -

1.

gcc filename -o targetname: 直接生成可执行文件main.out

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15[root@Tyc c++code]# cat test1.c #include <stdio.h> int main(){ printf("hello gcc!\n"); return 0; } [root@Tyc c++code]# gcc test1.c -o test1 [root@Tyc c++code]# ll total 16 -rwxr-xr-x 1 root root 8360 Feb 25 21:02 test1 -rw-r--r-- 1 root root 70 Feb 25 21:01 test1.c [root@Tyc c++code]# ./test1 hello gcc! [root@Tyc c++code]# -

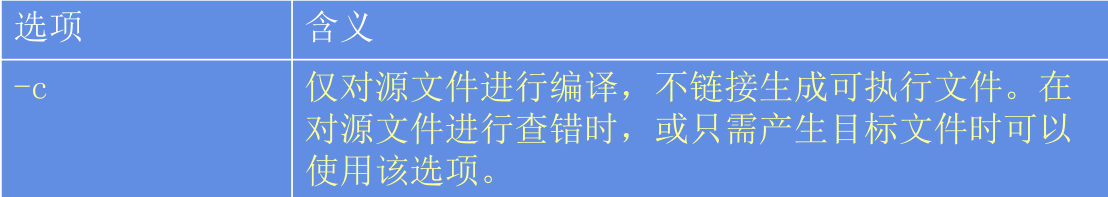

2.

gcc -c fileName: 只对源文件进行编译和汇编,不链接,生成main.o文件

1 2 3 4 5 6 7 8 9[root@Tyc c++code]# gcc -c test1.c [root@Tyc c++code]# ls test1.c test1.o [root@Tyc c++code]# gcc test1.o -o test [root@Tyc c++code]# ls test test1.c test1.o [root@Tyc c++code]# ./test hello gcc! [root@Tyc c++code]# -

3.

gcc -S filename:对源文件只进行编译而不汇编操作,生成汇编代码,生成main.s汇编代码文件1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32[root@Tyc c++code]# ls main.e test1.c [root@Tyc c++code]# gcc -S test1.c [root@Tyc c++code]# ls main.e test1.c test1.s [root@Tyc c++code]# cat test1.s .file "test1.c" .section .rodata .LC0: .string "hello gcc!" .text .globl main .type main, @function main: .LFB0: .cfi_startproc pushq %rbp .cfi_def_cfa_offset 16 .cfi_offset 6, -16 movq %rsp, %rbp .cfi_def_cfa_register 6 movl $.LC0, %edi call puts movl $0, %eax popq %rbp .cfi_def_cfa 7, 8 ret .cfi_endproc .LFE0: .size main, .-main .ident "GCC: (GNU) 4.8.5 20150623 (Red Hat 4.8.5-44)" .section .note.GNU-stack,"",@progbits -

4.

gcc -E filename:只进行预编译,把所有头文件、宏替换过来,生成最终的编译文件main.i文件1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27[root@Tyc c++code]# gcc -E test1.c > main.i [root@Tyc c++code]# ls main.i test1.c [root@Tyc c++code]# cat main.i | more # 1 "test1.c" # 1 "<built-in>" # 1 "<command-line>" # 1 "/usr/include/stdc-predef.h" 1 3 4 # 1 "<command-line>" 2 # 1 "test1.c" # 1 "/usr/include/stdio.h" 1 3 4 # 27 "/usr/include/stdio.h" 3 4 # 1 "/usr/include/features.h" 1 3 4 # 375 "/usr/include/features.h" 3 4 # 1 "/usr/include/sys/cdefs.h" 1 3 4 # 392 "/usr/include/sys/cdefs.h" 3 4 # 1 "/usr/include/bits/wordsize.h" 1 3 4 # 393 "/usr/include/sys/cdefs.h" 2 3 4 # 376 "/usr/include/features.h" 2 3 4 # 399 "/usr/include/features.h" 3 4 # 1 "/usr/include/gnu/stubs.h" 1 3 4 # 10 "/usr/include/gnu/stubs.h" 3 4 # 1 "/usr/include/gnu/stubs-64.h" 1 3 4 # 11 "/usr/include/gnu/stubs.h" 2 3 4 # 400 "/usr/include/features.h" 2 3 4 # 28 "/usr/include/stdio.h" 2 3 4 ... -

5.

gcc -g filename -o targetname: 生成带debug调试信息的可执行文件。以下例子可以看到带调试信息的可执行文件相当于windows上的debug按钮,而一般生成的是release按钮,可以看到带调试信息的可执行文件的容量更大。后面使用GDB进行调试,可以跟进代码。1 2 3 4 5 6 7 8 9 10[root@Tyc c++code]# gcc -g test1.c -o main_d [root@Tyc c++code]# ls main_d test1.c [root@Tyc c++code]# gcc test1.c -o main_r [root@Tyc c++code]# ls -l total 28 -rwxr-xr-x 1 root root 9360 Feb 25 21:57 main_d -rwxr-xr-x 1 root root 8360 Feb 25 21:57 main_r -rw-r--r-- 1 root root 70 Feb 25 21:01 test1.c [root@Tyc c++code]#

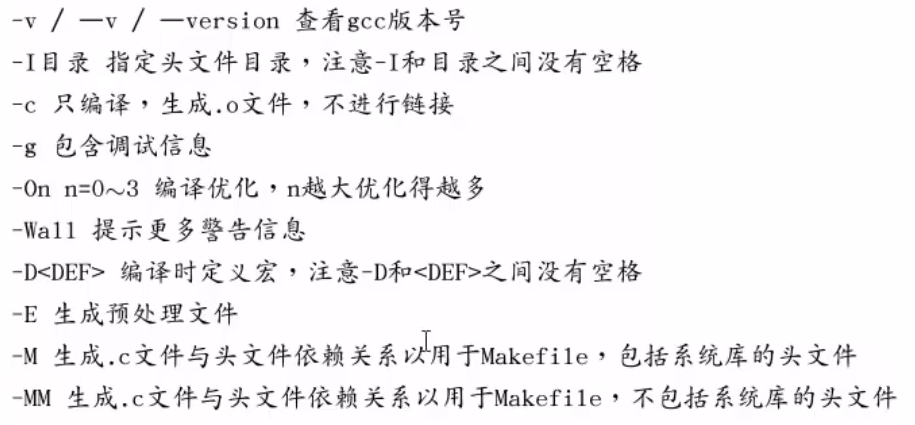

常用参数

-

-

gcc -v或者gcc --version:查看gcc版本号 -

gcc -I filename:指定头文件目录g++ main.cpp -o main -I ../include/I后面的空格可有可没有。- 如果头文件和源文件在同一个目录下面,则不需要指定头文件

-

gcc -Wall:显示所有的警告信息 -

gcc main.c -o main -Wall。 -

gcc hello.c -D HELLO:向程序中“动态” 注册宏定义。-

gcc hello.c -o hello -D HELLO -

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22[root@Tyc test]# vim hello.c [root@Tyc test]# cat hello.c #include <stdio.h> #ifdef HELLO #define I 20 #endif int main(){ printf("_------%d",I); return 0; } [root@Tyc test]# gcc hello.c -o hello hello.c: In function ‘main’: hello.c:6:21: error: ‘I’ undeclared (first use in this function) printf("_------%d",I); ^ hello.c:6:21: note: each undeclared identifier is reported only once for each function it appears in [root@Tyc test]# gcc hello.c -o hello -D HELLO [root@Tyc test]# ls hello hello.c main.cpp [root@Tyc test]# ./hello _------20[root@Tyc test]# [root@Tyc test]#

-

-

gcc -O:编译优化等级设置

Linux 动态库和静态库

绪论

- 函数库分为静态库和动态库两种。

- 静态库:静态库在程序编译时会被连接到目标代码中,程序运行时将不再需要该静态库。编译时空间消耗大,运行速度理论上大于动态库。

- 动态库:也称共享库,动态库在程序编译时并不会被连接到目标代码中,而是在程序运行是才被载入,因此在程序运行时还需要动态库存在。

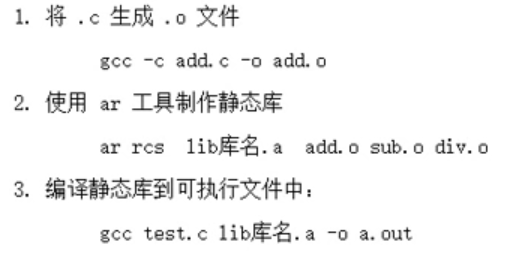

静态库制作

-

lib[xxx].a -

-

静态库名字以

lib开头,以.a结尾——例如:libmylib.a。 -

步骤:

- 1.

gcc -c生成.o汇编文件 - 2.

ar rcs libmylib.a file1.o生成静态库文件

- 1.

-

静态库生成指令——

ar rcs 生成静态库库名 汇编文件名ar rcs libmylib.a file1.o -

例子

ar rcs libmyMath.a add.o div1.o sub.o -

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26[root@Tyc staticLib]# vim add.c [root@Tyc staticLib]# ls add.c div1.c red.c [root@Tyc staticLib]# cat add.c int add(int a, int b){ return a+b; } [root@Tyc staticLib]# cat div1.c int add(int a, int b){ return a/b; } [root@Tyc staticLib]# cat red.c int red(int a, int b){ return a-b; } [root@Tyc staticLib]# gcc -c add.c -o add.o [root@Tyc staticLib]# gcc -c red.c -o sub.o [root@Tyc staticLib]# gcc -c div1.c -o div1.o [root@Tyc staticLib]# ls add.c add.o div1.c div1.o red.c sub.o [root@Tyc staticLib]# ar rcs libmyMath.a add.o div1.o sub.o [root@Tyc staticLib]# ls add.c add.o div1.c div1.o libmyMath.a red.c sub.o [root@Tyc staticLib]# file libmyMath.a libmyMath.a: current ar archive [root@Tyc staticLib]# -

静态库的使用:

-

gcc test.c lib库名.a -o test.out -

如果不加lib进行编译,链接会发生错误,有

collect2收集器表示链接出错。如果是编译出错,会显示行号表示语法错误。 -

注意一定是源文件在静态库文件之前。

-

1gcc test.c libmyMath.a -o test.out

-

-

头文件守卫,防止头文件被重复包含

1 2 3 4#ifndef _HEAD_H_ #define _HEAD_H_ ... #endif

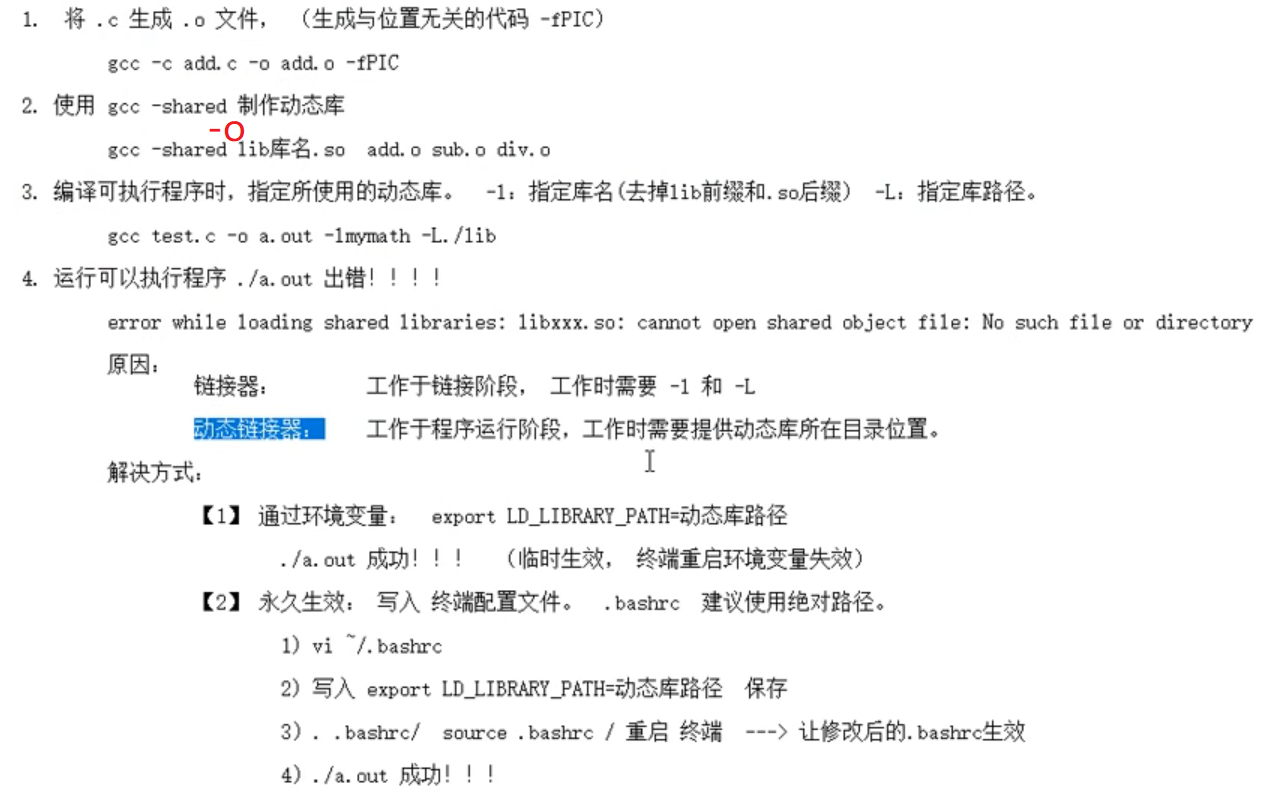

动态库制作

lib[xxx].so

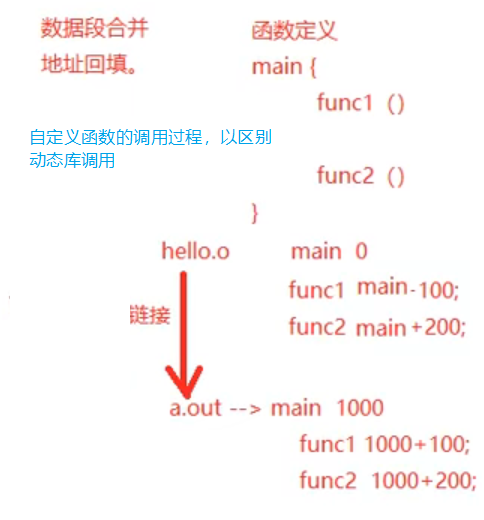

基本原理

- 首先看自己同一个源文件里面的函数调用步骤。主要是要在链接的时候进行数据段合并以及地址回填,如下图所示,fun1函数的地址以 main函数的地址为依据拥有自身的地址从而得到调用,fun2函数同理。

- 动态库的调用和普通函数的调用不同,

延迟绑定,查看生成的汇编代码可知,调用动态库函数依赖@plt的地址,就像上图的函数依赖main函数的地址一样,而@plt的地址当内存载入动态库的时候就会产生,从而可以调用动态库函数。

步骤

-

步骤1:将源文件

.c生成汇编文件.o,生成与位置无关的汇编代码——-fPIC。 -

gcc -c add.c -o add.o -fPIC -

步骤2:使用

gcc -shared制作动态库gcc -shared -o lib库名.so add.o sub.o div1.o- 注意库名自定义,前面+

lib,后面+.so。

-

步骤3:编译可执行程序,指定所使用的的动态库。

-l:指定库名,注意这个库名没有前缀lib,也没有后缀.so-L:指定库路径,不需要空格。gcc test.c -o test.out -lmymath -L./lib

-

步骤4:更改动态库的文件路径,不更改步骤三的执行程序会报错。有两种方式:

-

临时更改,切换终端后无效——

export LD_LIBRARY_PATH=动态库路径。支持相对路径。 -

更改配置文件,添加环境变量

export LD_LIBRARY_PATH=动态库路径,一直有效。1 2vim ~/.bashrc source ~/.bashrc

-

-

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19[root@Tyc source]# gcc -c add.c -o add.o -fPIC [root@Tyc source]# gcc -c sub.c -o sub.o -fPIC [root@Tyc source]# gcc -c div1.c -o div1.o -fPIC [root@Tyc source]# ls add.c add.o div1.c div1.o sub.c sub.o [root@Tyc source]# gcc -shared -o libmymath.so add.o sub.o div1.o [root@Tyc source]# ls add.c add.o div1.c div1.o libmymath.so sub.c sub.o [root@Tyc cplusCode]# ls dynamicLib include staticLib test testDll.c [root@Tyc cplusCode]# gcc testDll.c -o testdll.out -lmymath -L ./dynamicLib/ -I ./include/ [root@Tyc cplusCode]# ls dynamicLib include staticLib test testDll.c testdll.out [root@Tyc cplusCode]# export LD_LIBRARY_PATH=./dynamicLib/ [root@Tyc cplusCode]# ./testdll.out add=21 sub=7 div=2 [root@Tyc cplusCode]# -

1 2 3 4 5 6 7 8 9[root@Tyc cplusCode]# vim ~/.bashrc [root@Tyc cplusCode]# ./testdll.out ./testdll.out: error while loading shared libraries: libmymath.so: cannot open shared object file: No such file or directory [root@Tyc cplusCode]# source ~/.bashrc [root@Tyc cplusCode]# ./testdll.out add=21 sub=7 div=2 [root@Tyc cplusCode]# -

除了上述两种添加动态库路径的方式,还有以下两种方式。

GDB 调试工具

基础指令

-

gcc -g:使用该参数编译执行文件,得到调试表; -

gdb a.out:开始调试; -

list:列出源码,list可以使用缩写l; -

l 行数n:从第n行开始列出源码,l是list的缩写; -

b 行数n:breakPoint缩写,在第n行设置断点; -

run/r:运行程序; -

n/next:下一条指令,会越过函数; -

s/step:单步执行,会进入函数; -

p/print 变量i:打印出当前变量i的值; -

continue:继续执行断点的后续指令; -

quit:退出gdb调试。 -

delete 行数n:删除行数n的断点。 -

其他指令

run:使用run查找段错误出现位置;finish:结束当前函数调用;info b:查看断点信息表;b if i = 5:设置条件断点;- set args: 设置main函数命令行参数 (在 start、run 之前);

- run 字串1 字串2 ...: 设置main函数命令行参数;

- ptype:查看变量类型;

- bt:列出当前程序正存活着的栈帧;

- frame: 根据栈帧编号,切换栈帧;

- display:设置跟踪变量;

- undisplay:取消设置跟踪变量。 使用跟踪变量的编号。

Makefile 项目管理

绪论

-

文件命名:makefile或者Makefile,最好不要更改,更改就不能使用默认的命令了。

-

入门Makefile,需要掌握

1 2 3; -

1代表一个规则;2代表两个函数;3代表自动变量。

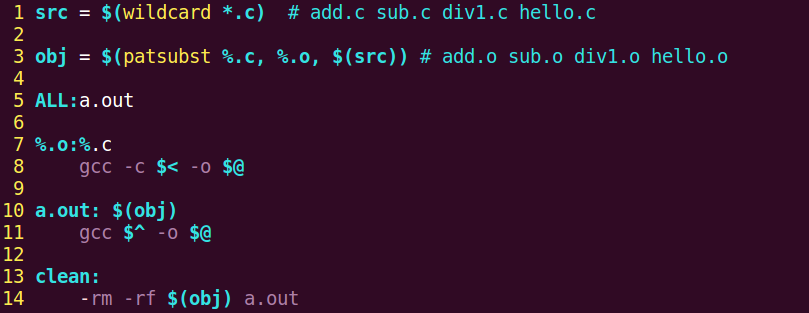

一个规则

-

1 2 3 4 5目标:依赖条件 命令(注意要有一个tab的缩进) ###以下是例子 hello:hello.c gcc hello.c -o hello -

1.若想生成

目标,检查规则中的依赖条件是否存在,如不存在,则得找是否有规则用来生成该依赖文件。 -

2.检查规则中的

目标是否需要更新,必须先检查它的所有依赖条件,依赖条件中有任一个被更新,则目标必须更新。 -

3.makefile默认编译的最终目标是第一行的目标,要想自定义最终目标,可以使用

ALL:a.out -

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16ALL:a.out a.out:hello.o add.o sub.o div1.o gcc hello.o add.o sub.o div1.o -o a.out add.o:add.c gcc -c add.c -o add.o sub.o:sub.c gcc -c sub.c -o sub.o div1.o:div1.c gcc -c div1.c -o div1.o hello.o:hello.c gcc -c hello.c -o hello.o

两个函数和 clean

-

src = $(wildcard ./*.c):匹配当前工作目录下所有后缀为.c的文件,将文件名组成列表,赋值给src变量。(wildcard是通配符的意思)。 -

obj = $(patsubst %.c, %.o, $(src)):将参数3(src)中,包含参数1的部分,替换为参数2,赋值个obj变量。 -

还可以在makefile里面删除生成为汇编文件,使用

clean命令。其中的-表示当删除文件不存在,不报错继续执行,直至完成任务,否则会终止执行没有删除剩下的文件。注意clean后面没有依赖。 -

1 2clean: -rm -rf $(obj) a.out #注意有tab键- 注意在默认情况下,执行

make命令时,clean规则将不会被运行,因为它不是生成目标的先决条件。要运行clean规则,你需要输入make clean命令。

- 注意在默认情况下,执行

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22src = $(wildcard ./*.c) #add.c sub.c divi.c hello.c obj = $(patsubst %.c,%.o,$(src)) #add.o sub.o div1.o hello.o ALL:a.out a.out:$(obj) gcc $(obj) -o a.out add.o:add.c gcc -c add.c -o add.o sub.o:sub.c gcc -c sub.c -o sub.o div1.o:div1.c gcc -c div1.c -o div1.o hello.o:hello.c gcc -c hello.c -o hello.o clean: -rm -rf $(obj) a.out

三个自动变量

-

注意这三个变量只能用于规则的命令里面,不能用于目标或者依赖。

-

$@:在规则命令中,表示规则中的目标。 -

$<:在规则命令中,表示规则中的第一个依赖条件;如果将该变量用在模式规则中,它可以将依赖条件列表中的依赖依次取出,套用模式规则。 -

$^:在规则命令中,表示规则中的所有依赖条件。 -

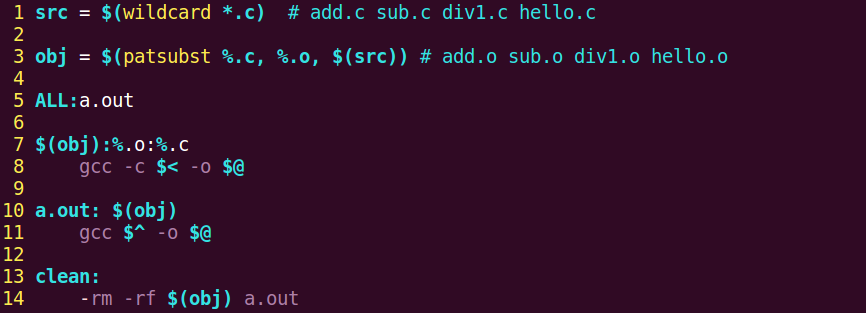

模式规则

-

很明显在上图中,makefile的可扩展性不强。比如要增加一个mul.c文件要重新加一行编译命令,不符合makefile一次编写一生受用的目标,所有有了模式规则。

-

模式规则的代码

-

1 2%.o:%.c gcc -c $< -o $@ -

-

以后增加函数的时候,不用改makefile,只需要增加.c文件,改一下源码就可以了。

-

静态模式规则

-

静态模式规则,就是指定模式规则给谁用。因为以后不止一个obj,还会有其他的obj1等等。

-

代码格式

-

1 2$(obj):%.o:%.c gcc -c $< -o $@ -

-

其他拓展

-

当前文件夹下有ALL文件或者clean文件时,会导致makefile不执行clean以及ALL的目标编译。

- 用伪目标来解决,最后添加一行

.PHONY: clean ALL。

- 用伪目标来解决,最后添加一行

-

编译时的参数,-g,-Wall,-I 这些,都可以放在makefile里面。

一般模板

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16src = $(wildcard *.c) obj = $(patsubst %.c, %.o, $(src)) myArgs = -Wall -g ALL:a.out a.out:$(obj) gcc $^ -o $@ $(myArgs) $(obj):%.o:%.c gcc -c $< -o $@ $(myArgs) clean: -rm -rf $(obj) a.out .PHONY: clean ALL -

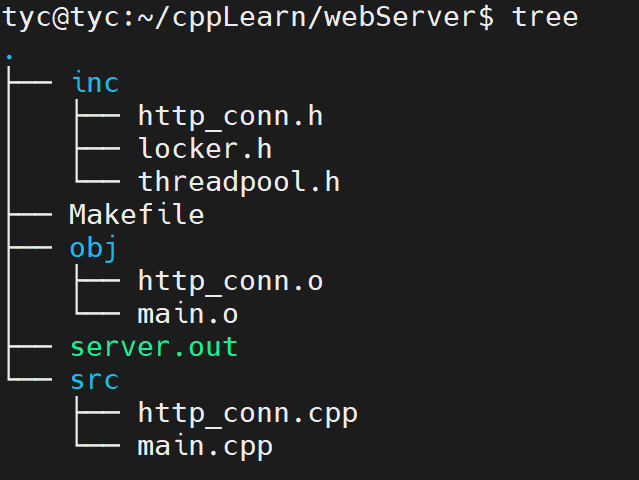

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19src = $(wildcard ./src/*.cpp) obj = $(patsubst ./src/%.cpp, ./obj/%.o, $(src)) inc_path = ./inc myArgu = -Wall -g ALL:server.out $(obj):./obj/%.o:./src/%.cpp g++ -c $< -o $@ $(myArgu) -I $(inc_path) server.out:$(obj) g++ $^ -o $@ $(myArgu) clean: -rm -rf $(obj) server.out .PHONY: clean ALL -

把源文件放src文件夹,头文件放inc文件夹,生成放obj文件夹。(注意3个文件夹要先创建好了)

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19src = $(wildcard ./src/*.cpp) obj = $(patsubst ./src/%.cpp, ./obj/%.o, $(src)) inc_path = ./inc myArgu = -Wall -g ALL:a.out $(obj):./obj/%.o:./src/%.cpp g++ -c $< -o $@ $(myArgu) -I $(inc_path) a.out:$(obj) g++ $^ -o $@ $(myArgu) clean: -rm -rf $(obj) a.out .PHONY: clean ALL

《Linux高性能服务器编程》学习笔记

第3章 tcp 协议详解

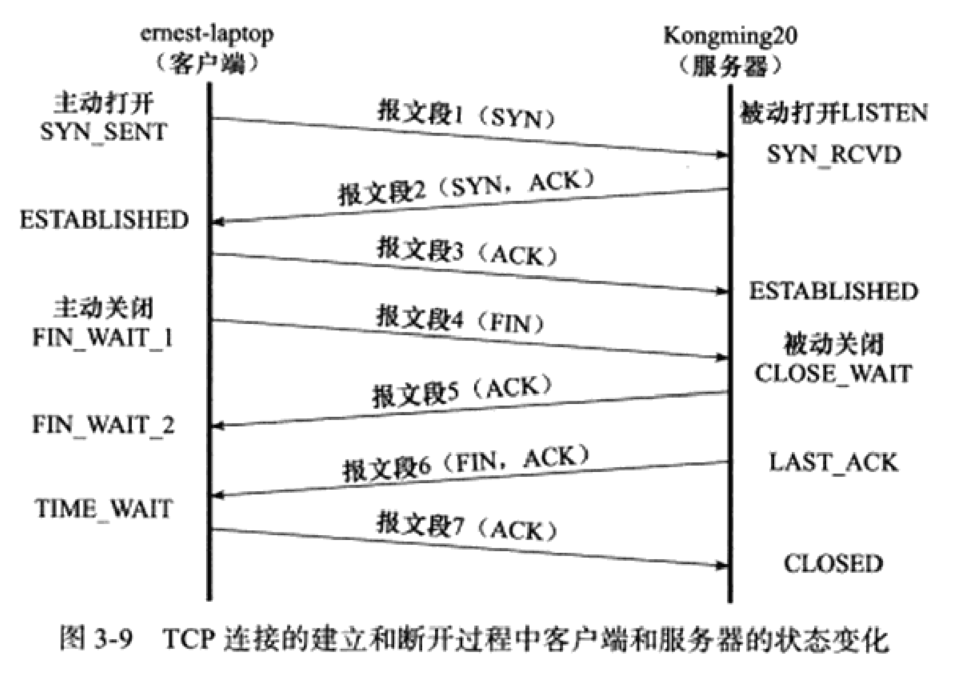

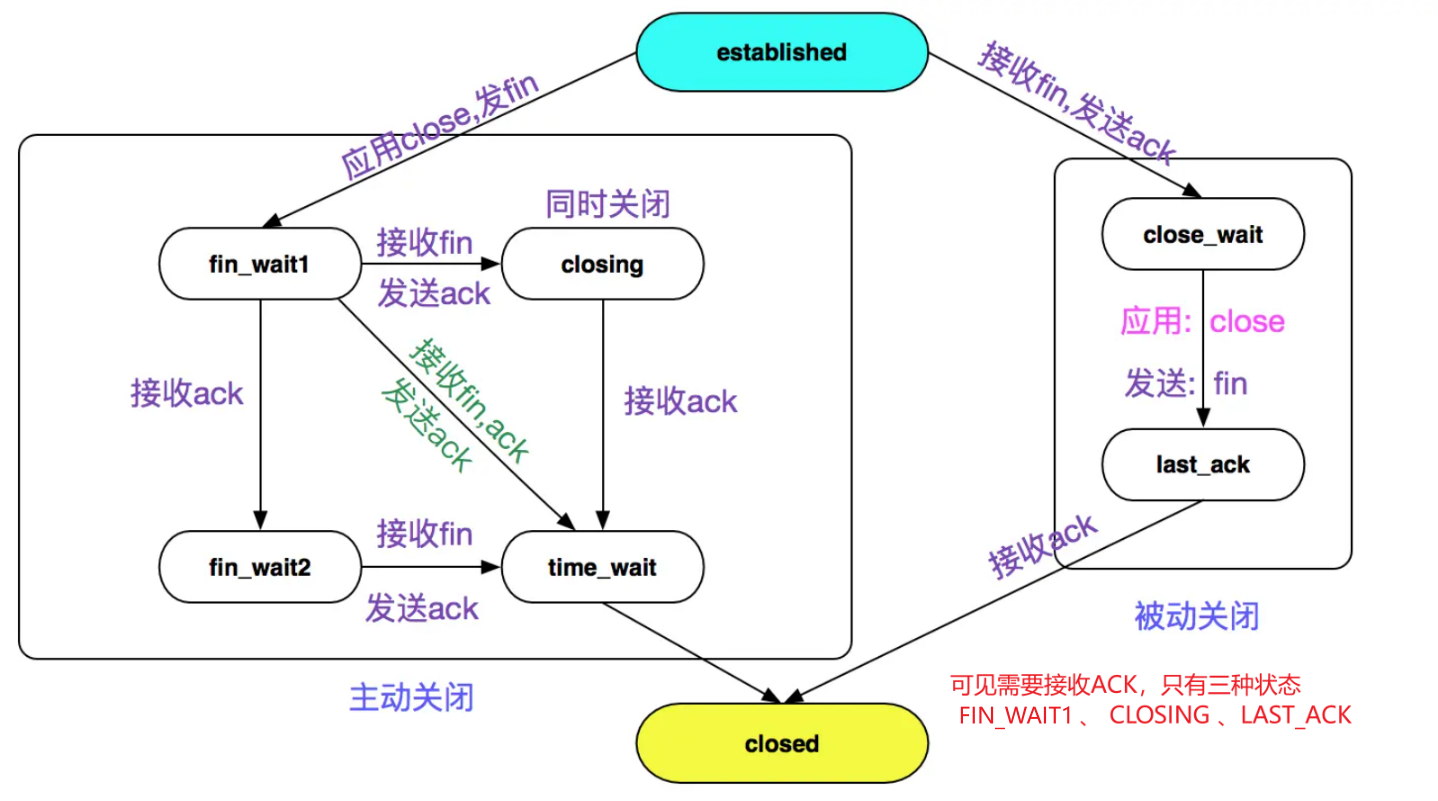

1. TIME_WAIT 状态

-

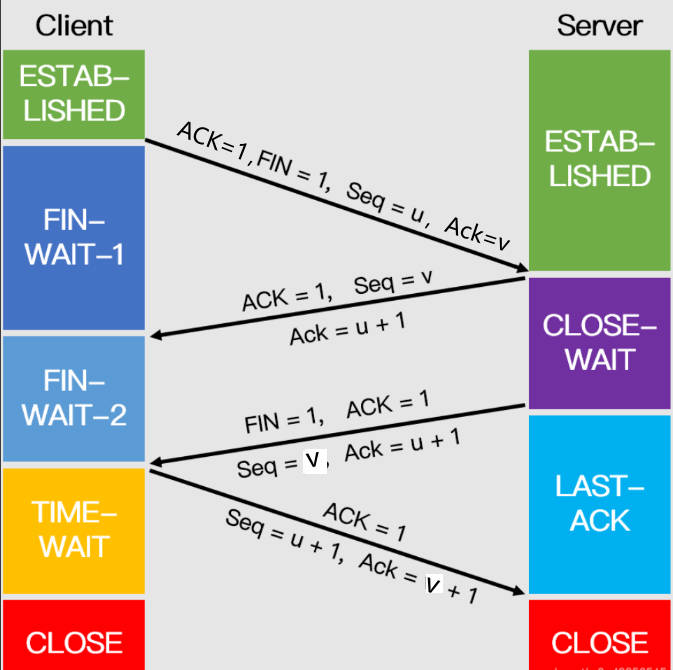

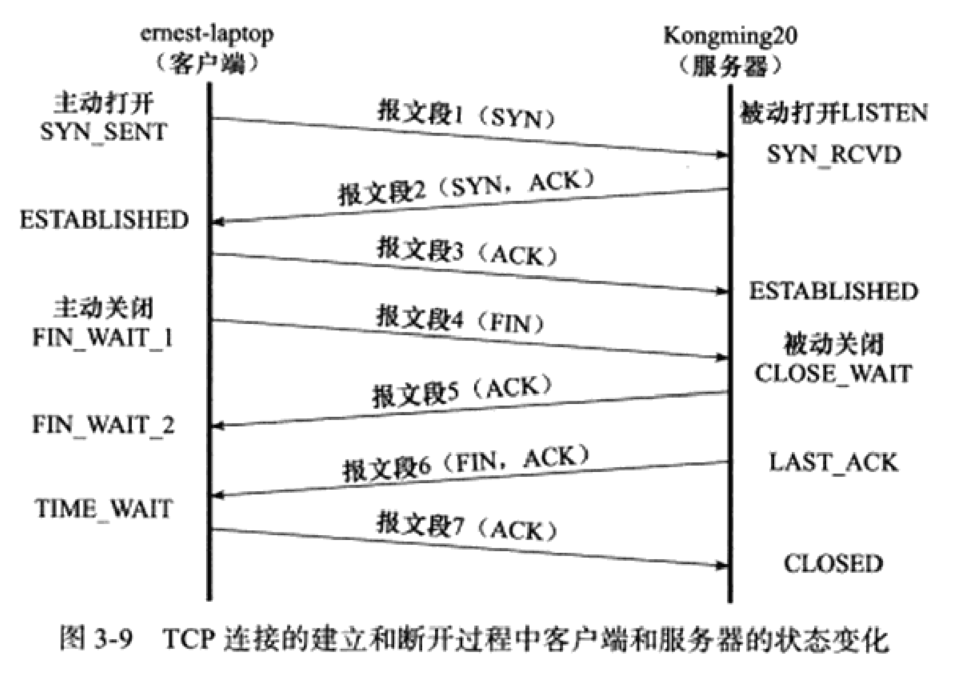

-

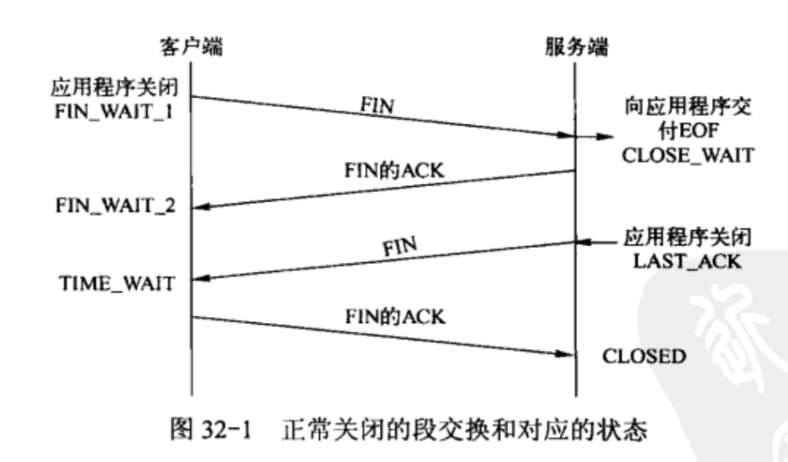

从上图可以看出,客户端连接在收到服务器的结束报文段(TCP报文段6)之后,并没有直接进人CLOSED状态,而是转移到TIME_WAIT状态。在这个状态,客户端连接要等待一段长为2MSL(Maximum Segment Life,报文段最大生存时间)的时间,才能完全关闭。MSL是TCP报文段在网络中的最大生存时间,标准文档RFC1122的建议值是2min。

-

每个TCP实现必须选择一个MSL。它是任何报文段被丢弃前在网络内的最长时间。这个时间是有限的,因为TCP报文段以IP数据报在网络内传输,而IP数据报则有限制其生存时间的TTL时间。RFC1122 指出MSL为2分钟,现实中常用30秒或1分钟。

-

TIME_WAIT 存在的原因有两点:

- 1.可靠的终止TCP连接。若处于 TIME_WAIT 的客户端发送给服务器确认报文段丢失的话,服务器将在此重新发送FIN报文段,那么客户端必须处于一个可接收的状态就是 TIME_WAIT 而不是CLOSE状态,以处理重复收到的FIN报文。否则,客户端将以复位RST报文段来回应服务器,服务器会认为这是一个错误。

- 2.保证让迟来的TCP报文段有足够的时间被识别并丢弃。在Linux系统上,一个TCP端口不能被同时打开多次(两次及以上)。当一个TCP连接处于TIME_WAIT状态时,我们将无法立即使用该连接占用着的端口来建立一个新连接。反过来思考,如果不存在TIME WAIT状态,则应用程序能够立即建立一个和刚关闭的连接相似的连接(这里说的相似,是指它们具有相同的P地址和端口号)。这个新的、和原来相似的连接被称为原来的连接的化身(incarnation)。新的化身可能接收到属于原来的连接的、携带应用程序数据的TCP报文段(迟到的报文段),这显然是不应该发生的。这就是TIME_WAIT状态存在的第二个原因。

-

为什么需要等待一段长为2MSL(Maximum Segment Life,报文段最大生存时间)的时间来维持 TIME_WAIT 的时间呢?

- 因为TCP报文段的最大生存时间是MSL,所以坚持2MSL时间的TIME_WAIT状态能够确保网络上两个传输方向上尚未被接收到的、迟到的TCP报文段都已经消失(被中转路由器丢弃)。因此,一个连接的新的化身可以在2MSL时间之后安全地建立,而绝对不会接收到属于原来连接的应用程序数据,这就是TIME_WAIT状态要持续2MSL时间的原因。

-

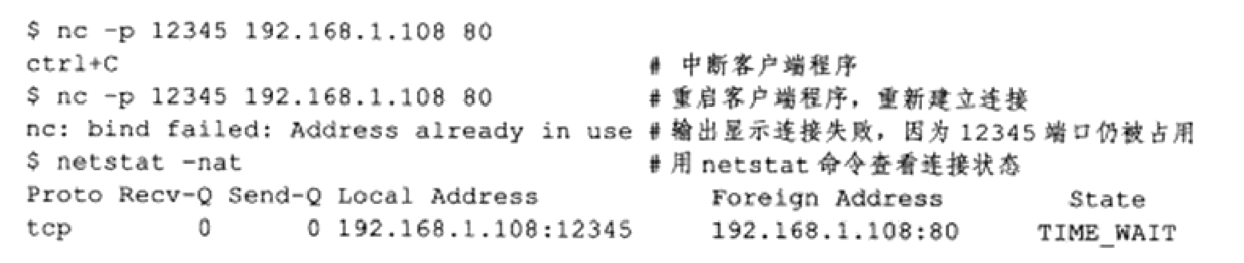

有时候我们希望避免TIME_WAIT状态,因为当程序退出后,我们希望能够立即重启它。但由于处在TIME_WAIT状态的连接还占用着端口,程序将无法启动(直到2MSL超时时间结束)。

-

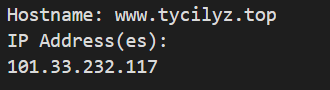

-

对客户端程序来说,我们通常不用担心上面描述的重启问题。因为客户端一般使用系统自动分配的临时端口号来建立连接,而由于随机性,临时端口号一般和程序上一次使用的端口号(还处于TIME_WAIT状态的那个连接使用的端口号)不同,所以客户端程序一般可以立即重启。上面的例子仅仅是为了说明问题,我们强制客户端使用12345端口,这才导致立即重启客户端程序失败。

-

但如果是服务器主动关闭连接后异常终止,则因为它总是使用同一个知名服务端口号,所以连接的TIME_WAIT状态将导致它不能立即重启。不过,我们可以通过socket选项SO_REUSEADDR来强制进程立即使用处于TIME_WAIT状态的连接占用的端口,解决这种问题。

-

这里需要说明,客户端在发送 FIN 后仍然能发送 ACK 是不矛盾的,因为 ACK 不是本地服务的数据,是放在 tcp 头部的,而不是body中。

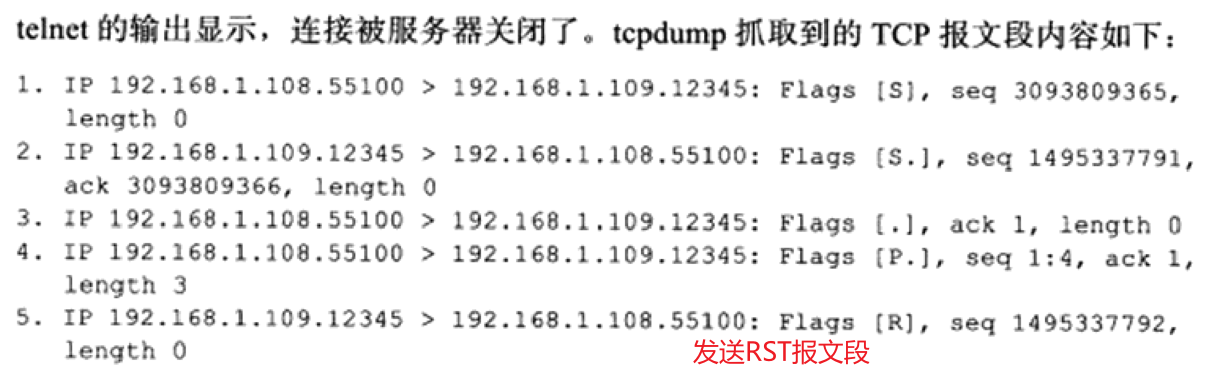

2. 复位报文段 RST

- 在某些特殊条件下,TCP连接的一端会向另一端发送携带RST标志的报文段,即复位报文段,以通知对方关闭连接或重新建立连接。以下是产生复位报文段RST的3种情况。

- (1) 访问不存在的端口或者处于 TIME_WAIT 的端口

- 当客户端访问一个不存在的端口是,目标主机将给它发送一个复位报文段RST,因为复位报文段的接收通告窗口大小为0,所以可以预见:收到复位报文段的一端应该关闭连接或者重新连接,而不能回应这个复位报文段。实际上,当客户端程序向服务器的某个端口发起连接,而该端口仍被处于TIME_WAIT状态的连接所占用时,客户端程序也将收到复位报文段。

- (2) 异常终止连接

- 正常的终止方式为:数据交换完成之后,一方给另一方发送结束报文段。

- TCP提供了异常终止一个连接的方法,即给对方发送一个复位报文段。一旦发送了复位报文段RST,发送端所有排队等待发送的数据都将被丢弃。

- 应用程序可以使用socket选项SO_LINGER来发送复位报文段,以异常终止一个连接。

- (3) 处理半打开连接

- 考虑下面的情况:服务器(或客户端)关闭或者异常终止了连接,而对方没有接收到结束报文段(比如发生了网络故障),此时,客户端(或服务器)还维持着原来的连接,而服务器(或客户端)即使重启,也已经没有该连接的任何信息了。我们将这种状态称为半打开状态,处于这种状态的连接称为半打开连接。如果客户端(或服务器)往处于半打开状态的连接写入数据,则此时服务器(或客户端)将回应一个复位报文段RST。

- 举例来说,我们在Kongming20上使用nc命令模拟一个服务器程序,使之监听12345端口,然后从ernest-laptop运行telnet命令登录到该端口上,接着拔掉ernest-laptop的网线,并在Kongming20上中断服务器程序。显然,此时ernest--laptop上运行的telnet客户端程序维持着一个半打开连接。然后接上ernest-laptop的网线,并从客户端程序往半打开连接写入1字节的数据“a”。同时,运行tcpdump程序抓取整个过程中telnet客户端和nc服务器交换的TCP报文段。

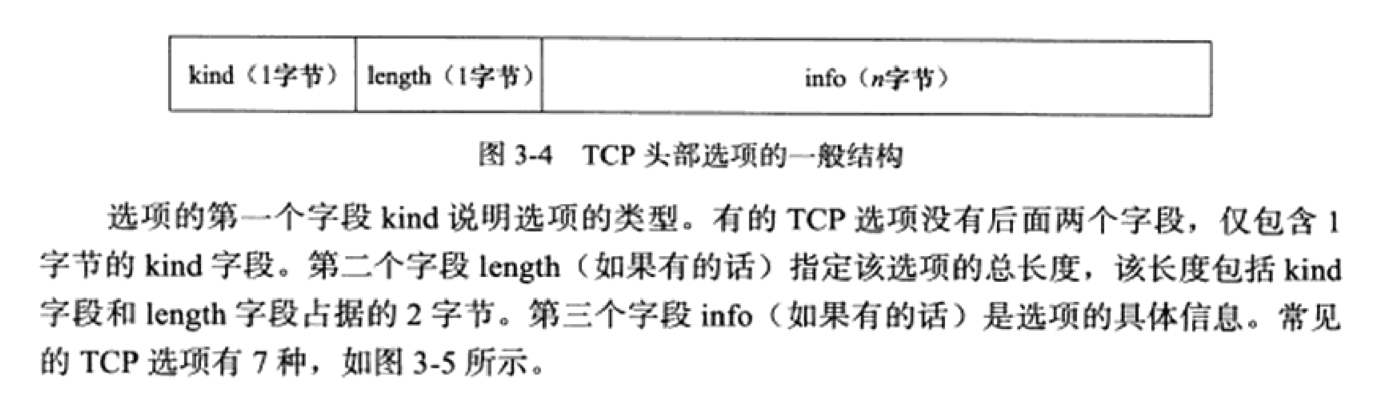

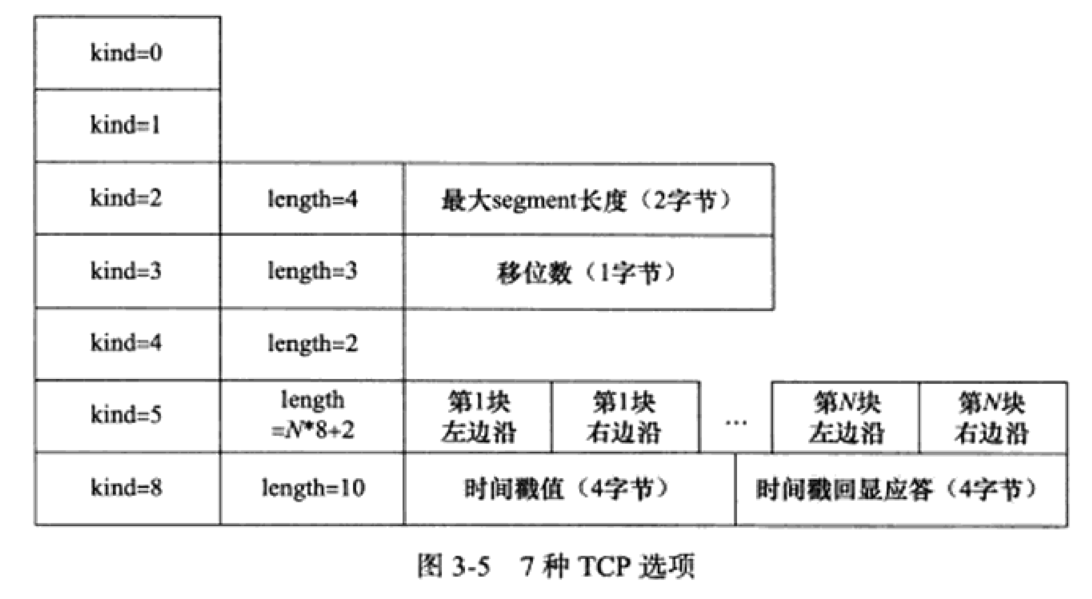

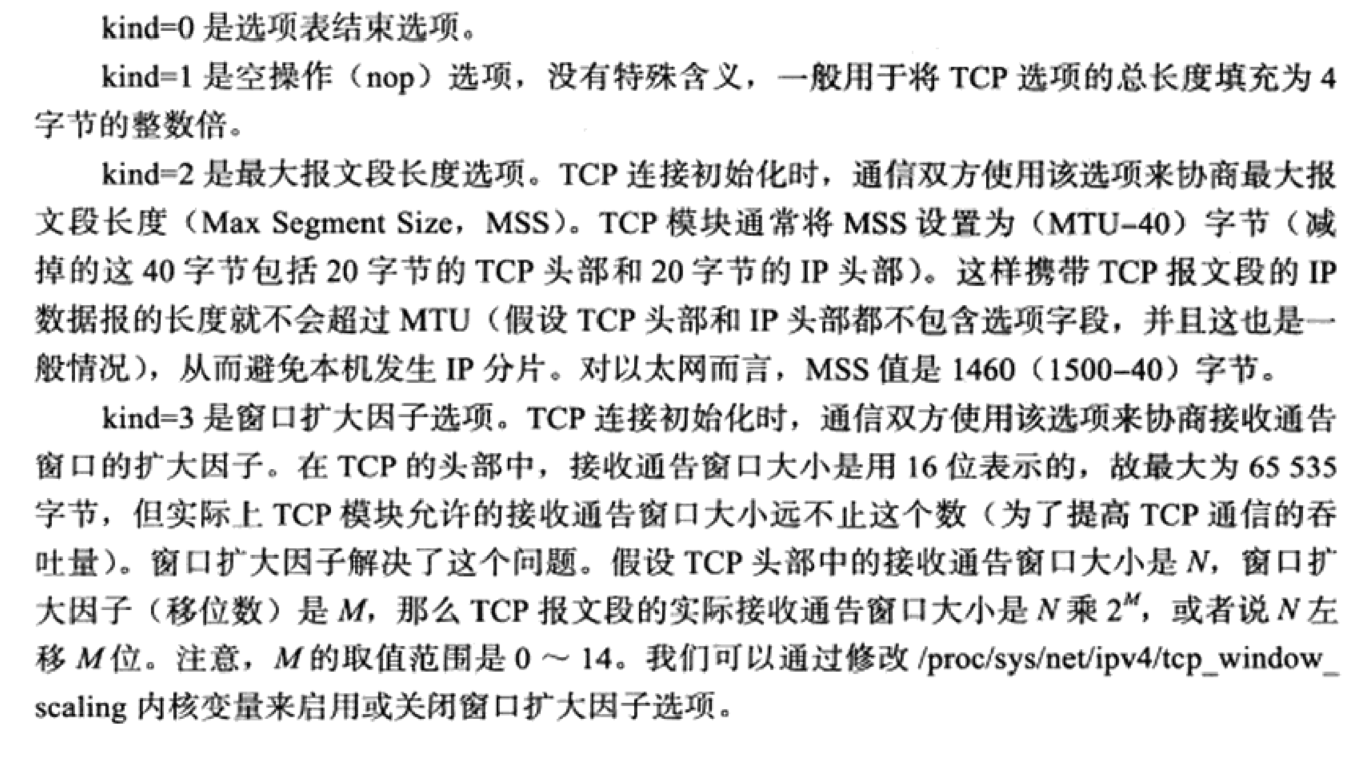

3. TCP 头部选项

-

TCP头部的最后一个选项字段(options)是可变长的可选信息。这部分最多包含40字节,因为TCP头部最长是60字节(其中还包含前面讨论的20字节的固定部分)。

-

-

-

-

-

-

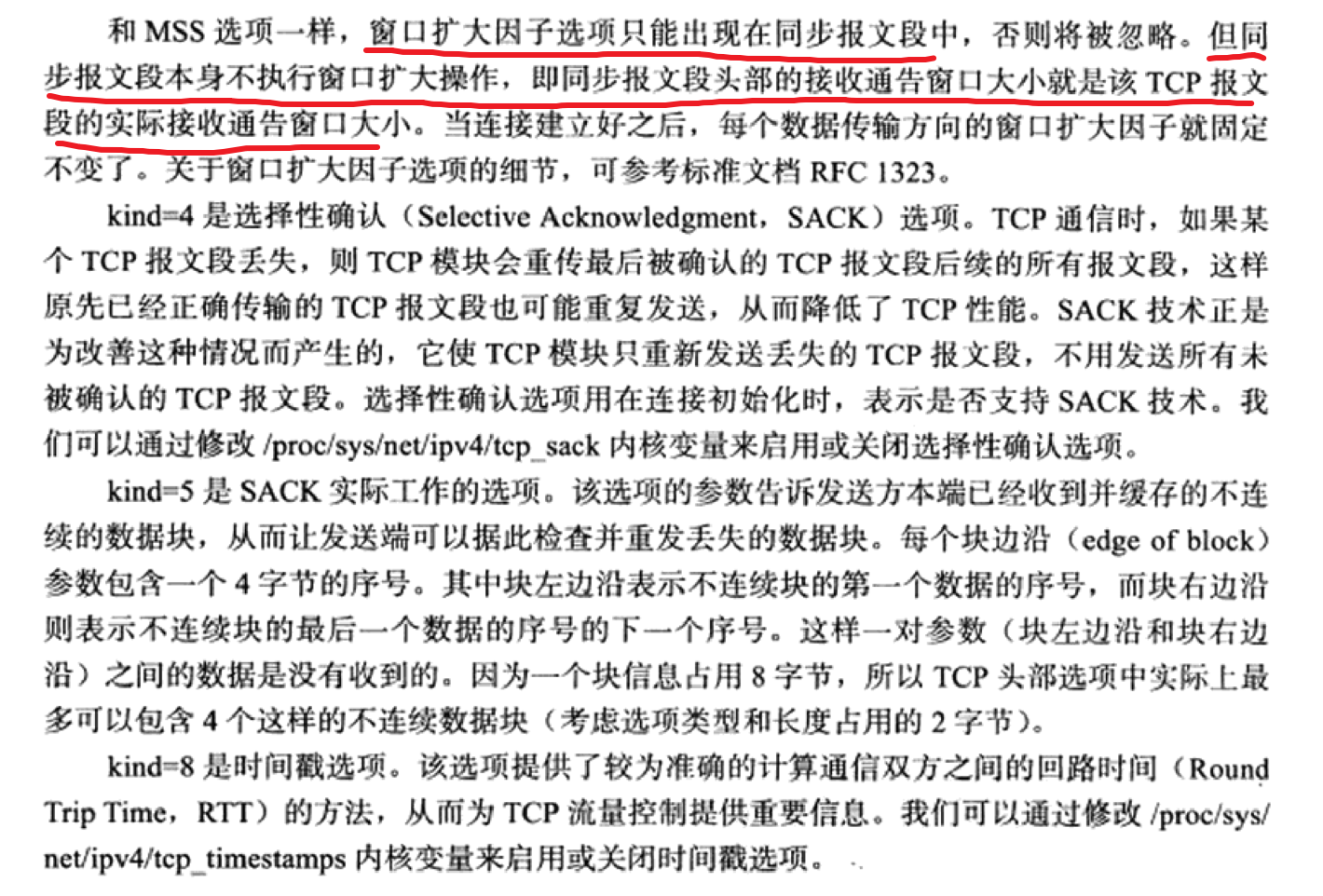

这里重点了解窗口扩大因子的作用,在同步报文出现的win,是实际的窗口大小;在传输报文出现的,是压缩的窗口大小。

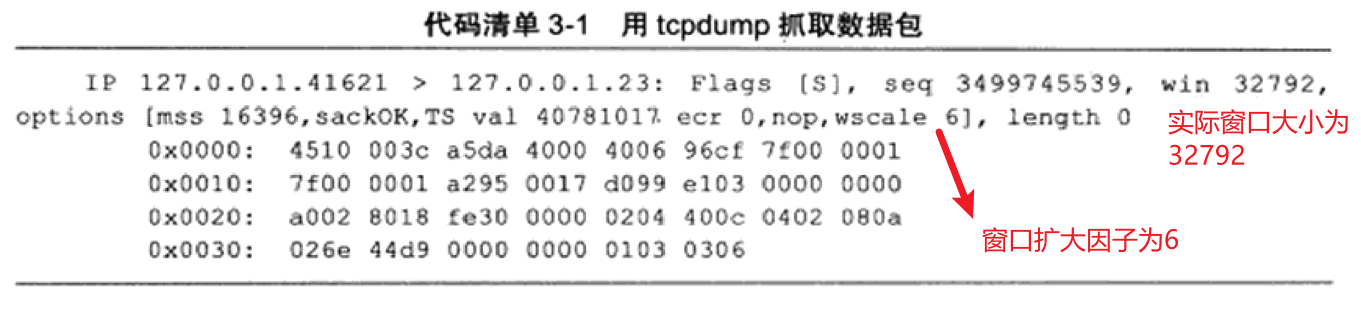

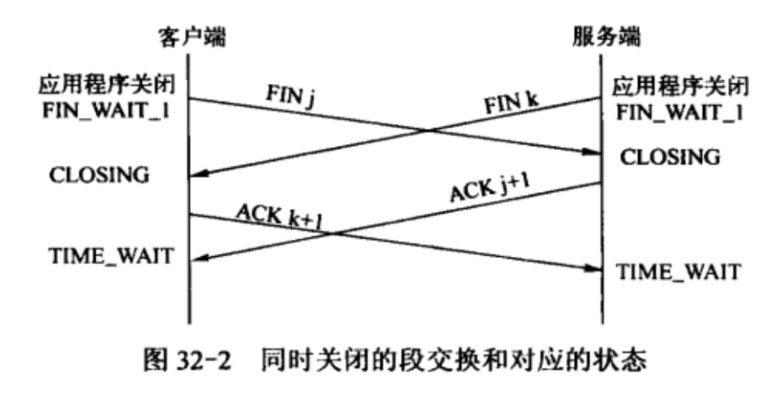

4. TCP 状态转移

-

这里需要说明,客户端在发送 FIN 后仍然能发送 ACK 是不矛盾的,因为 ACK 不是本地服务的数据,是放在 tcp 头部的,而不是body中。

-

-

第5章 Linux网络编程基础api

1. 主机字节序和网络字节序

-

主机字节序一般为小端字节序(little endian),但也有大端字节序的主机,如java虚拟机。

- 一个整数的高位字节(23-31bit)存储在内存的高地址处,低位字节(0-7bit)存储在低地址处。

-

网络字节序默认都是大端字节序(big endian)。

- 一个整数的高位字节(23-31bit)存储在内存的低地址处,低位字节(0-7bit)存储在高地址处。

-

检查机器的字节序代码。

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23#include <stdio.h> void byteorder() { // 内存共享,两个字节 union { short value; char union_values[sizeof(short)]; } test; // 1为整数的高地址,2为整数的低地址 test.value = 0x0102; if (test.union_values[0] == 1 && test.union_values[1] == 2) { printf("big endian\n"); } else if (test.union_values[0] == 2 && test.union_values[1] == 1) { printf("little endian\n"); } else { printf("unkonwn \n"); } } int main() { byteorder(); return 0; } -

Linux提供了如下4个函数完成主机字节序和网络字节序之间的转换。

-

长整型函数通常用来转换IP地址(32位),短整型函数一般用来转换端口号(16位)。一个字节一个字节的交换。

-

1 2 3 4 5#include <netinet/in.h> unsigned long int htonl(unsigned long int hostlong); unsigned short int htons(unsigned short int hostshort); unsigned long int ntohl(unsigned long int netlong); unsigned short int ntohs(unsigned short int netshort);

2. 通用socket地址

-

socket网络编程接口中表示socket地址的是结构体sockaddr,其定义如下:

-

1 2 3 4 5 6 7 8 9#include <bits/socket.h> typedef unsigned short int sa_family_t; /* Structure describing a generic socket address. */ struct sockaddr { sa_family_t sa_family; /* Common data: address family and length. */ char sa_data[14]; /* Address data. */ }; -

所有专用socket地址(以及sockaddr_storage)类型的变量在实际使用时都需要转化为通用socket地址类型sockaddr(强制转换即可),因为所有socket编程接口使用的地址参数的类型都是sockaddr。

-

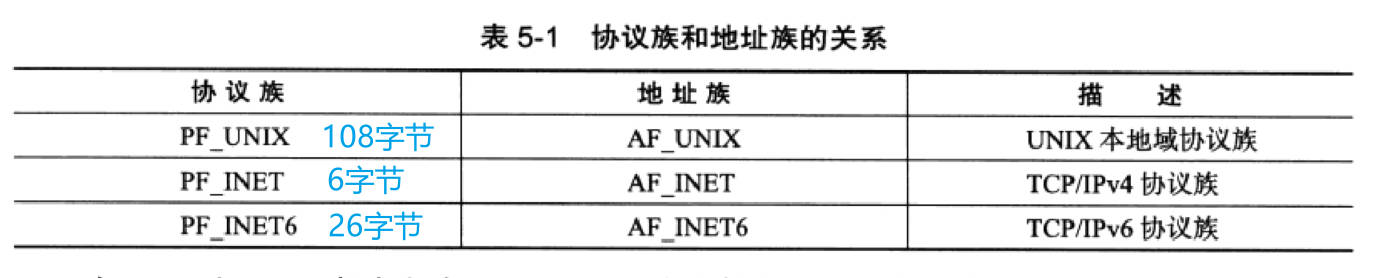

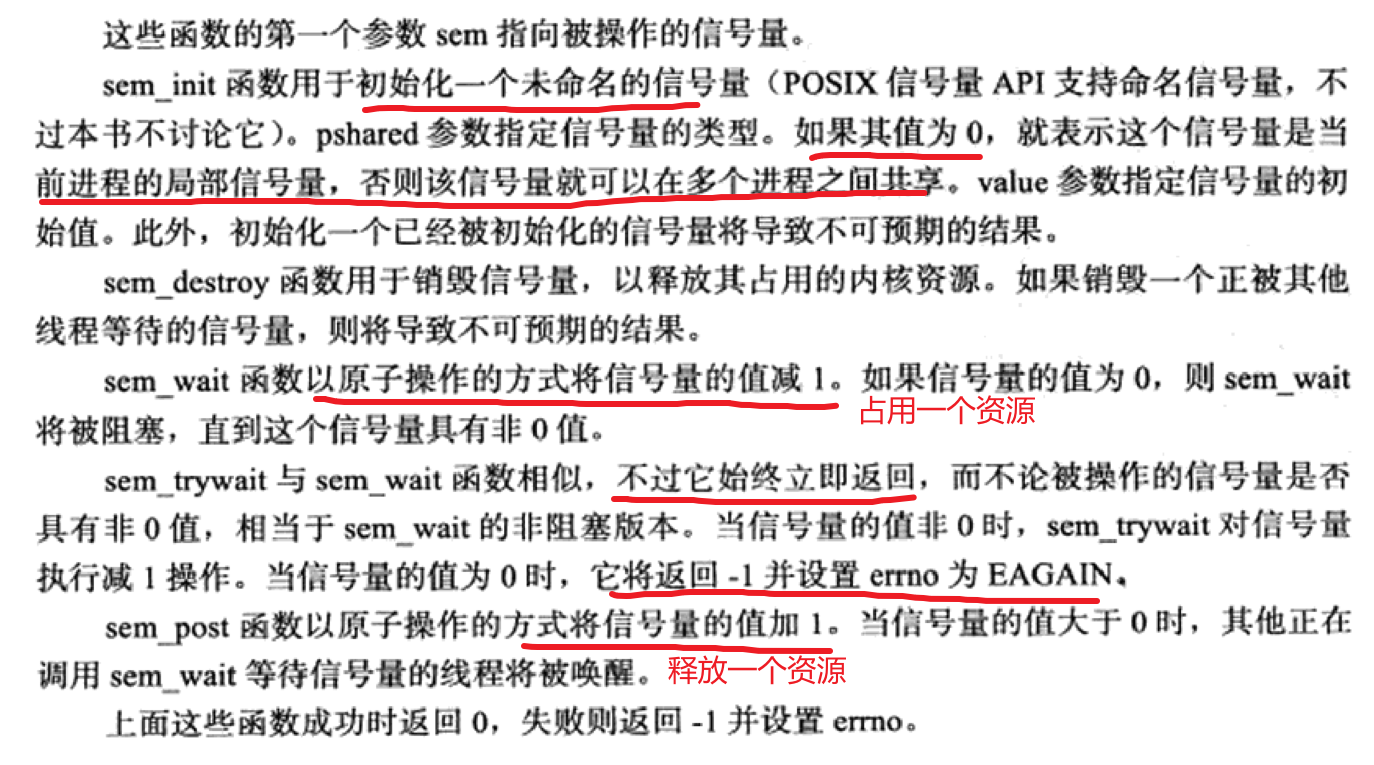

常见的协议族有以下三种

-

-

显然,14字节的sa_data根本不能完成容纳多数协议族的地址值。因此Linux定义了下面这个新的通用socket地址结构体。

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19#define __ss_aligntype unsigned long int #define _SS_PADSIZE \ (_SS_SIZE - __SOCKADDR_COMMON_SIZE - sizeof (__ss_aligntype)) #define __SOCKADDR_COMMON(sa_prefix) \ sa_family_t sa_prefix##family #define __SOCKADDR_COMMON_SIZE (sizeof (unsigned short int)) /* Size of struct sockaddr_storage. */ #define _SS_SIZE 128 struct sockaddr_storage { __SOCKADDR_COMMON (ss_); /* Address family, etc. */ char __ss_padding[_SS_PADSIZE]; __ss_aligntype __ss_align; /* Force desired alignment. */ }; -

这个结构体不仅提供了足够大的空间用于存放地址值,而且是内存对齐的(这是__ss_align成员的作用)。

-

但实际开发中,所有socket编程接口使用的地址参数的类型都是sockaddr。

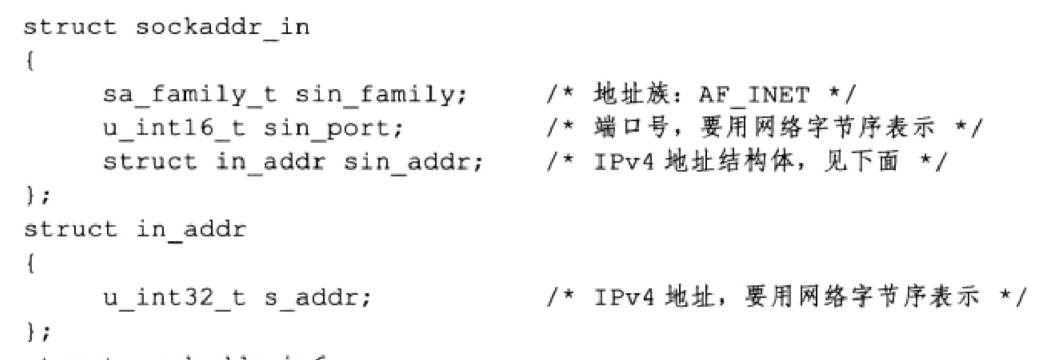

3. 专用socket地址

-

用于IPv4的sockaddr_in 结构体

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21#include <netinet/in.h> /* Internet address. */ typedef uint32_t in_addr_t; struct in_addr { in_addr_t s_addr; }; /* Structure describing an Internet socket address. */ struct sockaddr_in { __SOCKADDR_COMMON (sin_); in_port_t sin_port; /* Port number. */ struct in_addr sin_addr; /* Internet address. */ /* Pad to size of `struct sockaddr'. */ unsigned char sin_zero[sizeof (struct sockaddr) - __SOCKADDR_COMMON_SIZE - sizeof (in_port_t) - sizeof (struct in_addr)]; }; -

-

用于IPv6的sockaddr_in6 结构体

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24#include <netinet/in.h> struct in6_addr { union { uint8_t __u6_addr8[16]; uint16_t __u6_addr16[8]; uint32_t __u6_addr32[4]; } __in6_u; #define s6_addr __in6_u.__u6_addr8 #ifdef __USE_MISC # define s6_addr16 __in6_u.__u6_addr16 # define s6_addr32 __in6_u.__u6_addr32 #endif }; struct sockaddr_in6 { __SOCKADDR_COMMON (sin6_); in_port_t sin6_port; /* Transport layer port # */ uint32_t sin6_flowinfo; /* IPv6 flow information */ struct in6_addr sin6_addr; /* IPv6 address */ uint32_t sin6_scope_id; /* IPv6 scope-id */ }; -

4. 点分十进制和整数的ip地址转换函数

-

(1)IPv4的点分十进制字符串转为ip地址的整数。

-

注意这些函数,已经把ip地址的整数转换为网络字节序的整数了!结果已经是网络字节序了。

-

①函数

inet_addr(const char* strptr); -

1 2 3 4 5#include <arpa/inet.h> /* Internet address. */ typedef uint32_t in_addr_t; in_addr_t inet_addr(const char *strptr); // 返回:若字符串有效则将字符串转换为32位二进制网络字节序的IPV4地址,否则为INADDR_NONE -

但需要注意转为大小端字节序的结果是不一样的, 示例

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14#include <arpa/inet.h> #include <stdio.h> int main() { // 看成一个大整数,从高位到低位为,0xC0, 0xA8 ,0x00 ,0x01 in_addr_t res = inet_addr("192.168.0.1"); // 转换为大端字节序的整数,从高位到低位为,则为 01 00 A8 C0 // 转换为小端字节序的整数,从高位到低位为,则为 C0 A8 00 01 printf("%X\n", res); /*输出结果,可以看到确实转换为网络字节序 100A8C0 */ return 0; } -

②函数

int inet_aton(const char *string, struct in_addr *addr); -

inet_aton完成和inet_addr一样的功能,但是会把结果存在输入的addr指针里面。

-

1 2 3 4 5 6 7 8 9 10 11 12 13struct in_addr { in_addr_t s_addr; } int inet_aton(const char *string, struct in_addr *addr); /* 参数描述: 1 输入参数string包含ASCII表示的IP地址。 2 输出参数addr是将要用新的IP地址更新的结构。 返回值: 如果这个函数成功,函数的返回值1,如果输入地址不正确则会返回0。 使用这个函数并没有错误码存放在errno中,所以它的值会被忽略。 */ -

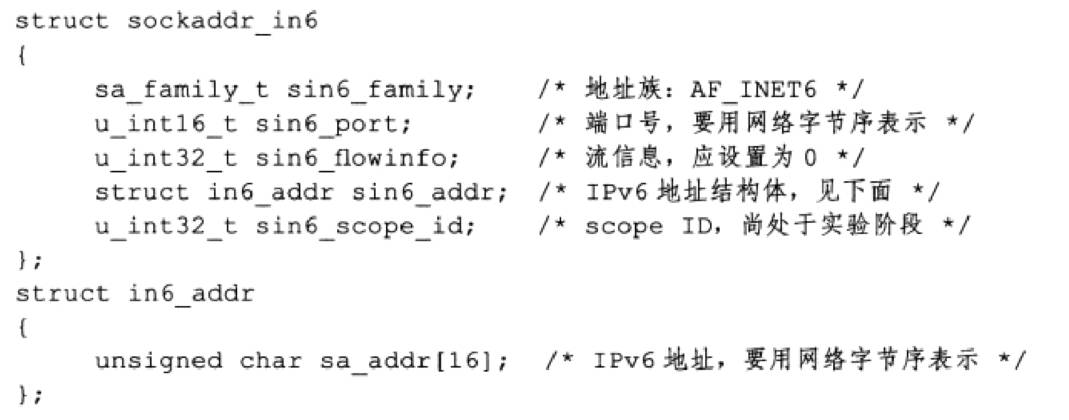

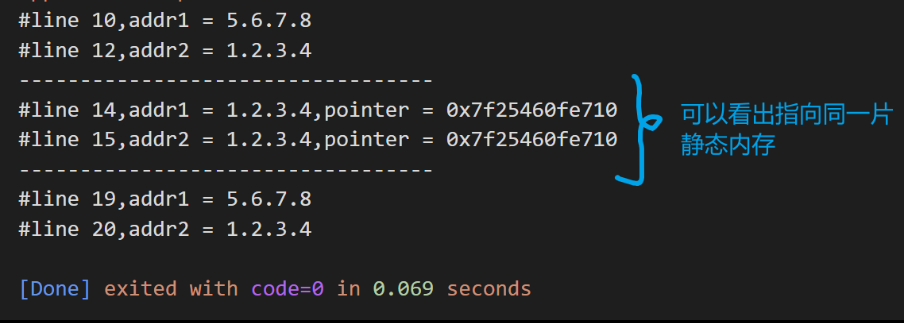

(2)IPv4的网络字节序ip地址整数转为主机字节序的点分十进制字符串。

-

使用函数

char *inet_ntoa(struct in_addr in); -

需要注意的是,这个函数返回的char* 指向的是一个静态内存,即每调用一次,都会更改一次,因此该函数是不可重入的。要想重入,需要自己开辟新的内存空间。

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24#include <arpa/inet.h> #include <stdio.h> #include <stdlib.h> #include <string.h> int main() { struct in_addr addr1 = {0x08070605}; struct in_addr addr2 = {0x04030201}; const char *s1 = inet_ntoa(addr1); printf("#line %d,addr1 = %s\n", __LINE__, s1); const char *s2 = inet_ntoa(addr2); printf("#line %d,addr2 = %s\n", __LINE__, s2); printf("----------------------------------\n"); printf("#line %d,addr1 = %s,pointer = %p\n", __LINE__, s1, s1); printf("#line %d,addr2 = %s,pointer = %p\n", __LINE__, s2, s2); printf("----------------------------------\n"); char *s11 = strcpy((char *)malloc(32), inet_ntoa(addr1)); char *s12 = strcpy((char *)malloc(32), inet_ntoa(addr2)); printf("#line %d,addr1 = %s\n", __LINE__, s11); printf("#line %d,addr2 = %s\n", __LINE__, s12); free(s11); free(s12); return 0; } -

-

(3)关于IPv6的转换函数

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23#include <arpa/inet.h> int inet_pton(int af, const char *src, void *dst); /* 参数说明: af:协议家族。 src:待转换的字符串IP。 dst:转换后的整数IP,这是一个输出型参数。 返回值说明: 如果转换成功,则返回1。 如果输入的字符串IP无效,则返回0,并设置error。 如果输入的协议家族af无效,则返回-1,并将errno设置为EAFNOSUPPORT。 */ const char *inet_ntop(int af, const void *src, char *dst, socklen_t cnt); /* 参数说明: af:协议家族。 src:待转换的整数IP。 dst:转换后的字符串IP,这是一个输出型参数。 cnt:用于指明dst中可用的字节数。 返回值说明: 如果转换成功,则返回一个指向dst的非空指针,即输入的 dst ;如果转换失败,则返回NULL。 */ -

-

其实在实际上,pton(int af, const char *src, void *dst);更常用。

-

函数中的p和n分别代表 表达式(presentation) 和 数值(numeric)。

-

同理,a 表示 ASCII码。

-

inet_pton示例

-

1 2 3 4 5 6// 创建socket struct sockaddr_in address; memset(&address, 0, sizeof(address)); address.sin_family = AF_INET; inet_pton(AF_INET, ip, &address.sin_addr); address.sin_port = htons(port); -

inet_ntop示例,和inet_ntoa 的最大区别就是,这个是可重入的。

-

1 2 3 4 5 6 7 8 9// 输出接收的 socket struct sockaddr_in client; char remote[INET_ADDRSTRLEN]; // 这个clientIp其实和remote是一样的,如果转换成功的话 const char *clientIp = inet_ntop(AF_INET, &client.sin_addr, remote, INET_ADDRSTRLEN); // 输出客户端 IP地址 和 端口号 printf("connected with ip: %s and port: %d\n", clientIp, ntohs(client.sin_port));

5. 创建 socket

-

使用 socket 函数。

-

1 2 3#include <sys/socket.h> #include <sys/types.h> int socket (int __domain, int __type, int __protocol) -

-

因此,将socket设置成非阻塞的可有以下两种方法:

-

(1)生成socket时设置

-

socket函数创建socket默认是阻塞的,也可以增加选项将socket设置为非阻塞的:

-

1int listenfd = socket(PF_INET, SOCK_STREAM | SOCK_NONBLOCK, 0); -

(2)使用fcntl设置

-

1 2 3 4 5 6 7// 将文件描述符设置为非阻塞的 int setnonblocking(int fd) { int old_option = fcntl(fd, F_GETFL); int new_option = old_option | O_NONBLOCK; fcntl(fd, F_SETFL, new_option); return old_option; }

6. 绑定/命名 bind socket

-

命名socket实际上就是把创建之后的socket描述符,和服务器的IP地址和端口号进行绑定。

-

注意接下来的几乎所有关于socket的库函数,传递的socket地址参数都是通用socket地址

struct sockaddr。 -

使用bind函数进行绑定。

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15#include <sys/socket.h> #include <sys/types.h> int bind(int sockfd, const struct sockaddr *addr, socklen_t addrlen); /* (1)sockfd表示socket文件的文件描述符,一般为socket函数的返回值; (2)addr 表示服务器的IP地址和端口号; (3)addrlen表示参数addr的长度;addr参数可以接受多种类型的结构体,而这些结构体的长度各不相同,因此需要使用addrlen参数额外指定结构体长度; */ struct sockaddr { sa_family_t sa_family; /* Common data: address family and length. */ char sa_data[14]; /* Address data. */ }; -

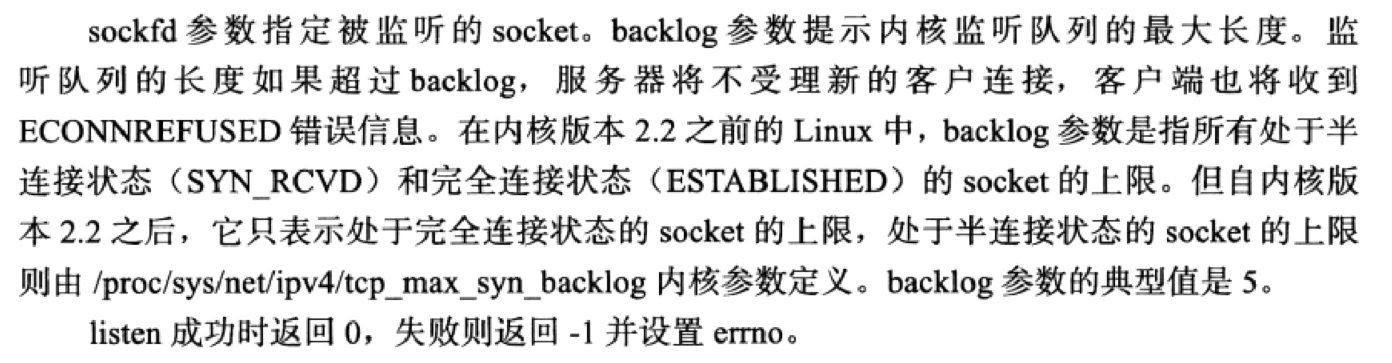

7. 监听 listen socket

-

listen函数在一般在调用bind之后-调用accept之前调用。

-

socket被bind之后,不能马上accept接收客户连接,我们需要使用listen系统调用来创建一个监听队列以存放待处理的客户连接。此时的socket称为监听socket。

-

1 2 3 4 5 6 7 8 9 10 11 12 13#include <sys/socket.h> int listen(int sockfd, int backlog); /* (1)参数sockfd是被listen函数作用的socket的描述符; (2)参数backlog是侦听队列的长度; 在进程正在处理一个连接请求的时候,可能还存在其它的连接请求。 因为TCP连接是一个过程,所以可能存在一种半连接的状态,有时由于同时尝试连接的用户过多, 使得服务器进程无法快速地完成连接请求。 如果这个情况出现了,服务器进程希望内核如何处理呢? 内核会在自己的进程空间里维护一个队列以跟踪这些完成的连接但服务器进程还没有接手处理的连接 (还没有调用accept函数的连接),这样的一个队列内核不可能让其任意大, 所以必须有一个大小的上限。这个backlog告诉内核使用这个数值作为上限。 */ -

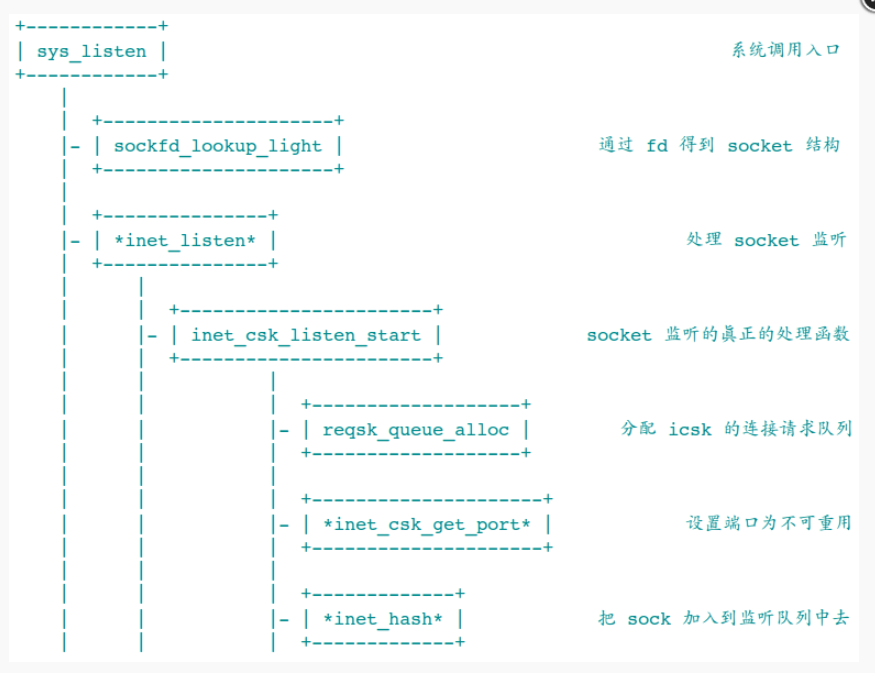

-

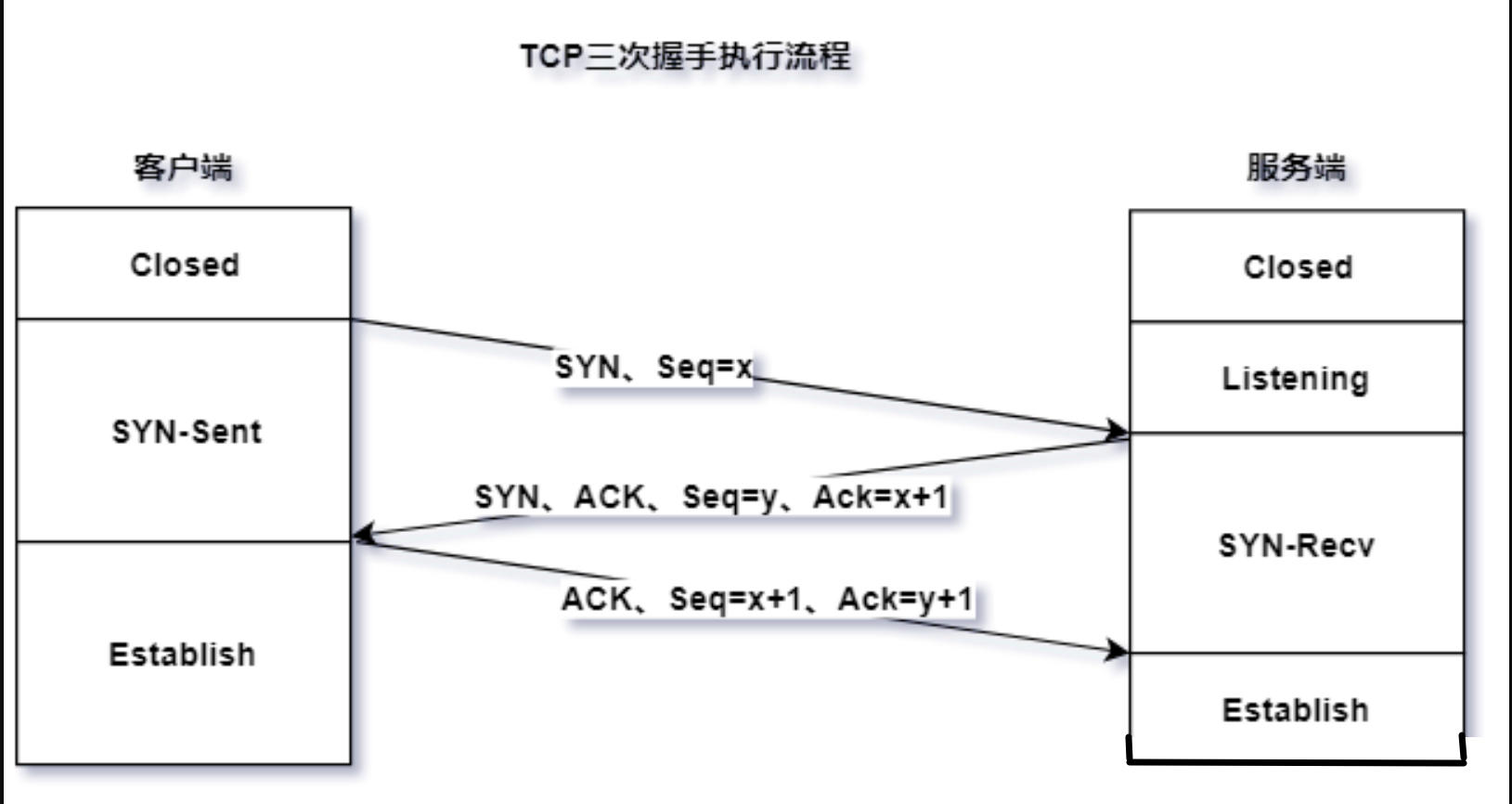

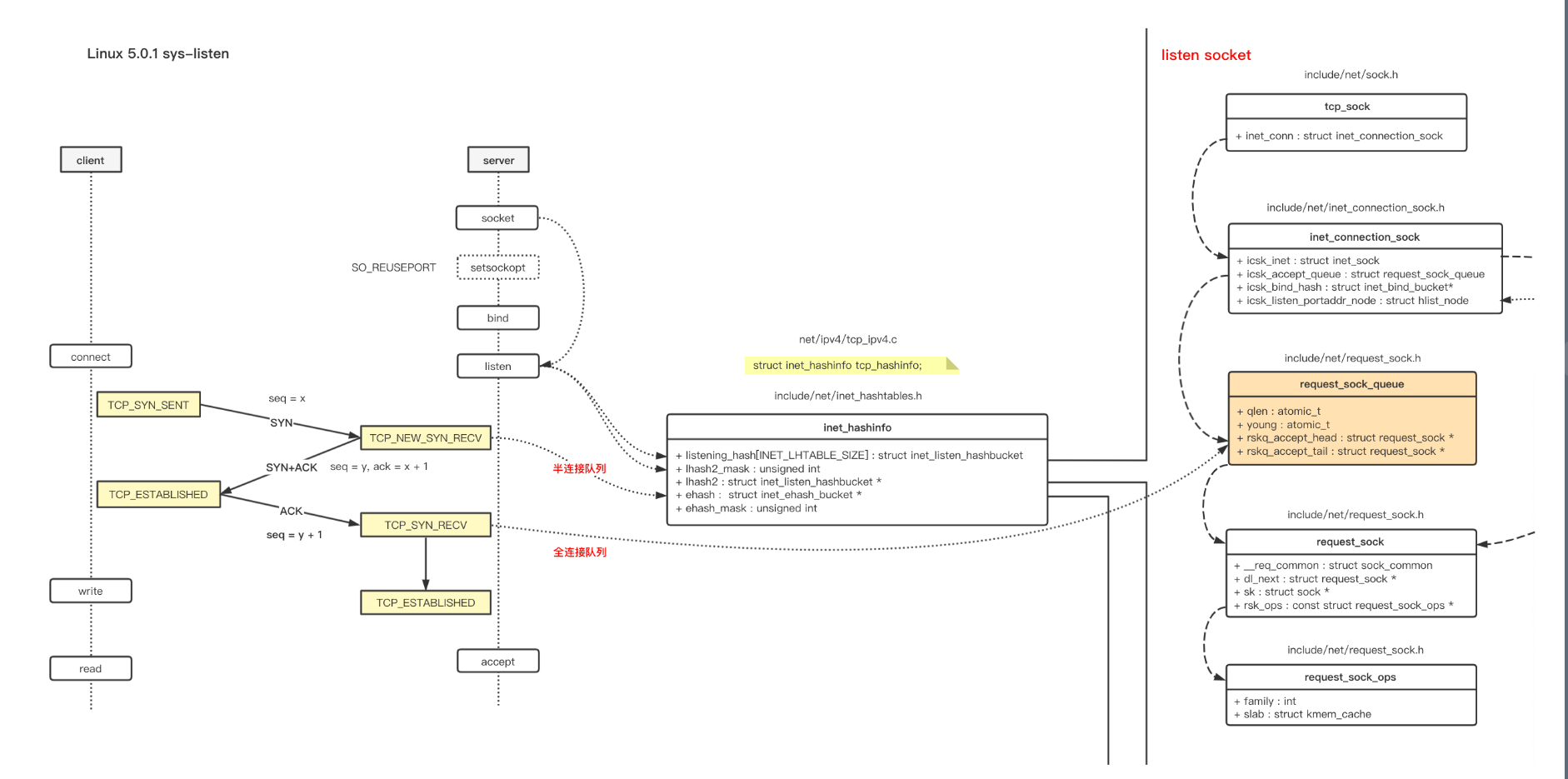

listen函数在内核中的具体实现流程如下。带

*的函数表示是通过函数指针引用而不是直接调用。 -

-

-

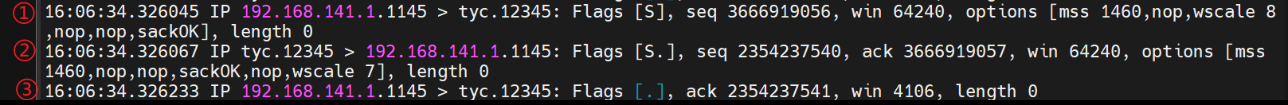

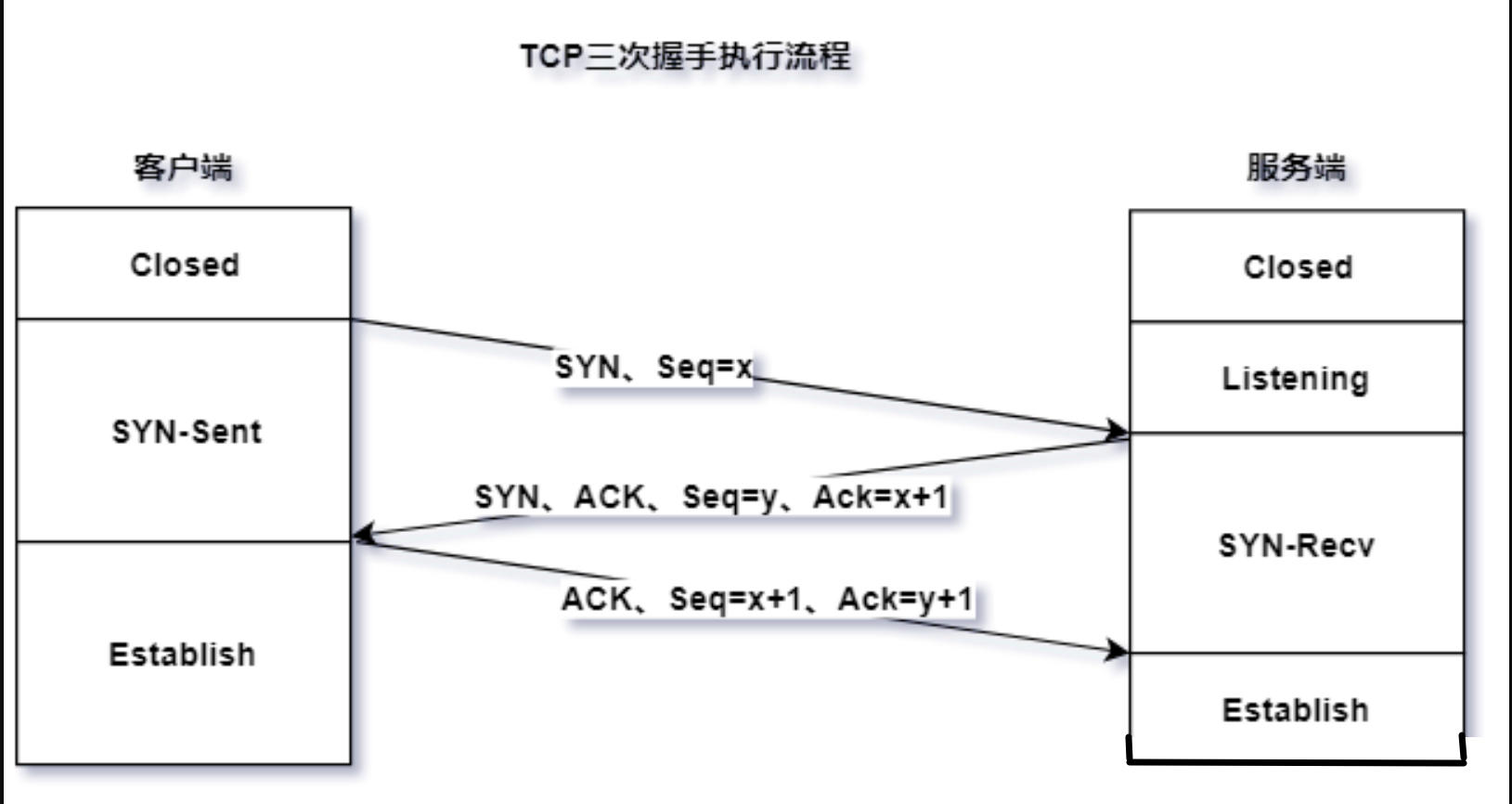

使用tcpdump观察三次握手过程。

tcpdump -S '(src 192.168.141.1 or dst 192.168.141.1) and port 12345' -

-S的作用是显示初始序列号,而不是相对序列号。 -

-

第一次握手,服务器进入 SYN-Recv 状态;第三次握手,服务器进入 Establish 状态。

-

因此 TCP 在listen后有两个队列:

- (1)SYN队列(半连接队列):当服务器端收到客户端的SYN报文时,会响应SYN/ACK报文,然后连接就会进入SYN RECEIVED状态,处于SYN RECEIVED状态的连接被添加到SYN队列,并且当它们的状态改变为ESTABLISHED时,即当接收到3次握手中的ACK分组时,将它们移动到accept队列。SYN队列的大小由内核参数/proc/sys/net/ipv4/tcp_max_syn_backlog设置,默认值为128。

- (2)accept队列(完全连接队列):accept队列存放的是已经完成TCP三次握手的连接,而accept系统调用只是简单地从accept队列中取出连接而已,并不是调用accept函数才会完成TCP三次握手。accept队列的大小由内核参数/proc/sys/net/core/somaxconn指定,默认值是128。

-

为什么要存在半连接队列? 因为根据TCP协议的特点,会存在半连接这样的网络攻击存在,即不停的发SYN包,而从不回应SYN_ACK。如果发一个SYN包就让Kernel建立一个消耗极大的sock,那么很容易就内存耗尽。所以内核在三次握手成功之前,只分配一个占用内存极小的request_sock,以防止这种攻击的现象,再配合syn_cookie机制,尽量抵御这种半连接攻击的风险。

-

以下是 Linux5.0.1的内核运行解释。

-

第一次握手时,服务端先创建一个轻量版本的 request_sock,第三次握手时,才会创建 sock,这样可以减少资源的消耗。(Linux 5.0.1)其实没有半连接队列,半连接的 request_sock 指针保存于 inet_hashinfo.ehash 哈希表里,而半连接的统计数据 qlen,保存于 listen sock 的 inet_connection_sock.icsk_accept_queue 里。

-

三次握手后,request_sock 指针会保存于全连接队列:inet_connection_sock.icsk_accept_queue.rskq_accept_head,等待 accept。

-

-

参考博客 listen (tcp)

8. 创建绑定监听socket实验

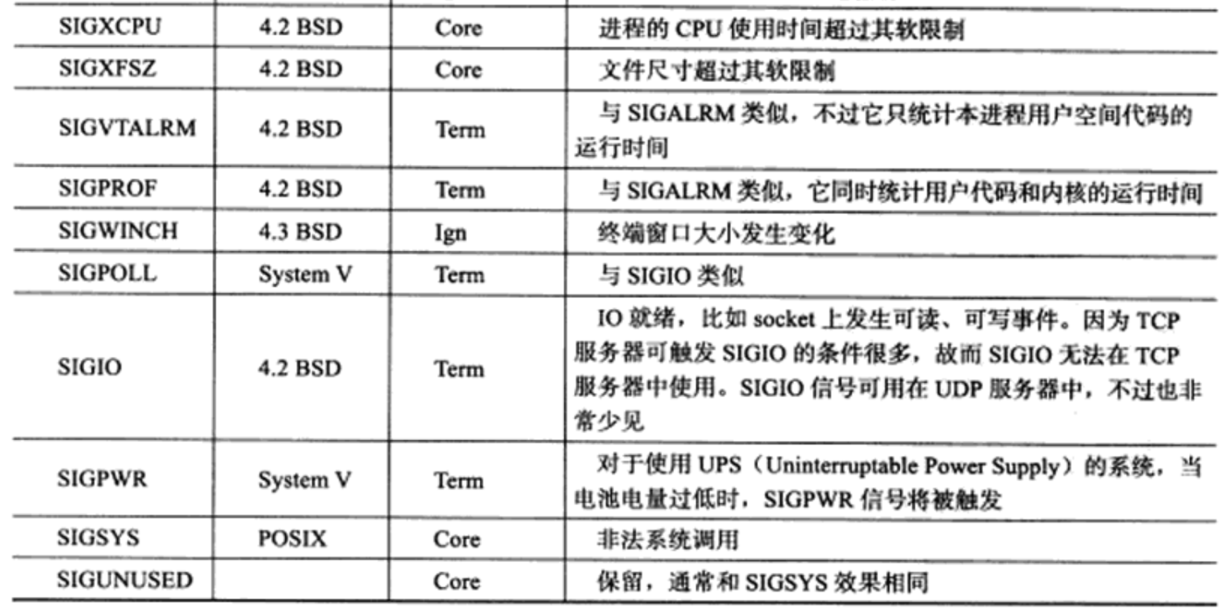

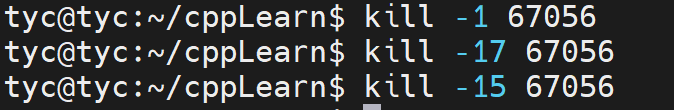

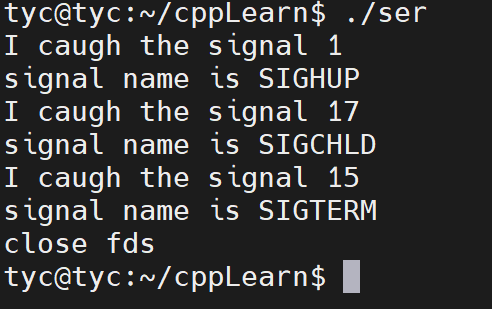

8.1 signal 系统调用

-

signal()是一个用于处理Unix和类Unix操作系统(如Linux)中的信号的系统调用。信号是用于在进程间或者进程内部传递通知或者异常事件的机制。信号可以由用户按下某个键、硬件异常、软件中断或者其他进程产生。signal()系统调用允许进程捕获、忽略或者改变特定信号的默认处理行为。

-

函数原型

-

1 2 3 4 5 6 7 8 9 10 11 12 13#include <signal.h> //使用此函数需导入此头文件 // sighandler_t 为函数指针类型,其指向一个参数为int,返回值为void的函数。 typedef void (*sighandler_t)(int); sighandler_t signal(int signum, sighandler_t handler); /* 参数: (1)int signum:指定要处理的信号。例如:SIGINT(终端中断)、SIGTERM(终止信号)等。 (2)sighandler_t handler:一个函数指针。可以是一个用户定义的函数,或者特殊值SIG_IGN(忽略信号)和SIG_DFL(使用默认处理行为)。 返回值: 如果成功,signal()返回之前的信号处理函数指针;否则,返回SIG_ERR,并设置errno以表示错误原因。 */ -

除了用户自定义信号处理函数外,

bits/signum.h头文件中还定义了信号的两种其他处理SIG_IGN和SIG_DEL: -

1 2 3#define SIG_ERR ((__sighandler_t) -1) /* Error return. */ #define SIG_DFL ((__sighandler_t) 0) /* Default action. */ #define SIG_IGN ((__sighandler_t) 1) /* Ignore signal. */ -

SIG_IGN表示忽略目标信号,SIG_DFL表示使用信号的默认处理方式。信号的默认处理方式有如下几种:结束进程(Term)、 忽略信号(Ign)、 结束进程并生成核心转储文件(Core)、暂停进程(Stop), 以及继续进程(Cont)。 -

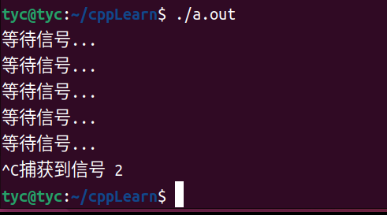

下面是一个简单的cpp程序,使用signal()捕获SIGINT程序终止信号(当用户按下Ctrl+C时产生)并执行自定义处理函数。

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22#include <signal.h> #include <stdio.h> #include <stdlib.h> #include <unistd.h> bool fg = true; void sigint_handler(int sig) { printf("捕获到信号 %d\n", sig); fg = false; } int main() { signal(SIGINT, sigint_handler); while (fg) { printf("等待信号...\n"); sleep(1); } return 0; } -

-

signal()在不同的Unix和类Unix系统中的行为可能会有所不同。对于可移植性和更多功能,推荐使用sigaction()系统调用。

-

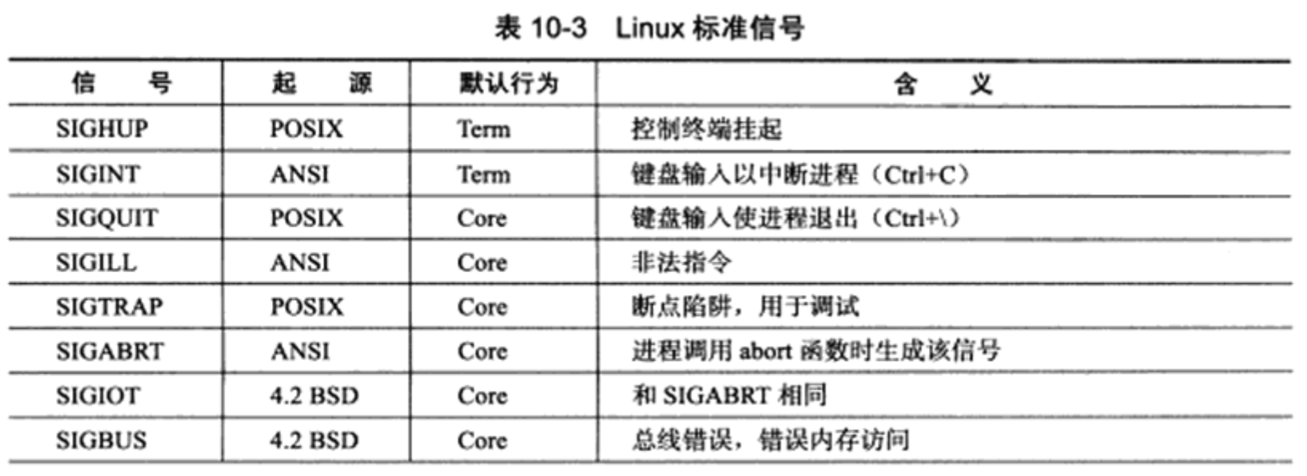

这里浅浅说一下信号。

-

信号可以直接进行用户空间进程和内核空间进程的交互,内核进程可以利用它来通知用户空间进程发生了哪些系统事件。

每个信号的名字都以字符 SIG 开头。 每个信号和一个数字编码相对应,在头文件 signum.h 中,这些信号都被定义为正整数。

-

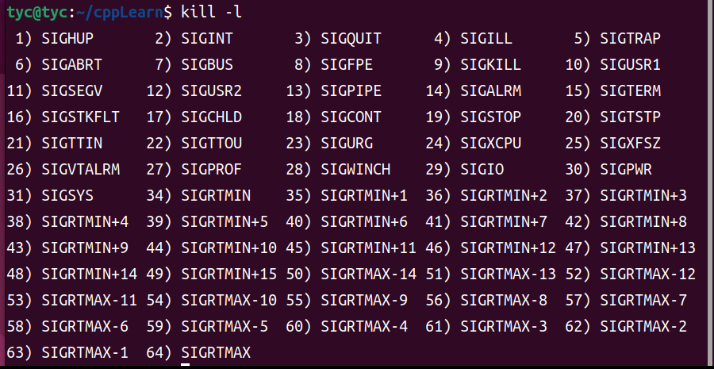

在 Linux 下,要想查看这些信号和编码的对应关系,可使用命令:kill -l

-

-

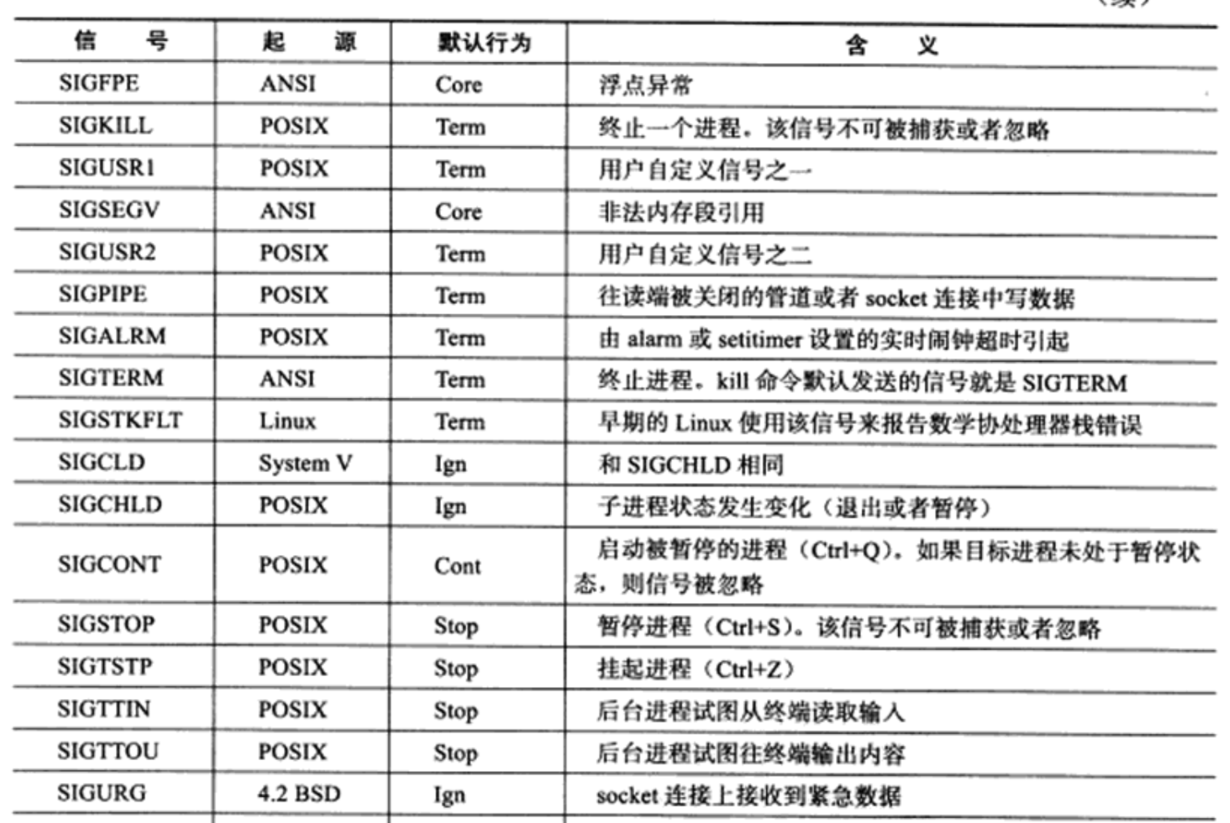

以下是部分信号解释

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 351) SIGHUP 本信号在用户终端连接(正常或非正常)结束时发出, 通常是在终端的控制进程结束时, 通知同一session内的各个作业, 这时它们与控制终端不再关联. 2) SIGINT 程序终止(interrupt)信号, 在用户键入INTR字符(通常是Ctrl-C)时发出。 3) SIGQUIT 和SIGINT类似, 但由QUIT字符(通常是Ctrl-)来控制. 进程在因收到 SIGQUIT退出时会产生core文件, 在这个意义上类似于一个程序错误信号. 4) SIGILL 执行了非法指令. 通常是因为可执行文件本身出现错误, 或者试图执行 数据段. 堆栈溢出时也有可能产生这个信号. 5) SIGTRAP 由断点指令或其它trap指令产生. 由debugger使用. 6) SIGABRT 程序自己发现错误并调用abort时产生. 7) SIGBUS 非法地址, 包括内存地址对齐(alignment)出错. eg: 访问一个四个字长 的整数, 但其地址不是4的倍数. 8) SIGFPE 在发生致命的算术运算错误时发出. 不仅包括浮点运算错误, 还包括溢 出及除数为0等其它所有的算术的错误. 9) SIGKILL 用来立即结束程序的运行. 本信号不能被阻塞, 处理和忽略. 10) SIGUSR1 留给用户使用 11) SIGSEGV 试图访问未分配给自己的内存, 或试图往没有写权限的内存地址写数据. 12) SIGUSR2 留给用户使用 13) SIGPIPE Broken pipe 14) SIGALRM 时钟定时信号, 计算的是实际的时间或时钟时间. alarm函数使用该信号. 15) SIGTERM 程序结束(terminate)信号, 与SIGKILL不同的是该信号可以被阻塞和处理. 通常用来要求程序自己正常退出. shell命令kill缺省产生这个信号. 17) SIGCHLD 子进程结束时, 父进程会收到这个信号. 18) SIGCONT 让一个停止(stopped)的进程继续执行. 本信号不能被阻塞. 可以用 一个handler来让程序在由stopped状态变为继续执行时完成特定的工作. 例如, 重新显示提示符. 19) SIGSTOP 停止(stopped)进程的执行. 注意它和terminate以及interrupt的区别: 该进程还未结束, 只是暂停执行. 本信号不能被阻塞, 处理或忽略. 20) SIGTSTP 停止进程的运行, 但该信号可以被处理和忽略. 用户键入SUSP字符时 (通常是Ctrl-Z)发出这个信号. 21) SIGTTIN 当后台作业要从用户终端读数据时, 该作业中的所有进程会收到SIGTTIN 信号. 缺省时这些进程会停止执行. 22) SIGTTOU 类似于SIGTTIN, 但在写终端(或修改终端模式)时收到. 23) SIGURG 有"紧急"数据或out-of-band数据到达socket时产生. 24) SIGXCPU 超过CPU时间资源限制. 这个限制可以由getrlimit/setrlimit来读取/ 改变 25) SIGXFSZ 超过文件大小资源限制. 26) SIGVTALRM 虚拟时钟信号. 类似于SIGALRM, 但是计算的是该进程占用的CPU时间. 27) SIGPROF 类似于SIGALRM/SIGVTALRM, 但包括该进程用的CPU时间以及系统调用的时间. 28) SIGWINCH 窗口大小改变时发出. 29) SIGIO 文件描述符准备就绪, 可以开始进行输入/输出操作. 有两个信号可以停止进程:SIGTERM和SIGKILL。 SIGTERM比较友好,进程能捕捉这个信号,根据您的需要来关闭程序。在关闭程序之前,您可以结束打开的记录文件和完成正在做的任务。在某些情况下,假如进程正在进行作业而且不能中断,那么进程可以忽略这个SIGTERM信号。 对于SIGKILL信号,进程是不能忽略的。这是一个 “我不管您在做什么,立刻停止”的信号。假如您发送SIGKILL信号给进程,Linux就将进程停止在那里。 -

SIGINT:程序终止信号。当用户按下CRTL+C时通知前台进程组终止进程 或者

kill -2 <pid>触发。 -

SIGTERM:程序结束信号, 可以使用

kill -15 <pid>触发 -

SIGKILL:用来立即结束程序的运行。可以使用

kill -9 <pid>触发 -

SIGTERM和SIGKILL的区别:SIGTERM信号是可以被捕获的,因此可以尝试block,或者忽视,但是SIGKILL不能。

8.2 实验

-

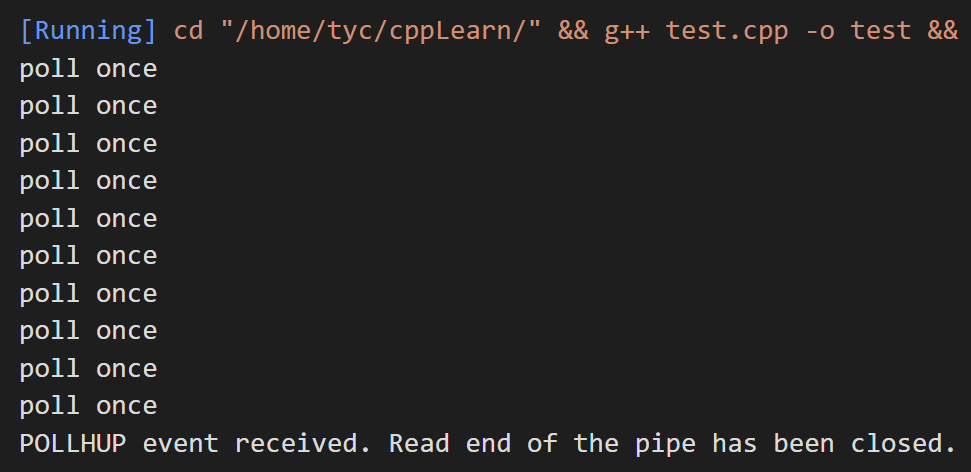

这里需要注意的是,为sockaddr_in成员赋值时需要显式地将主机字节序转换为网络字节序,而通过 write()/send() 函数发送数据时TCP协议会自动转换为网络字节序,不需要再调用相应的函数。

-

实验代码

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58#include <arpa/inet.h> #include <assert.h> #include <netinet/in.h> #include <signal.h> #include <stdio.h> #include <stdlib.h> #include <string.h> #include <sys/socket.h> #include <unistd.h> static bool stop = false; static void handle_term(int sig) { stop = true; } int main(int argc, char *argv[]) { signal(SIGTERM, handle_term); if (argc <= 3) { printf("usage: %s ip_address port_number backlog\n", basename(argv[0])); return 1; } // 输入的ip、端口、个数 const char *ip = argv[1]; int port = atoi(argv[2]); int backlog = atoi(argv[3]); int sock = socket(PF_INET, SOCK_STREAM, 0); assert(sock >= 0); // 创建 socket 地址 struct sockaddr_in address; /* bzero()函数已经被标记为废弃函数,不再建议使用。 在新的代码中,可以使用memset()函数来代替bzero()函数。 bzero(&address, sizeof(address)); */ memset(&address, 0, sizeof(address)); address.sin_family = AF_INET; // 转换为网络字节序的整数ip inet_pton(AF_INET, ip, &address.sin_addr); // 转换为网络字节序的端口号 address.sin_port = htons(port); int ret = bind(sock, (struct sockaddr *)&address, sizeof(address)); assert(ret != -1); // 创建监听队列 ret = listen(sock, backlog); assert(ret != -1); // 一直监听,等待手动退出 kill -15 while (!stop) { sleep(1); } close(sock); return 0; } -

本地ip地址为 192.168.141.1,服务器地址为 192.168.141.128。

-

(1) 首先在服务器运行上述程序

-

1./listen 192.168.141.128 12345 4 -

(2) 然后在服务器创建监视的命令

-

1watch -n 1 "netstat -an | grep 12345 >> a.txt" -

(3) 最后依次在本地多次telent服务器,至少执行6次。

-

1telnet 192.168.141.128 12345 -

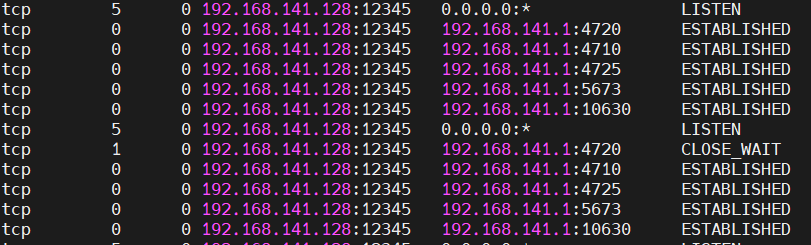

(4) 结果分析

-

首先可以看到,本地的第6次telnet,就无法连接成功了。可见,在监听队列中,处于ESTABLISHED状态的最多连接只有5个(backlog值加1)。

-

其次服务器重定向输出到txt的结果中,可见确实只有5个连接。

-

1 2 3 4 5 6tcp 5 0 192.168.141.128:12345 0.0.0.0:* LISTEN tcp 0 0 192.168.141.128:12345 192.168.141.1:4720 ESTABLISHED tcp 0 0 192.168.141.128:12345 192.168.141.1:4710 ESTABLISHED tcp 0 0 192.168.141.128:12345 192.168.141.1:4725 ESTABLISHED tcp 0 0 192.168.141.128:12345 192.168.141.1:5673 ESTABLISHED tcp 0 0 192.168.141.128:12345 192.168.141.1:10630 ESTABLISHED -

-

这里说明一下,虽然连接队列的最大长度是指定的,但这只是影响在队列中等待的连接请求的数量。一旦父进程或任意子进程调用

accept来接受一个连接,就会从队列中取出一个连接进行处理。

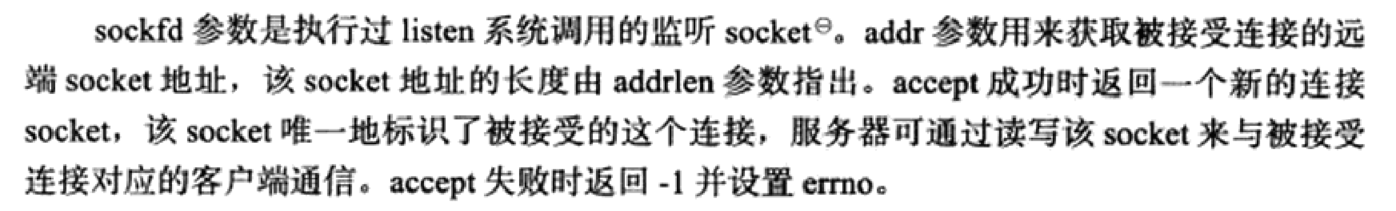

9. 接受连接 accept

9.1 函数详解

-

listen函数存在最大连接队列长度,因此需要accept函数来取出连接进行处理。

-

listen函数不会阻塞,它只是相当于把socket的属性更改为被动连接,可以接收其他进程的连接。listen侦听的过程并阻塞的,它只是设置好socket的属性之后就会返回。监听的过程实质由操作系统完成。但是accept会阻塞(也可以设置为非阻塞),如果listen的套接字对应的连接请求队列为空(没有客户端连接请求),它会一直阻塞等待。

-

accept()函数本身是阻塞等待的。

-

accept()接受一个客户端的连接请求(从ESTABLISHED完全连接队列里面提出),并返回一个新的套接字socket描述符。

-

所谓“新的”就是说这个套接字与socket()返回的用于监听和接受客户端的连接请求的套接字不是同一个套接字。与本次接受的客户端的通信是通过在这个新的套接字上发送和接收数据来完成的,这样的好处是可以进行并发通信。

-

1 2 3# include <sys/types.h> # include <sys/socket.h> int accept(int sockfd, struct sockaddr *addr, socklen_t *addrlen); -

参数一sockfd:用来标识服务端套接字(也就是listen函数中设置为监听状态的套接字); 参数二addr:是用来保存客户端套接字对应的内存空间变量(包括客户端IP和端口信息等); 参数三addrlen:参数二内存空间大小。

-

返回值

1)成功: 返回一个服务器用于以后通信的“通信描述符”,即通信的socket描述符。 2)失败: 返回-1,并设置errno。

-

-

需要注意的是,三次握手完成后,服务器可以调用accept()接受连接,如果服务器调用accept()时还没有客户端的连接请求,就阻塞等待直到有客户端连接上来。

-

可见accept函数本身并不会等待一个特定的时间,而是会一直阻塞,直到有一个客户端连接请求到达为止。当有一个连接请求到达时,accept函数会返回一个新的套接字描述符,用于与客户端进行通信。

9.2 实验

-

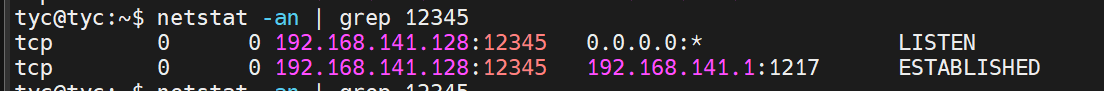

现在考虑如下情况:如果监听队列中处于ESTABLISHED状态的连接对应的客户端出现网络异常(比如掉线),或者客户端直接关闭,那么服务器对这个连接执行的accept调用是否成功?实验代码如下。

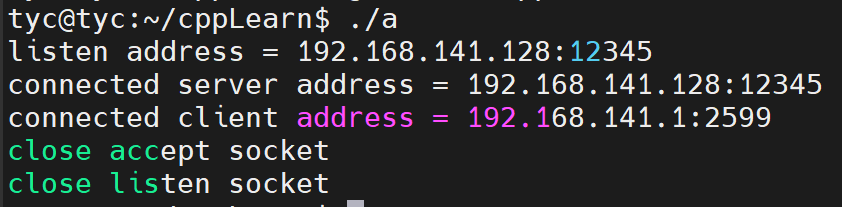

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63#include <arpa/inet.h> #include <assert.h> #include <errno.h> #include <netinet/in.h> #include <stdio.h> #include <stdlib.h> #include <string.h> #include <sys/socket.h> #include <unistd.h> int main(int argc, char *argv[]) { // if (argc <= 2) { // printf("usage: %s ip_address port_number\n", basename(argv[0])); // return 1; // } // const char *ip = argv[1]; // int port = atoi(argv[2]); const char *ip = "192.168.141.128"; int port = 12345; // 创建socket struct sockaddr_in address; memset(&address, 0, sizeof(address)); address.sin_family = AF_INET; inet_pton(AF_INET, ip, &address.sin_addr); address.sin_port = htons(port); int sock = socket(PF_INET, SOCK_STREAM, 0); assert(sock >= 0); // 绑定 int ret = bind(sock, (struct sockaddr *)&address, sizeof(address)); assert(ret != -1); // 监听 ret = listen(sock, 5); assert(ret != -1); // 接受一个连接 struct sockaddr_in client; socklen_t client_addrlength = sizeof(client); int connfd = accept(sock, (struct sockaddr *)&client, &client_addrlength); if (connfd < 0) { printf("errno is: %d\n", errno); } else { char remote[INET_ADDRSTRLEN]; const char *clientIp = inet_ntop(AF_INET, &client.sin_addr, remote, INET_ADDRSTRLEN); // 输出客户端 IP地址 和 端口号 printf("connected with ip: %s and port: %d\n", clientIp, ntohs(client.sin_port)); // 等待20s客户端进行提前关闭 sleep(20); close(connfd); printf("close accept socket\n"); } sleep(2); close(sock); printf("close listen socket\n"); return 0; } -

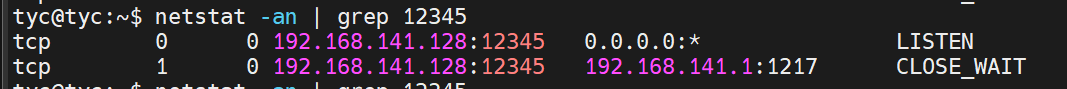

(1)在服务器运行上述程序之后,本地在20s范围内在命令行输入

telnet 192.168.141.128 12345,然后按ctrl+]马上断开客户端网络,此时查看服务器的socket状态如下: -

-

这种输出说明,accept调用对客户端网络断开毫不知情。

-

(2)这时候直接关闭客户端程序,即关闭命令行界面。此时查看服务器的socket状态如下:

-

-

-

可以看到 CLOSE_WAIT 状态是由客户端发起关闭请求后进入的状态。

-

(3)上两次关闭,服务器均可正常输出。

-

10. 客户端发起连接 connect

-

如果说服务器通过listen调用来被动接受连接,那么客户端需要通过connect系统调用来主动与服务器建立连接。

-

在Linux系统中,

connect函数默认是阻塞的。当调用connect函数时,如果连接建立成功,该函数会立即返回;如果连接建立失败或者正在进行连接过程中,connect函数会阻塞程序的执行,直到连接建立成功或者发生错误(判断无法正常连接)。 -

1 2 3 4 5 6 7 8 9 10#include <sys/types.h> #include <sys/socket.h> int connect(int sockfd, const struct sockaddr *server_addr, socklen_t *addrlen); /** * 建立连接 * @param sockfd: socket函数返回的一个socket,用于标识该连接; * @param server_addr: 服务端地址, ip地址+端口号; * @param addrlen: 服务端地址地址长度; * @return 函数执行成功返回0,失败返回-1 */ -

一旦成功建立连接,sockfd就唯一地标识了这个连接,客户端就可以通过读写sockfd来与服务器通信。

-

connect失败则返回-1并设置errno。其中两种常见的errno是ECONNREFUSED和ETIMEDOUT,它们的含义如下

- ECONNREFUSED,目标端口不存在,连接被拒绝。

- ETIMEDOUT,连接超时。

11. 关闭连接 close 和 shutdown

11.1 函数详解

-

(1)close

-

1 2 3 4#include <unistd.h> int close(int fd) // fd 是待关闭的socket描述符 // 返回值:成功返回0,出错返回-1并设置errno- 读方向上,内核会将套接字设置为不可读,任何读操作都会返回异常;

- 写方向上,内核会尝试将发送缓冲区的数据发送给对端,之后发送fin包结束连接,这个过程中,往套接字写入数据都会返回异常。

- 若对端还发送数据过来,会返回对方一个rst报文。

-

因此 close 终止了两个数据传输的方向。

-

套接字会维护一个计数,当有一个进程持有,计数加一,close调用时会检查计数,只有当计数为0时,才会关闭连接,否则,只是将套接字的计数减一。

-

多进程程序中,一次fork系统调用默认将使父进程中打开的socket的引用计数加1,因此我们必须在父进程和子进程中都对该socket执行close调用才能将连接关闭。

-

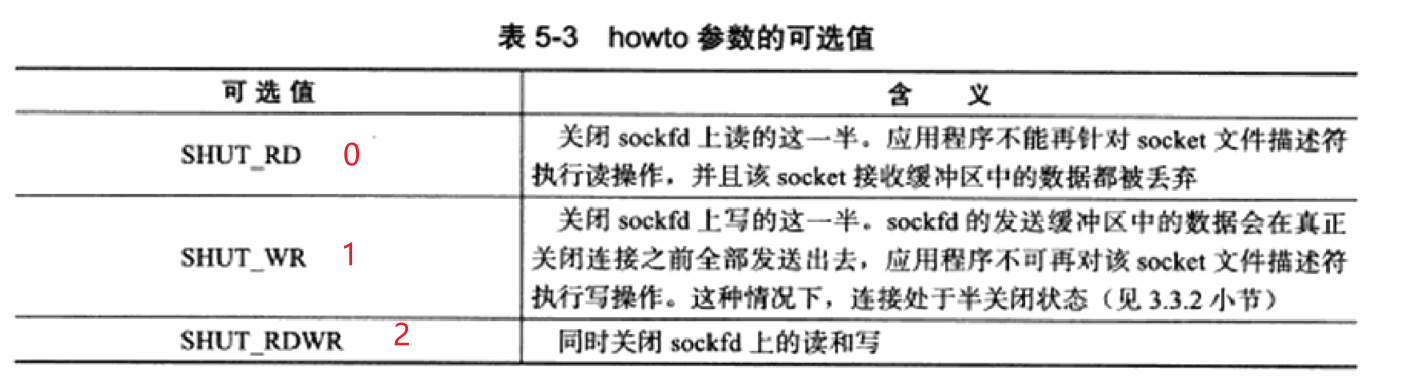

(2)shutdown

-

1 2#include <sys/socket.h> int shutdown(int sockfd, int howto) -

shutdown显得更加优雅,能控制只关闭连接的一个方向;

-

sockfd参数是待关闭的socket,howto参数决定了shutdown的行为。

howto = 0关闭连接的读方向,对该套接字进行读操作直接返回EOF;将接收缓冲区中的数据丢弃,之后再有数据到达,会对数据进行ACK,然后悄悄丢弃。howto = 1关闭连接的写方向,会将发送缓冲区上的数据发送出去,然后发送fin包;应用程序对该套接字的写入操作会返回异常(shutdown不会检查套接字的计数情况,会直接关闭连接)howto = 20+1各操作一遍,关闭连接的两个方向。

-

-

shutdown成功时返回0,失败则返回-1并设置error。

-

(3)考虑如下场景:

-

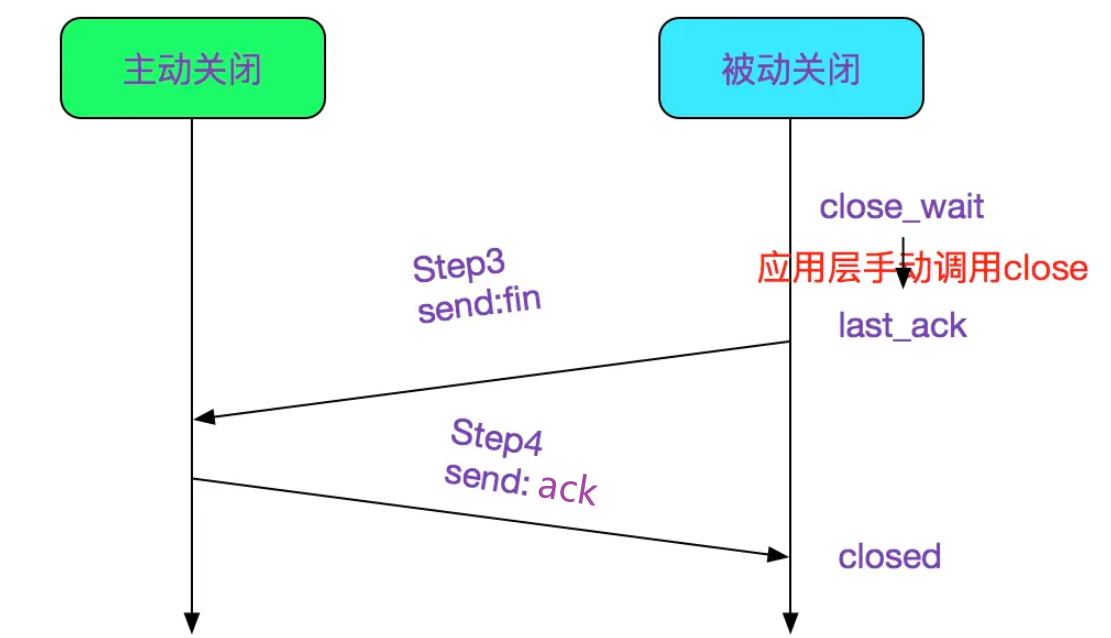

我们知道,TCP的四次挥手是半关闭的操作,即服务器收到客户端的 FIN 报文时,先回一个 ACK 应答报文,而服务端可能还有数据需要处理和发送 。等服务端不再发送数据时,才发送 FIN 报文给客户端来表示同意现在关闭连接。

-

假设现在客户端调用了close同时关闭了读写,然后服务端收到了FIN报文,这时候服务器端套接字缓冲区还有数据未发送出去,这时候服务端socket是否会将这些发送出去呢,如果发送出去了,客户端是否会接收呢?

-

解答:

-

客户端调用close后,会尽量将内核中的数据发送出去,然后调用FIN包结束连接;同时会关闭读写两个方向的缓冲区。

-

这个时候如果服务端调用write写数据时,可能会发现write能正常返回,但最终会收到一个RST重置报文。因为发送数据分两步:

- write将数据写入到内核缓冲区中,这一步是可以成功的。

- 内核缓冲区将数据发送到客户端,这个时候由于客户端已经关闭了接收缓冲区,无法正常接收,所以会回复一个rst报文让服务端重置连接。

-

所以,「想要服务端收到客户端FIN报文后能继续向客户端发数据,客户端必须使用shutdown SHUT_WR?」 是的。再多提一点,服务端当收到rst包后,继续往关闭的socket中写数据,会触发SIGPIPE信号, 该信号默认结束进程。 所以你可以发现很多服务端,都会忽略sigpipe信号的处理,避免客户端粗鲁关闭+服务器端对客户端断开连接读写处理不当导致整个进程奔溃。

-

(4)close 和 shutdown的区别

-

close 会关闭 fd,而shutdown不会;在使用了shutdown SHUT_RDWR 后,仍然需要close来关闭这个文件描述符。

-

close 在fd 被多进程持有或被复制时,不会立马关闭连接,只是使得引用个数减1,直到等于0才实际关闭;shutdown SHUT_RDWR会直接关闭连接(发送FIN),而无论是否有其他打开的文件描述符指向套接字。

-

因此,优雅地关闭连接,一般是shutdown读端和写端,接着close。

11.2 close 源码分析

-

(1) close (int fd) 是通过系统调用 sys_close 来执行的:

-

1 2 3 4 5 6 7 8 9 10 11asmlinkage long sys_close(unsigned int fd) { // 清除(close_on_exec即退出进程时)的位图标记 FD_CLR(fd, fdt->close_on_exec); // 释放文件描述符 // 将fdt->open_fds即打开的fd位图中对应的位清除 // 再将fd挂入下一个可使用的fd以便复用 __put_unused_fd(files, fd); // 调用file_pointer的close方法真正清除 retval = filp_close(filp, files); } -

(2) 我们看到最终是调用的 filp_close 方法:

-

1 2 3 4 5 6 7 8 9int filp_close(struct file *filp, fl_owner_t id) { // 如果存在flush方法则flush if (filp->f_op && filp->f_op->flush) filp->f_op->flush(filp, id); // 调用fput fput(filp); ...... } -

(3) 紧接着我们进入fput(filp);

-

1 2 3 4 5 6 7void fastcall fput(struct file *file) { // 对应file->count--,同时检查是否还有关于此file的引用 // 如果没有,则调用_fput进行释放 if (atomic_dec_and_test(&file->f_count)) __fput(file); } -

这个函数的前半部分是为了减少打开的socket的引用计数,进而判断是否真的需要 close 这个socket。

-

同一个 file (socket) 有多个引用的情况很常见,例如下面的例子:

-

-

所以在多进程的 socket 服务器编写过程中,父进程也需要 close (fd) 一次,以免 socket 无法最终关闭。

-

(4) 然后进入 __fput(file) 函数。

-

1 2 3 4 5 6 7 8void fastcall __fput(struct file *file) { // 从eventpoll中释放file eventpoll_release(file); // 如果是release方法,则调用release if (file->f_op && file->f_op->release) file->f_op->release(inode, file); } -

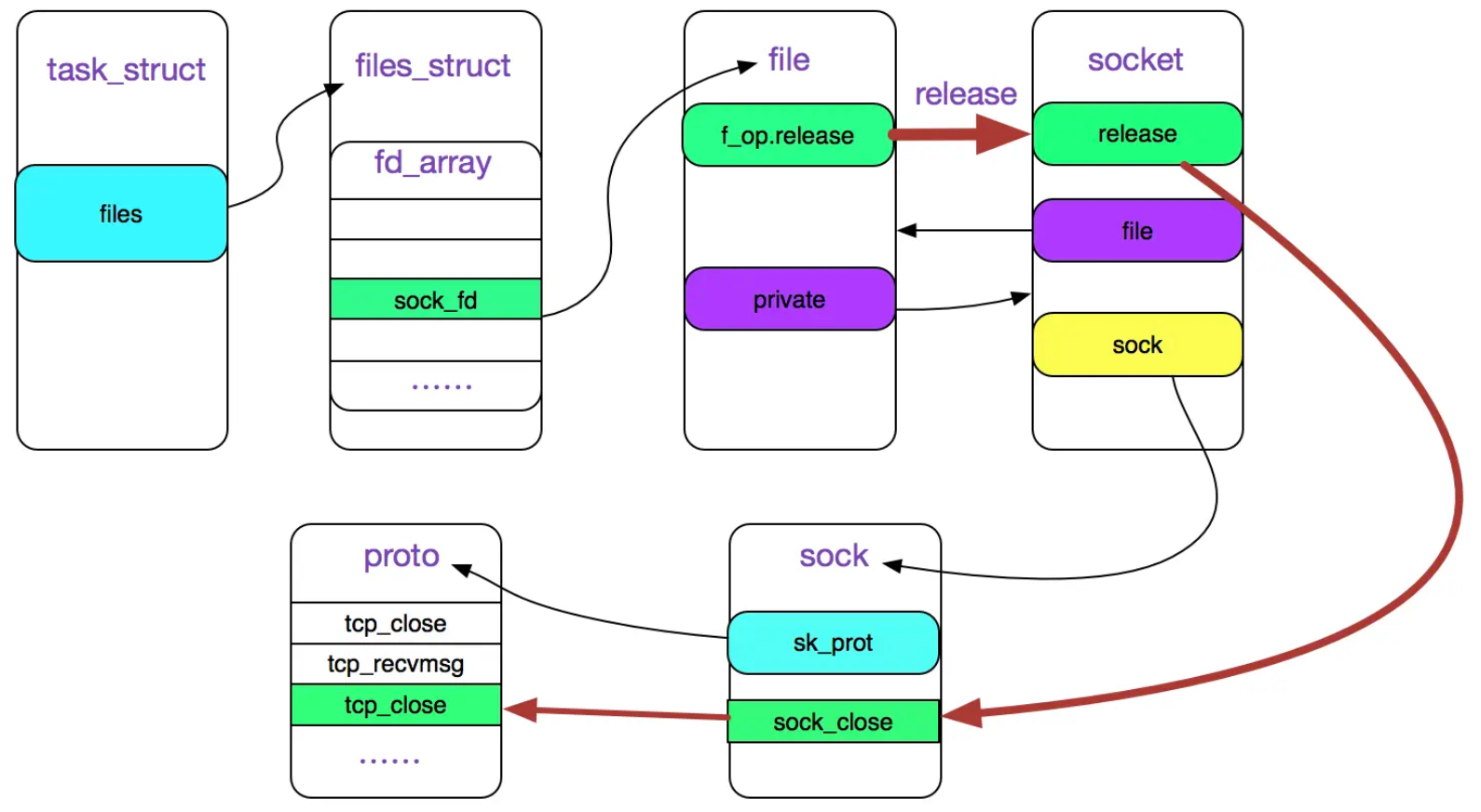

由于我们讨论的是 socket 的 close, 所以,我们重点探查下

file->f_op->release在 socket 情况下的实现: -

在C语言中,通过函数指针实现重载,即多态。

-

可以看到,最终会调用文件系统对应的

release()方法来处理关闭操作。对于 socket 文件系统,release()方法对应的是sock_close()函数。 -

(5) 进入 sock_close 函数

-

sock_close 用来关闭套接口文件。

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17static int sock_close(struct inode *inode, struct file *filp) { /* * It was possible the inode is NULL we were * closing an unfinished socket. */ if (!inode) { printk(KERN_DEBUG "sock_close: NULL inode\n"); return 0; } //与从文件描述符filp关联的套接口异步通知队列中删除与文件描述符filp有关的异步通知节点。 sock_fasync(-1, filp, 0); //关闭套接口 sock_release(SOCKET_I(inode)); return 0; } -

(6) 然后进入 sock_release 函数

-

sock_release 来实现关闭套接口功能。

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23void sock_release(struct socket *sock) { if (sock->ops) { struct module *owner = sock->ops->owner; sock->ops->release(sock); // inet_release sock->ops = NULL; module_put(owner); } //处理异步通知队列之后,若还发现异步通知队列不为空,表明系统有问题,打印信息提示 if (sock->fasync_list) printk(KERN_ERR "sock_release: fasync list not empty!\n"); //更新sockets_in_use,该字段主要用来统计当前cpu打开的套接口文件的数量 get_cpu_var(sockets_in_use)--; put_cpu_var(sockets_in_use); // 释放i节点和套接口 if (!sock->file) { iput(SOCK_INODE(sock)); return; } sock->file = NULL; } -

可以看到,最终会调用到sock->ops->release(sock);依据函数重载,以及TCP/IP协议,sock->ops->release(sock)对应的方法实际上就是inet_release函数。

-

1 2 3sock_close |-sock_release |-sock->ops->release(sock); -

(7) 进入inet_release函数

-

inet_release 为 IPV4 协议中 close 系统调用的套接口层的实现。

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22int inet_release(struct socket *sock) { struct sock *sk = sock->sk; if (sk) { long timeout; /* Applications forget to leave groups before exiting */ ip_mc_drop_socket(sk); /*timeout的值和SOCK_LINGER选项有关,这个选项可以通过setsockopt()来设置, 该选项表示在关闭连接时需要等待的时间,设置的事件值保存在sk_lingertime */ timeout = 0; if (sock_flag(sk, SOCK_LINGER) && !(current->flags & PF_EXITING)) timeout = sk->sk_lingertime; sock->sk = NULL; sk->sk_prot->close(sk, timeout);//tcp_close } return 0; } -

最终会调用到 sk->sk_prot->close 函数,对于 TCP 协议来说,就是tcp_close函数。

-

-

(8) 进入最终boss函数 tcp_close

-

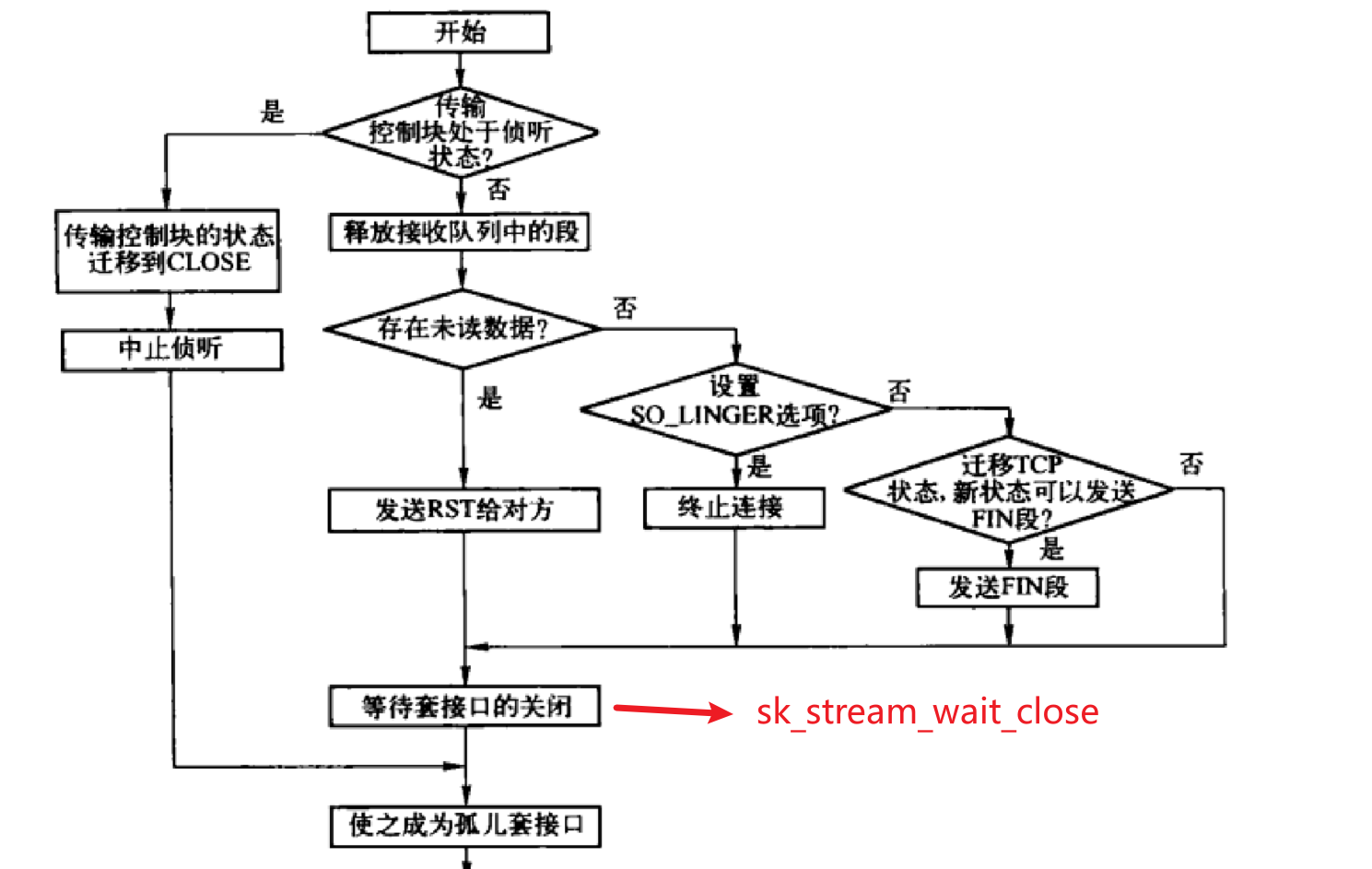

对于TCP,关闭套接口的实现为 tcp_close。

-

有些概念这里需要说明下:

-

(a)skb(struct sk_buffer)是TCP/IP堆栈中用于收发包的缓冲区域。它在接收数据的时候会进行2次拷贝,以提升性能:数据包进入网卡驱动后拷贝一次,从内核空间递交给用户空间的应用时再拷贝一次。网络中所有数据包的封装及解封都是通过这个结构进行的。

-

(b)tcp_close_state 函数的作用是进行 TCP 的状态转移,并判断是否可以发送 FIN 报文。

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19/* Location: net/ipv4/tcp.c Function: 进行状态转移,并且判断是否可以发送 FIN。 Parameter: sk: 传输控制块 */ static int tcp_close_state(struct sock *sk) { int next = (int)new_state[sk->sk_state]; /* 去除可能的 FIN_ACTION*/ int ns = next & TCP_STATE_MASK; /* 根据状态图进行状态转移 */ tcp_set_state(sk, ns); /* 如果需要执行发送 FIN 的动作,则返回真 */ return next & TCP_ACTION_FIN; } -

tcp_close_state 的作用就是根据sk当前状态来设置sk下一状态,比如当前状态为TCP_ESTABLISHED,则下一状态为TCP_FIN_WAIT1。该函数的返回要么为0,要么为TCP_ACTION_FIN。为0说明不需要发送fin报文。为TCP_ACTION_FIN说明需要发送FIN报文。

-

-

(c)tcp_time_wait 函数的作用是主动进入TIME_WAIT 状态,分为两种情况,Move a socket to time-wait or dead fin-wait-2 state.

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84/* * Move a socket to time-wait or dead fin-wait-2 state. */ /* * @sk: 被取代的传输控制块。 * @state: timewait控制块内部的状态,为FIN_WAIT2或TIME_WAIT,即子状态 * @timeo: 等待超时时间 sock结构进入TIME_WAIT状态有两种情况: (1)一种是在真正进入了TIME_WAIT状态,即在规定时间内主动关闭端收到了第二个fin进入time_wait状态; (2)还有一种是FIN_WAIT_2的TIME_WAIT状态。 之所以让FIN_WAIT_2状态在没有接收到FIN包的情况下也可以进入TIME_WAIT状态,是因为tcp_sock结构占用的资源要比tcp_timewait_sock结构占用的资源多,而且在TIME_WAIT下也可以处理连接的关闭。内核在处理时通过inet_timewait_sock结构的tw_substate成员(子状态)来区分这种两种情况。 */ void tcp_time_wait(struct sock *sk, int state, int timeo) { const struct inet_connection_sock *icsk = inet_csk(sk); const struct tcp_sock *tp = tcp_sk(sk); struct net *net = sock_net(sk); struct inet_timewait_sock *tw; tw = inet_twsk_alloc(sk, &net->ipv4.tcp_death_row, state); if (tw) { struct tcp_timewait_sock *tcptw = tcp_twsk((struct sock *)tw); const int rto = (icsk->icsk_rto << 2) - (icsk->icsk_rto >> 1); struct inet_sock *inet = inet_sk(sk); tw->tw_transparent = inet->transparent; tw->tw_mark = sk->sk_mark; tw->tw_priority = sk->sk_priority; tw->tw_rcv_wscale = tp->rx_opt.rcv_wscale; tcptw->tw_rcv_nxt = tp->rcv_nxt; tcptw->tw_snd_nxt = tp->snd_nxt; tcptw->tw_rcv_wnd = tcp_receive_window(tp); tcptw->tw_ts_recent = tp->rx_opt.ts_recent; tcptw->tw_ts_recent_stamp = tp->rx_opt.ts_recent_stamp; tcptw->tw_ts_offset = tp->tsoffset; tcptw->tw_last_oow_ack_time = 0; tcptw->tw_tx_delay = tp->tcp_tx_delay; tw->tw_txhash = sk->sk_txhash; #if IS_ENABLED(CONFIG_IPV6) if (tw->tw_family == PF_INET6) { struct ipv6_pinfo *np = inet6_sk(sk); tw->tw_v6_daddr = sk->sk_v6_daddr; tw->tw_v6_rcv_saddr = sk->sk_v6_rcv_saddr; tw->tw_tclass = np->tclass; tw->tw_flowlabel = be32_to_cpu(np->flow_label & IPV6_FLOWLABEL_MASK); tw->tw_ipv6only = sk->sk_ipv6only; } #endif tcp_time_wait_init(sk, tcptw); /* Get the TIME_WAIT timeout firing. */ if (timeo < rto) timeo = rto; if (state == TCP_TIME_WAIT) timeo = TCP_TIMEWAIT_LEN; /* tw_timer is pinned, so we need to make sure BH are disabled * in following section, otherwise timer handler could run before * we complete the initialization. */ local_bh_disable(); inet_twsk_schedule(tw, timeo); /* Linkage updates. * Note that access to tw after this point is illegal. */ inet_twsk_hashdance(tw, sk, net->ipv4.tcp_death_row.hashinfo); local_bh_enable(); } else { /* Sorry, if we're out of memory, just CLOSE this * socket up. We've got bigger problems than * non-graceful socket closings. */ NET_INC_STATS(net, LINUX_MIB_TCPTIMEWAITOVERFLOW); } // 设置sk状态为TCP_CLOSE,然后回收sk资源 tcp_update_metrics(sk); tcp_done(sk); }

-

-

-

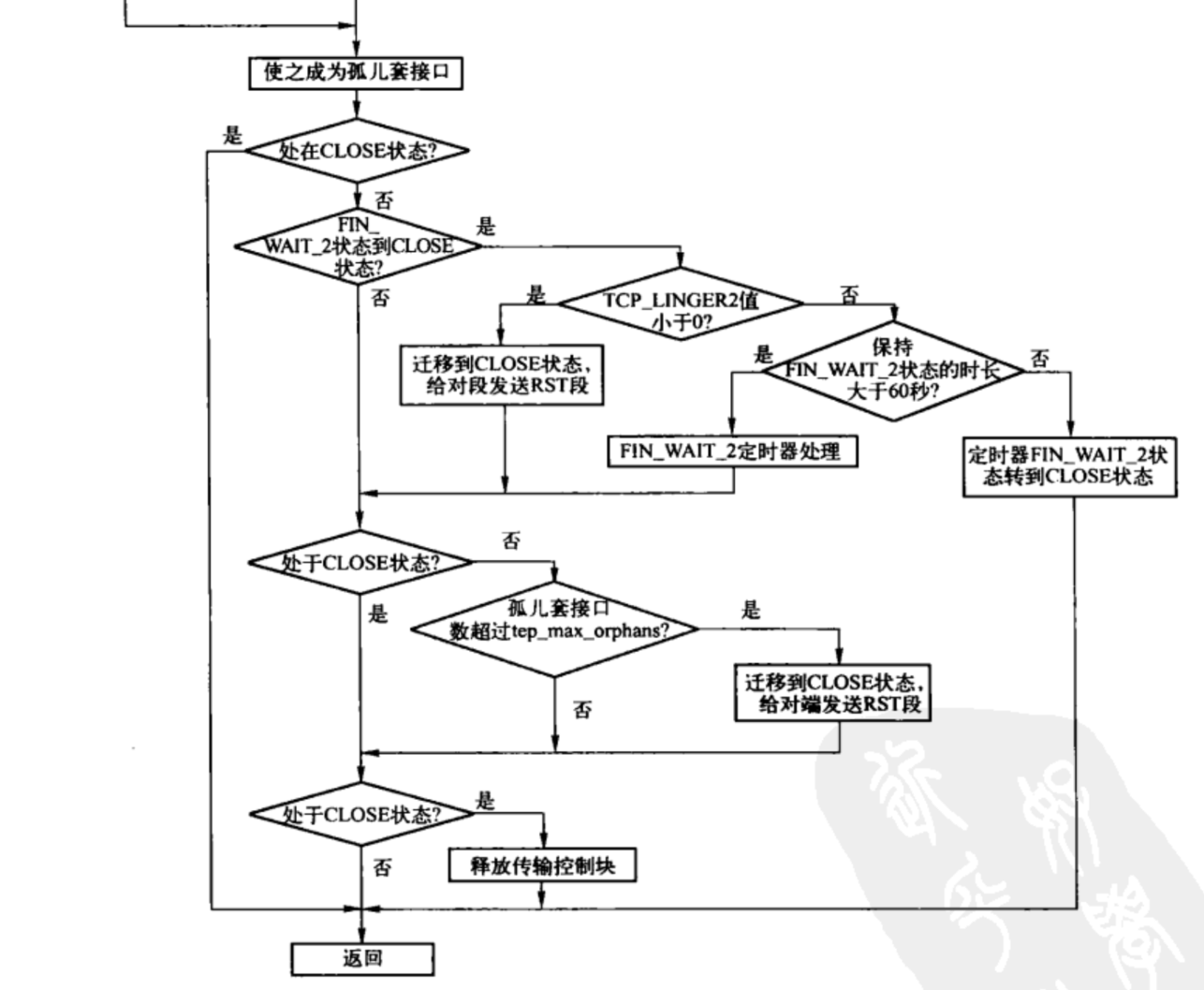

tcp_close 源码分析如下:

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215void __tcp_close(struct sock *sk, long timeout) { struct sk_buff *skb; int data_was_unread = 0; int state; // 设置SHUTDOWN_MASK表示recv和send都已经shutdown WRITE_ONCE(sk->sk_shutdown, SHUTDOWN_MASK); // TCP_LISTEN 状态处理 if (sk->sk_state == TCP_LISTEN) { // 设置close状态 tcp_set_state(sk, TCP_CLOSE); /* Special case. */ // 清理完成连接队列,并向每个socket发送rst报文 inet_csk_listen_stop(sk); goto adjudge_to_death; } /* We need to flush the recv. buffs. We do this only on the * descriptor close, not protocol-sourced closes, because the * reader process may not have drained the data yet! */ /*如果此时接收队列中不为空,即接收到的数据没有被用户进程读取, 这时需要将接受队列中的SKB包全都释放掉,释放的数据长度存储在data_was_unread中 */ while ((skb = __skb_dequeue(&sk->sk_receive_queue)) != NULL) { u32 len = TCP_SKB_CB(skb)->end_seq - TCP_SKB_CB(skb)->seq; if (TCP_SKB_CB(skb)->tcp_flags & TCPHDR_FIN) len--; data_was_unread += len; __kfree_skb(skb); } /* If socket has been already reset (e.g. in tcp_reset()) - kill it. */ // 如果 socket 本身就是 close 状态的话,直接跳到 adjudge_to_death 就好 if (sk->sk_state == TCP_CLOSE) goto adjudge_to_death; /* As outlined in RFC 2525, section 2.17, we send a RST here because * data was lost. To witness the awful effects of the old behavior of * always doing a FIN, run an older 2.1.x kernel or 2.0.x, start a bulk * GET in an FTP client, suspend the process, wait for the client to * advertise a zero window, then kill -9 the FTP client, wheee... * Note: timeout is always zero in such a case. */ if (unlikely(tcp_sk(sk)->repair)) { sk->sk_prot->disconnect(sk, 0); } else if (data_was_unread) { /* Unread data was tossed, zap the connection. */ /* 在存在未读数据情况下处理断开连接。如果关闭的套接口还有未读取的数据, 则发送RST而不是FIN给对方,因为FIN表示一切正常。 */ NET_INC_STATS(sock_net(sk), LINUX_MIB_TCPABORTONCLOSE); tcp_set_state(sk, TCP_CLOSE); tcp_send_active_reset(sk, sk->sk_allocation); } else if (sock_flag(sk, SOCK_LINGER) && !sk->sk_lingertime) { /* Check zero linger _after_ checking for unread data. */ /* 当需要关闭的TCP连接设置了so_linger延迟关闭,并且延迟时间设置为0, 直接丢掉所有的发送和接收队列中的报文,设置连接状态为TCP_CLOSE; 若此TCP不处于TCP_SYN_SENT状态,则发送reset报文给对端; 备注: 此项可知设置 SO_LINGER+时间为0可以调用close()用reset报文关闭连接; */ sk->sk_prot->disconnect(sk, 0); NET_INC_STATS(sock_net(sk), LINUX_MIB_TCPABORTONDATA); } else if (tcp_close_state(sk)) { /* 其他情况,如禁止SO_LINGER选项或启用了SO_LINGER选项且延时时间不为O, 则从当前状态转换到对应的状态,并返回得到转换后的动作; 如果是TCP_ACTION_FIN动作(即新的状态可以发送FIN段),则发送FIN段给对端, 将发送队列上未发送的段发送出去。 */ /* We FIN if the application ate all the data before * zapping the connection. */ /* RED-PEN. Formally speaking, we have broken TCP state * machine. State transitions: * * TCP_ESTABLISHED -> TCP_FIN_WAIT1 * TCP_SYN_RECV -> TCP_FIN_WAIT1 (forget it, it's impossible) * TCP_CLOSE_WAIT -> TCP_LAST_ACK * * are legal only when FIN has been sent (i.e. in window), * rather than queued out of window. Purists blame. * * F.e. "RFC state" is ESTABLISHED, * if Linux state is FIN-WAIT-1, but FIN is still not sent. * * The visible declinations are that sometimes * we enter time-wait state, when it is not required really * (harmless), do not send active resets, when they are * required by specs (TCP_ESTABLISHED, TCP_CLOSE_WAIT, when * they look as CLOSING or LAST_ACK for Linux) * Probably, I missed some more holelets. * --ANK * XXX (TFO) - To start off we don't support SYN+ACK+FIN * in a single packet! (May consider it later but will * probably need API support or TCP_CORK SYN-ACK until * data is written and socket is closed.) */ tcp_send_fin(sk); } /* 调用 sk_stream_wait_close () 进入阻塞状态。超时时间是 SO_LINGER 选项中设置的。 在给对端发送RST或FIN段后,等待套接口的关闭,直到TCP状态不为FIN_WAIT_1、CLOSING、LAST_ACK或等待超时; 也即是若如处于这3种状态时,进程会阻塞,直到超时; 因为这3种状态需要接收 ACK 的确认。 */ sk_stream_wait_close(sk, timeout); adjudge_to_death: /* 置套接口为DEAD状态,成为孤儿套接口,同时更新系统中孤儿套接口数。 在真正关闭之前,先处理接收到后备队列上的段。 */ state = sk->sk_state; sock_hold(sk); sock_orphan(sk); local_bh_disable(); bh_lock_sock(sk); /* remove backlog if any, without releasing ownership. */ __release_sock(sk); this_cpu_inc(tcp_orphan_count); /* 如果此时该传输控制块TCP状态已经为CLOSE,则无需再作处理了。 */ /* Have we already been destroyed by a softirq or backlog? */ if (state != TCP_CLOSE && sk->sk_state == TCP_CLOSE) goto out; /* This is a (useful) BSD violating of the RFC. There is a * problem with TCP as specified in that the other end could * keep a socket open forever with no application left this end. * We use a 1 minute timeout (about the same as BSD) then kill * our end. If they send after that then tough - BUT: long enough * that we won't make the old 4*rto = almost no time - whoops * reset mistake. * * Nope, it was not mistake. It is really desired behaviour * f.e. on http servers, when such sockets are useless, but * consume significant resources. Let's do it with special * linger2 option. --ANK */ // 处理从 FIN_WAIT_2 状态到 CLOSE 状态的转换 if (sk->sk_state == TCP_FIN_WAIT2) { struct tcp_sock *tp = tcp_sk(sk); if (tp->linger2 < 0) { /* 如果该传输控制块的TCP_LINGER2选项值小于0, 表示无需在FIN_WAIT_2状态等待转换到CLOSE状态, 而是立即设置为CLOSE状态,然后给对端发送RST段。 */ tcp_set_state(sk, TCP_CLOSE); tcp_send_active_reset(sk, GFP_ATOMIC); __NET_INC_STATS(sock_net(sk), LINUX_MIB_TCPABORTONLINGER); } else { /* 根据tcp_fin timeout()和往返时间获取需要保持FIN_WAIT_2状态的时长tmo。 如果大于60s(TCP_TIMEWAIT_LEN),则需要用FIN_WAIT_2定时器来处理,否则调用tcp_time_wait()由timewait控制块取代tcp_sock传输控制块,从FN_WAIT_2状态转换到CLOSE状态。 这里等待第三次挥手。 */ const int tmo = tcp_fin_time(sk); if (tmo > TCP_TIMEWAIT_LEN) { inet_csk_reset_keepalive_timer(sk, tmo - TCP_TIMEWAIT_LEN); } else { tcp_time_wait(sk, TCP_FIN_WAIT2, tmo); goto out; } } } if (sk->sk_state != TCP_CLOSE) { if (tcp_check_oom(sk, 0)) { tcp_set_state(sk, TCP_CLOSE); tcp_send_active_reset(sk, GFP_ATOMIC); __NET_INC_STATS(sock_net(sk), LINUX_MIB_TCPABORTONMEMORY); } else if (!check_net(sock_net(sk))) { /* Not possible to send reset; just close */ tcp_set_state(sk, TCP_CLOSE); } } if (sk->sk_state == TCP_CLOSE) { struct request_sock *req; req = rcu_dereference_protected(tcp_sk(sk)->fastopen_rsk, lockdep_sock_is_held(sk)); /* We could get here with a non-NULL req if the socket is * aborted (e.g., closed with unread data) before 3WHS * finishes. */ if (req) reqsk_fastopen_remove(sk, req, false); inet_csk_destroy_sock(sk); } /* Otherwise, socket is reprieved until protocol close. */ out: bh_unlock_sock(sk); local_bh_enable(); } -

以下是Linux2.6.20的close的实现流程图,上述代码是Linux6.2.9的实现,虽然有点出入,但是大框架差不多。

-

-

-

综上可知:

-

(a)当套接字处于 TCP_LISTEN 状态,则关闭套接字,清理完成连接队列,设置 TCP_CLOSE 状态,并向每个 socket 发送 RST 报文

-

(b)非 TCP_LISTEN 状态,先判断发送队列中是否有数据未被用户进程读取完,若有,说明异常关闭,设置 TCP_CLOSE 状态,给对端发送 RST 报文,不走四次挥手过程。

-

(c)若设置套接字选项 SOCK_LINGER,且超时时间为0,则执行断开连接,删除定时器,清除接收和发送队列上的数据,设置 TCP_CLOSE 状态,发送 RST 报文,不走四次挥手过程。

-

(d)若数据都被用户进程读完,把发送队列中的数据发送完后,发送 FIN 报文,走四次挥手。

-

11.3 收包函数 tcp_v4_rcv

-

Linux内核中TCP的收包函数为

tcp_v4_rcv,这里就以这个函数为起点来进行讲解。 -

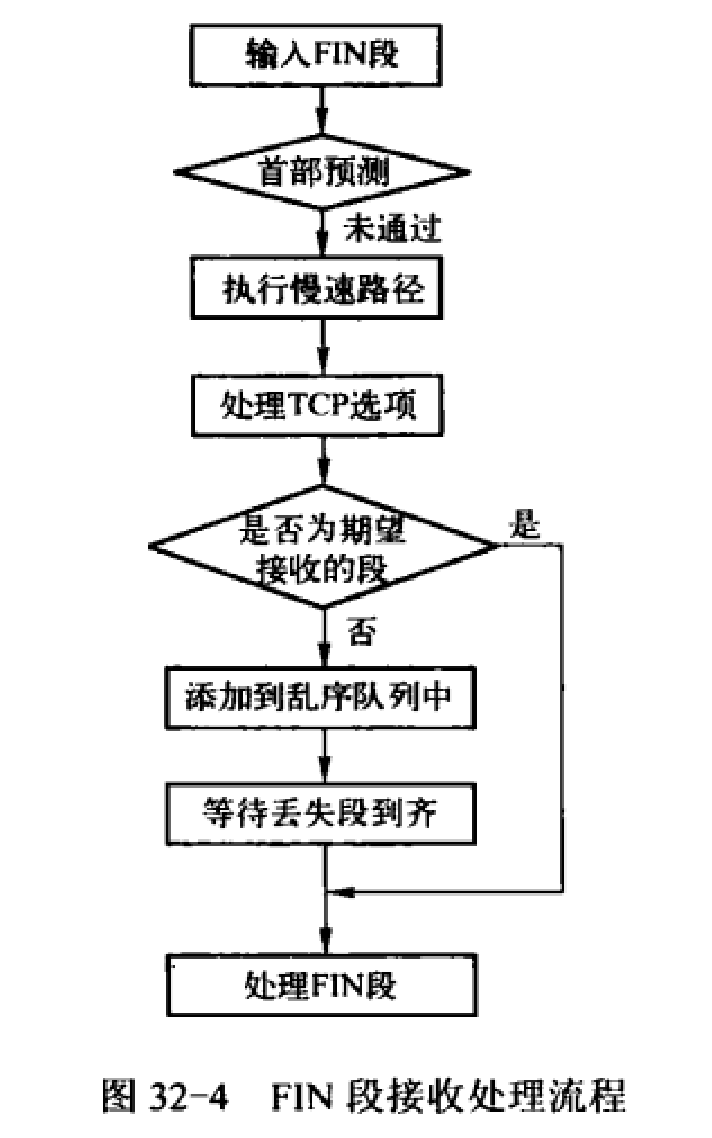

tcp_v4_rcv函数只要做以下几个工作:(1) 设置TCP_CB (2) 查找控制块 (3)根据控制块状态做不同处理,包括TCP_TIME_WAIT状态处理,TCP_NEW_SYN_RECV状态处理,TCP_LISTEN状态处理 (4) 接收TCP段;

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233 234 235 236 237 238 239 240 241 242 243 244 245 246 247 248 249 250int tcp_v4_rcv(struct sk_buff *skb) { struct net *net = dev_net(skb->dev); enum skb_drop_reason drop_reason; int sdif = inet_sdif(skb); int dif = inet_iif(skb); const struct iphdr *iph; const struct tcphdr *th; bool refcounted; struct sock *sk; int ret; drop_reason = SKB_DROP_REASON_NOT_SPECIFIED; if (skb->pkt_type != PACKET_HOST) goto discard_it; /* Count it even if it's bad */ __TCP_INC_STATS(net, TCP_MIB_INSEGS); if (!pskb_may_pull(skb, sizeof(struct tcphdr))) goto discard_it; th = (const struct tcphdr *)skb->data; if (unlikely(th->doff < sizeof(struct tcphdr) / 4)) { drop_reason = SKB_DROP_REASON_PKT_TOO_SMALL; goto bad_packet; } if (!pskb_may_pull(skb, th->doff * 4)) goto discard_it; /* An explanation is required here, I think. * Packet length and doff are validated by header prediction, * provided case of th->doff==0 is eliminated. * So, we defer the checks. */ if (skb_checksum_init(skb, IPPROTO_TCP, inet_compute_pseudo)) goto csum_error; th = (const struct tcphdr *)skb->data; iph = ip_hdr(skb); lookup: sk = __inet_lookup_skb(net->ipv4.tcp_death_row.hashinfo, skb, __tcp_hdrlen(th), th->source, th->dest, sdif, &refcounted); if (!sk) goto no_tcp_socket; process: // 首先判断 TIME_WAIT 状态 if (sk->sk_state == TCP_TIME_WAIT) goto do_time_wait; if (sk->sk_state == TCP_NEW_SYN_RECV) { struct request_sock *req = inet_reqsk(sk); bool req_stolen = false; struct sock *nsk; sk = req->rsk_listener; if (!xfrm4_policy_check(sk, XFRM_POLICY_IN, skb)) drop_reason = SKB_DROP_REASON_XFRM_POLICY; else drop_reason = tcp_inbound_md5_hash(sk, skb, &iph->saddr, &iph->daddr, AF_INET, dif, sdif); if (unlikely(drop_reason)) { sk_drops_add(sk, skb); reqsk_put(req); goto discard_it; } if (tcp_checksum_complete(skb)) { reqsk_put(req); goto csum_error; } if (unlikely(sk->sk_state != TCP_LISTEN)) { nsk = reuseport_migrate_sock(sk, req_to_sk(req), skb); if (!nsk) { inet_csk_reqsk_queue_drop_and_put(sk, req); goto lookup; } sk = nsk; /* reuseport_migrate_sock() has already held one sk_refcnt * before returning. */ } else { /* We own a reference on the listener, increase it again * as we might lose it too soon. */ sock_hold(sk); } refcounted = true; nsk = NULL; if (!tcp_filter(sk, skb)) { th = (const struct tcphdr *)skb->data; iph = ip_hdr(skb); tcp_v4_fill_cb(skb, iph, th); nsk = tcp_check_req(sk, skb, req, false, &req_stolen); } else { drop_reason = SKB_DROP_REASON_SOCKET_FILTER; } if (!nsk) { reqsk_put(req); if (req_stolen) { /* Another cpu got exclusive access to req * and created a full blown socket. * Try to feed this packet to this socket * instead of discarding it. */ tcp_v4_restore_cb(skb); sock_put(sk); goto lookup; } goto discard_and_relse; } nf_reset_ct(skb); if (nsk == sk) { reqsk_put(req); tcp_v4_restore_cb(skb); } else if (tcp_child_process(sk, nsk, skb)) { tcp_v4_send_reset(nsk, skb); goto discard_and_relse; } else { sock_put(sk); return 0; } } if (static_branch_unlikely(&ip4_min_ttl)) { /* min_ttl can be changed concurrently from do_ip_setsockopt() */ if (unlikely(iph->ttl < READ_ONCE(inet_sk(sk)->min_ttl))) { __NET_INC_STATS(net, LINUX_MIB_TCPMINTTLDROP); drop_reason = SKB_DROP_REASON_TCP_MINTTL; goto discard_and_relse; } } if (!xfrm4_policy_check(sk, XFRM_POLICY_IN, skb)) { drop_reason = SKB_DROP_REASON_XFRM_POLICY; goto discard_and_relse; } drop_reason = tcp_inbound_md5_hash(sk, skb, &iph->saddr, &iph->daddr, AF_INET, dif, sdif); if (drop_reason) goto discard_and_relse; nf_reset_ct(skb); if (tcp_filter(sk, skb)) { drop_reason = SKB_DROP_REASON_SOCKET_FILTER; goto discard_and_relse; } th = (const struct tcphdr *)skb->data; iph = ip_hdr(skb); tcp_v4_fill_cb(skb, iph, th); skb->dev = NULL; // 开始调用tcp_v4_do_rcv if (sk->sk_state == TCP_LISTEN) { ret = tcp_v4_do_rcv(sk, skb); goto put_and_return; } sk_incoming_cpu_update(sk); bh_lock_sock_nested(sk); tcp_segs_in(tcp_sk(sk), skb); ret = 0; if (!sock_owned_by_user(sk)) { ret = tcp_v4_do_rcv(sk, skb); } else { if (tcp_add_backlog(sk, skb, &drop_reason)) goto discard_and_relse; } bh_unlock_sock(sk); put_and_return: if (refcounted) sock_put(sk); return ret; no_tcp_socket: drop_reason = SKB_DROP_REASON_NO_SOCKET; if (!xfrm4_policy_check(NULL, XFRM_POLICY_IN, skb)) goto discard_it; tcp_v4_fill_cb(skb, iph, th); if (tcp_checksum_complete(skb)) { csum_error: drop_reason = SKB_DROP_REASON_TCP_CSUM; trace_tcp_bad_csum(skb); __TCP_INC_STATS(net, TCP_MIB_CSUMERRORS); bad_packet: __TCP_INC_STATS(net, TCP_MIB_INERRS); } else { tcp_v4_send_reset(NULL, skb); } discard_it: SKB_DR_OR(drop_reason, NOT_SPECIFIED); /* Discard frame. */ kfree_skb_reason(skb, drop_reason); return 0; discard_and_relse: sk_drops_add(sk, skb); if (refcounted) sock_put(sk); goto discard_it; do_time_wait: if (!xfrm4_policy_check(NULL, XFRM_POLICY_IN, skb)) { drop_reason = SKB_DROP_REASON_XFRM_POLICY; inet_twsk_put(inet_twsk(sk)); goto discard_it; } tcp_v4_fill_cb(skb, iph, th); if (tcp_checksum_complete(skb)) { inet_twsk_put(inet_twsk(sk)); goto csum_error; } switch (tcp_timewait_state_process(inet_twsk(sk), skb, th)) { case TCP_TW_SYN: { struct sock *sk2 = inet_lookup_listener( net, net->ipv4.tcp_death_row.hashinfo, skb, __tcp_hdrlen(th), iph->saddr, th->source, iph->daddr, th->dest, inet_iif(skb), sdif); if (sk2) { inet_twsk_deschedule_put(inet_twsk(sk)); sk = sk2; tcp_v4_restore_cb(skb); refcounted = false; goto process; } } /* to ACK */ fallthrough; case TCP_TW_ACK: tcp_v4_timewait_ack(sk, skb); break; case TCP_TW_RST: tcp_v4_send_reset(sk, skb); inet_twsk_deschedule_put(inet_twsk(sk)); goto discard_it; case TCP_TW_SUCCESS:; } goto discard_it; } -

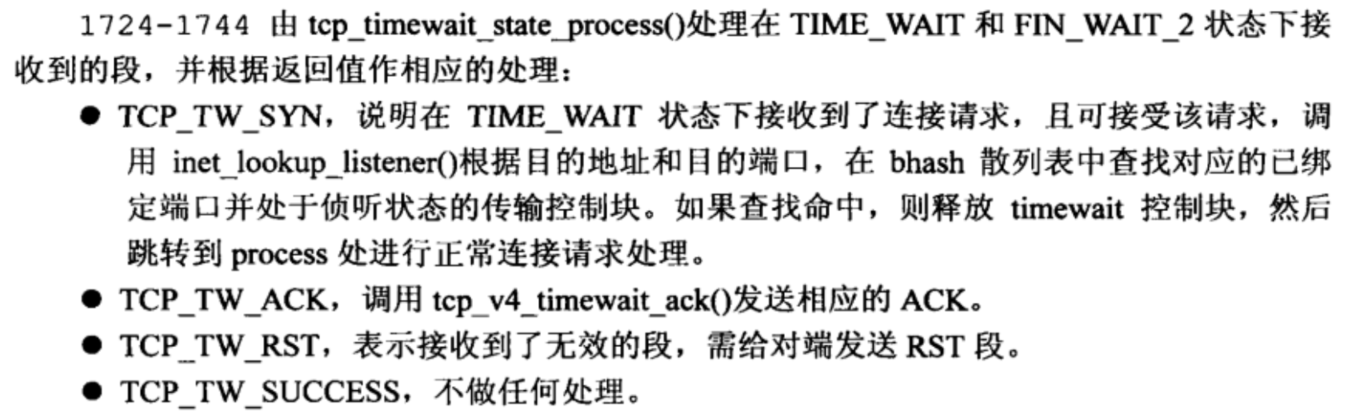

(1) 在找到对应的套接口后,内核会首先判断其是否是TIME_WAIT套接口,因为这种套接口不能处理报文,因此要放到最前面来处理。从上面可以看出,对于TIME_WAIT真正的处理函数为

tcp_timewait_state_process,根据该函数的返回值会做出不同的行为。这个函数主要用来处理在TIME_WAIT状态下,收到各种类型的报文(SYN、ACK、新数据等)需要做出的响应行为。其处理过程为tcp_v4_rcv -> tcp_timewait_state_process。

- 这里有个点需要说明一下,对于FIN_WAIT_2状态,其实并不在tcp_timewait_state_process函数中进行处理;但是对于状态为TIME_WAIT子状态为FIN_WAIT_2 的状态,确实在tcp_timewait_state_process函数中处理。

-

(2) 对于非TIME_WAIT且非ESTABLISHED状态下的套接口,其处理过程会通过

tcp_v4_rcv -> tcp_v4_do_rcv -> tcp_rcv_state_process来进入到 tcp_rcv_state_process 函数中,来做出相应的行为。-

tcp_v4_rcv判断状态为LISTEN时会直接调用tcp_v4_do_rcv;

-

如果是其他状态,将TCP包投递到目的套接字进行接收处理。如果套接字未被上锁则调用tcp_v4_do_rcv。当套接字正被用户锁定,TCP包将暂时排入该套接字的后备队列(sk_add_backlog)。

-

这里需要着重说明,对于 FIN_WAIT_2 状态,并不在

tcp_timewait_state_process函数进行处理,而是在接收到FIN报文后的tcp_fin函数中处理,处理完成后即变成真正的TIME_WAIT状态;如果没有收到FIN报文,FIN_WAIT_2 也会在定时器超时后自动转为子状态为FIN_WAIT_2的TIME_WAIT状态以减少资源开销。-

tcp_v4_rcv |-tcp_v4_do_rcv |-tcp_rcv_state_process |-tcp_data_queue |-tcp_fin

-

-

-

(3) 对于如果状态是ESTABLISHED,其处理过程会通过

tcp_v4_rcv -> tcp_v4_do_rcv -> tcp_rcv_established来进入到 tcp_rcv_established函数中,来做出相应的行为。

11.4 主动关闭源码分析

-

-

(1)第一次挥手 tcp_send_fin,发送FIN报文

-

当一段完成数据发送任务之后,应用层即可调用 close系统调用 发送一个 FIN 报文来终止该方向上的连接,当另一端收到这个 FIN 后,必须通知应用层,另一端已经终止了数据传送。而 close 系统调用在传输层接收的实现就是 tcp_close,最终落到第一次挥手的就是 tcp_send_fin 函数。

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56/* Location: net/ipv4/tcp_output.c Function: Send a FIN. The caller locks the socket for us. We should try to send a FIN packet really hard, but eventually give up. Parameter: sk: 传输控制块 */ void tcp_send_fin(struct sock *sk) { /* 取得 sock 发送队列的最后一个元素,如果为空,返回 null*/ struct sk_buff *skb, *tskb = tcp_write_queue_tail(sk); struct tcp_sock *tp = tcp_sk(sk); /* 这里做了一些优化, 如果发送队列的末尾还有段没有发出去,则利用该段发送 * FIN。 */ if (tskb && (tcp_send_head(sk) || tcp_under_memory_pressure(sk))) { /* 如果当前正在发送的队列不为空,或者当前 TCP 处于内存压力下 * (值得进一步分析),则进行该优化 */ coalesce: TCP_SKB_CB(tskb)->tcp_flags |= TCPHDR_FIN; // 递增序列号 TCP_SKB_CB(tskb)->end_seq++; tp->write_seq++; /* 队头为空 */ if (!tcp_send_head(sk)) { /* This means tskb was already sent. * Pretend we included the FIN on previous transmit. * We need to set tp->snd_nxt to the value it would have * if FIN had been sent. This is because retransmit path * does not change tp->snd_nxt. */ tp->snd_nxt++; return; } } else { /* 为封包分配空间 */ skb = alloc_skb_fclone(MAX_TCP_HEADER, sk->sk_allocation); if (unlikely(!skb)) { /* 如果分配不到空间,且队尾还有未发送的包,利用该包发出 FIN。 */ if (tskb) goto coalesce; return; } skb_reserve(skb, MAX_TCP_HEADER); sk_forced_mem_schedule(sk, skb->truesize); /* FIN eats a sequence byte, write_seq advanced by tcp_queue_skb(). */ /* 构造一个 FIN 包,并加入发送队列。 */ tcp_init_nondata_skb(skb, tp->write_seq, TCPHDR_ACK | TCPHDR_FIN); tcp_queue_skb(sk, skb); } __tcp_push_pending_frames(sk, tcp_current_mss(sk), TCP_NAGLE_OFF); } -

tcp_send_fin() 的实现比较简单,过程大致如下:

- 由于发送FN无需占用额外的负载, 因此如果发送队列不空, 则在发送队列的最后一个TCP段上设置FN标志。但FIN标志会占用一个序号, 因此需递增序号。

- 如果发送队列为空, 则需构造一个新的TCP段, 但该TCP段不需要负荷, 只需要TCP首部即可。设置相应的值, 然后添加到发送队列中。

- 最后关闭Nagle算法, 立即将发送队列上未发送的段(包括FN段)全部发送出去。

-

在函数的最后,将所有的剩余数据一口气发出去,完成发送 FIN 包的过程。至此,主动关闭过程的第一次握手完成。此时处于FIN_WAIT1状态。

-

(2)第二次挥手,接收ACK报文

-

tcp_send_fin()函数调用后,会调用sk_stream_wait_close阻塞等待接收ACK。

-

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33#define sk_wait_event(__sk, __timeo, __condition) \ ({ \ int rc; \ release_sock(__sk); \ rc = __condition; \ if (!rc) { \ *(__timeo) = schedule_timeout(*(__timeo)); \ } \ lock_sock(__sk); \ rc = __condition; \ rc; \ }) void sk_stream_wait_close(struct sock *sk, long timeout) { if (timeout) { DEFINE_WAIT(wait); do { prepare_to_wait(sk->sk_sleep, &wait, TASK_INTERRUPTIBLE); /*sk_stream_closing(sk),该函数判断的是套接口当前状态, 如果处于TCPF_FIN_WAIT1 或 TCPF_CLOSING 或 TCPF_LAST_ACK 则返回 1*/ if (sk_wait_event(sk, &timeout, !sk_stream_closing(sk))) break; } while (!signal_pending(current) && timeout); finish_wait(sk->sk_sleep, &wait); } } static inline int sk_stream_closing(struct sock *sk) { return (1 << sk->sk_state) & (TCPF_FIN_WAIT1 | TCPF_CLOSING | TCPF_LAST_ACK); } -

在阻塞期间,若接收到报文,则处理报文,该报文在首先存放在 back_log 队列中。之所以在 back_log 队列中,是因为网络层模块在将一个数据包传递给传输层模块处理时(tcp_v4_rcv),如果当前对应的套接字正忙,则将数据包插入到 sock 结构 back_log 队列中。但插入该队列中的数据包并不能算是被接收,该队列中的数据包需要进行一系列处理后插入receive_queue 接收队列中时,才算是完成接收。而 **release_sock 函数 **就是从 back_log 中取数据包重新调用 tcp_v4_rcv 函数 对数据包进行接收。所谓 back_log 队列只是数据包暂居之所,不可久留,所以也就必须对这个队列中数据包尽快进行处理,那么也就表示必须对 release_sock 函数进行频繁调用。

-

调用过程如下图

-

1 2 3 4 5 6 7 8sk_stream_wait_close -> sk_wait_event -> release_sock(__sk) -> __release_sock(sk); -> sk->sk_backlog_rcv(sk, skb); -> tcp_v4_rcv -> tcp_v4_do_rcv -> tcp_rcv_state_process -

最终会调用 tcp_rcv_state_process 函数来处理接收信息。

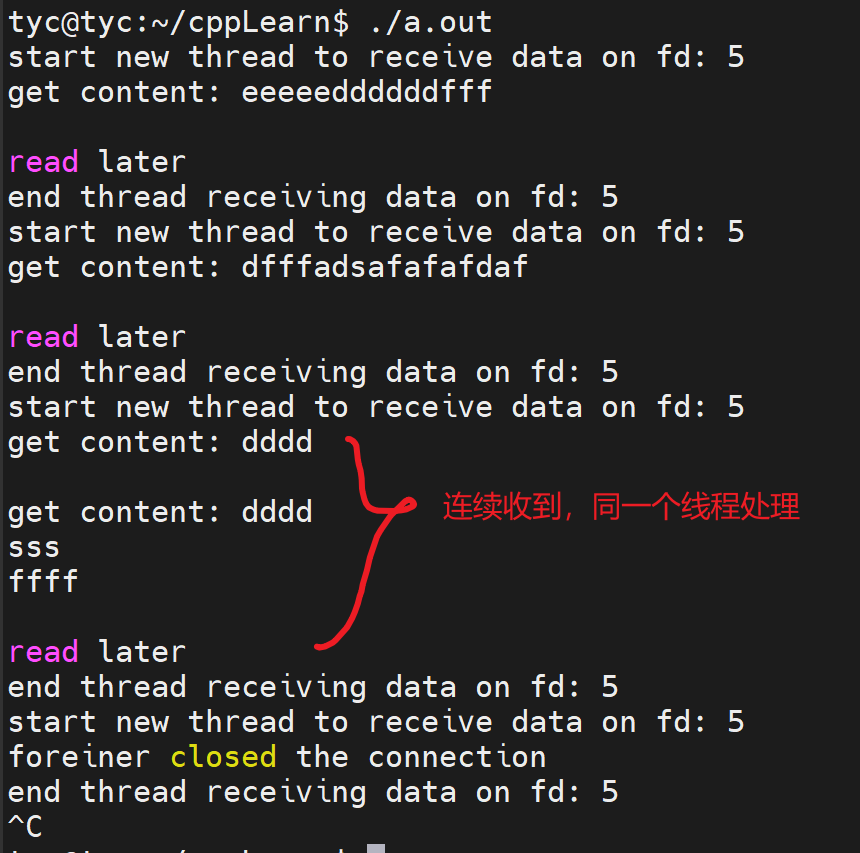

-